Version en français à la suite.

1 Spatial Statistics in Ecology

BIOS² hosted an online training session about statistical analysis of spatial data in ecology, led by Pr. Philippe Marchand (UQAT). This 12-hour training was conducted in 4 sessions: January 12, 14, 19 & 21 (2021) from 1:00 to 4:00 pm EST.

The content included three types of spatial statistical analyses and their applications to ecology: (1) point pattern analysis to study the distribution of individuals or events in space; (2) geostatistical models to represent the spatial correlation of variables sampled at geolocated points; and (3) areal data models, which apply to measurements taken on areas in space and model spatial relationships as networks of neighbouring regions. The training also included practical exercises using the R statistical programming environment.

Philippe Marchand is a professor in ecology and biostatistics at Institut de recherche sur les forêts, Université du Québec en Abitibi-Témiscamingue (UQAT) and BIOS² academic member. His research focuses on modeling processes that influence the spatial distribution of populations, including: seed dispersal and seedling establishment, animal movement, and the spread of forest diseases.

If you wish to consult the lesson materials and follow the exercises at your own pace, you can access them through this link. Basic knowledge of linear regression models and experience fitting them in R is recommended. Original repository can be found here.

Course outline

2 Introduction to spatial statistics

Types of spatial analyses

In this training, we will discuss three types of spatial analyses: point pattern analysis, geostatistical models and models for areal data.

In point pattern analysis, we have point data representing the position of individuals or events in a study area and we assume that all individuals or events have been identified in that area. That analysis focuses on the distribution of the positions of the points themselves. Here are some typical questions for the analysis of point patterns:

Are the points randomly arranged or clustered?

Are two types of points arranged independently?

Geostatistical models represent the spatial distribution of continuous variables that are measured at certain sampling points. They assume that measurements of those variables at different points are correlated as a function of the distance between the points. Applications of geostatistical models include the smoothing of spatial data (e.g., producing a map of a variable over an entire region based on point measurements) and the prediction of those variables for non-sampled points.

Areal data are measurements taken not at points, but for regions of space represented by polygons (e.g. administrative divisions, grid cells). Models representing these types of data define a network linking each region to its neighbours and include correlations in the variable of interest between neighbouring regions.

Stationarity and isotropy

Several spatial analyses assume that the variables are stationary in space. As with stationarity in the time domain, this property means that summary statistics (mean, variance and correlations between measures of a variable) do not vary with translation in space. For example, the spatial correlation between two points may depend on the distance between them, but not on their absolute position.

In particular, there cannot be a large-scale trend (often called gradient in a spatial context), or this trend must be taken into account before modelling the spatial correlation of residuals.

In the case of point pattern analysis, stationarity (also called homogeneity) means that point density does not follow a large-scale trend.

In a isotropic statistical model, the spatial correlations between measurements at two points depend only on the distance between the points, not on the direction. In this case, the summary statistics do not change under a spatial rotation of the data.

Georeferenced data

Environmental studies increasingly use data from geospatial data sources, i.e. variables measured over a large part of the globe (e.g. climate, remote sensing). The processing of these data requires concepts related to Geographic Information Systems (GIS), which are not covered in this workshop, where we focus on the statistical aspects of spatially varying data.

The use of geospatial data does not necessarily mean that spatial statistics are required. For example, we will often extract values of geographic variables at study points to explain a biological response observed in the field. In this case, the use of spatial statistics is only necessary when there is a spatial correlation in the residuals, after controlling for the effect of the predictors.

3 Point pattern analysis

Point pattern and point process

A point pattern describes the spatial position (most often in 2D) of individuals or events, represented by points, in a given study area, often called the observation “window”.

It is assumed that each point has a negligible spatial extent relative to the distances between the points. More complex methods exist to deal with spatial patterns of objects that have a non-negligible width, but this topic is beyond the scope of this workshop.

A point process is a statistical model that can be used to simulate point patterns or explain an observed point pattern.

Complete spatial randomness

Complete spatial randomness (CSR) is one of the simplest point patterns, which serves as a null model for evaluating the characteristics of real point patterns. In this pattern, the presence of a point at a given position is independent of the presence of points in a neighbourhood.

The process creating this pattern is a homogeneous Poisson process. According to this model, the number of points in any area \(A\) follows a Poisson distribution: \(N(A) \sim \text{Pois}(\lambda A)\), where \(\lambda\) is the intensity of the process (i.e. the density of points per unit area). \(N\) is independent between two disjoint regions, no matter how those regions are defined.

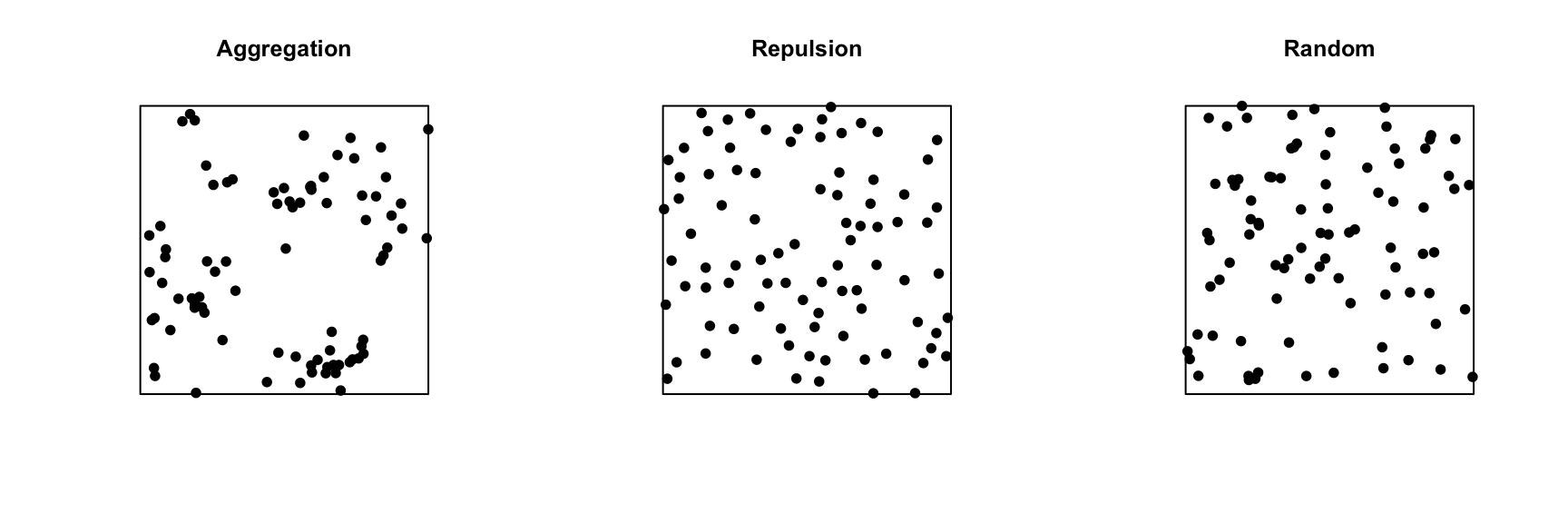

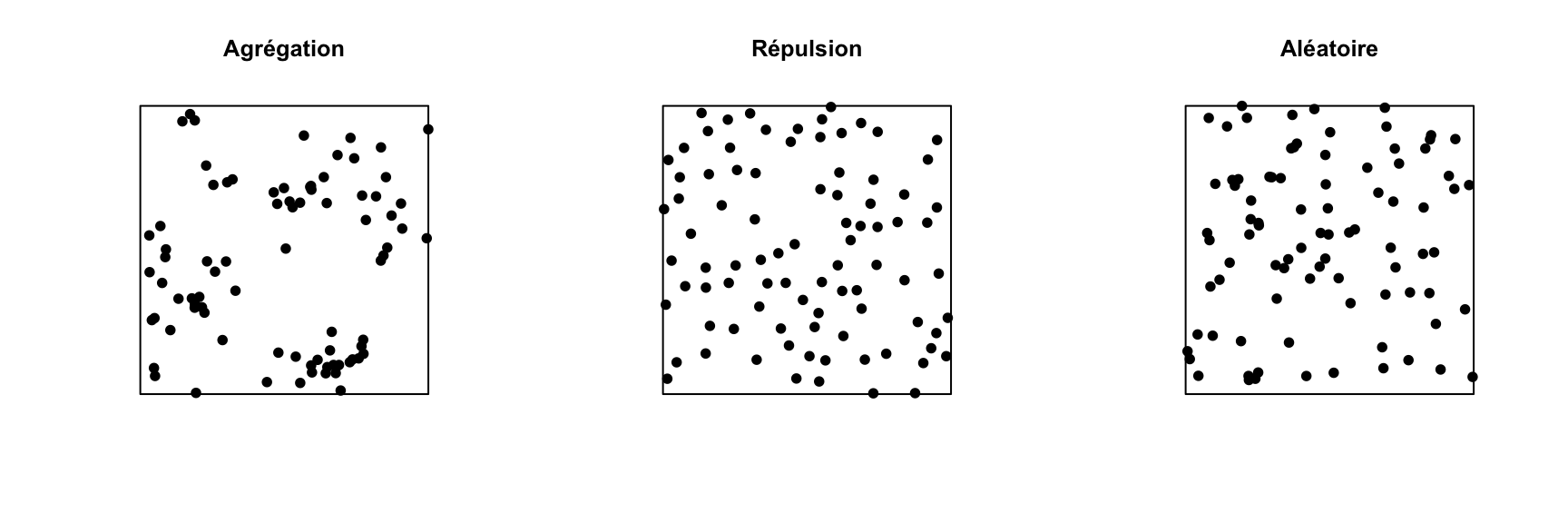

In the graph below, only the pattern on the right is completely random. The pattern on the left shows point aggregation (higher probability of observing a point close to another point), while the pattern in the center shows repulsion (low probability of observing a point very close to another).

Exploratory or inferential analysis for a point pattern

Several summary statistics are used to describe the characteristics of a point pattern. The simplest is the intensity \(\lambda\), which as mentioned above represents the density of points per unit area. If the point pattern is heterogeneous, the intensity is not constant, but depends on the position: \(\lambda(x, y)\).

Compared to intensity, which is a first-order statistic, second-order statistics describe how the probability of the presence of a point in a region depends on the presence of other points. The Ripley’s \(K\) function presented in the next section is an example of a second-order summary statistic.

Statistical inferences on point patterns usually consist of testing the hypothesis that the point pattern corresponds to a given null model, such as CSR or a more complex null model. Even for the simplest null models, we rarely know the theoretical distribution for a summary statistic of the point pattern under the null model. Hypothesis tests on point patterns are therefore performed by simulation: a large number of point patterns are simulated from the null model and the distribution of the summary statistics of interest for these simulations is compared to their values for the observed point pattern.

Ripley’s K function

Ripley’s K function \(K(r)\) is defined as the mean number of points within a circle of radius \(r\) around a point in the pattern, standardized by the intensity \(\lambda\).

Under the CSR null model, the mean number of points in any circle of radius \(r\) is \(\lambda \pi r^2\), thus in theory \(K(r) = \pi r^2\) for that model. A higher value of \(K(r)\) means that there is an aggregation of points at the scale \(r\), whereas a lower value means that there is repulsion.

In practice, \(K(r)\) is estimated for a specific point pattern by the equation:

\[ K(r) = \frac{A}{n(n-1)} \sum_i \sum_{j > i} I \left( d_{ij} \le r \right) w_{ij}\]

where \(A\) is the area of the observation window and \(n\) is the number of points in the pattern, so \(n(n-1)\) is the number of distinct pairs of points. We take the sum for all pairs of points of the indicator function \(I\), which takes a value of 1 if the distance between points \(i\) and \(j\) is less than or equal to \(r\). Finally, the term \(w_{ij}\) is used to give extra weight to certain pairs of points to account for edge effects, as discussed in the next section.

For example, the graphs below show the estimated \(K(r)\) function for the patterns shown above, for values of \(r\) up to 1/4 of the window width. The red dashed curve shows the theoretical value for CSR and the gray area is an “envelope” produced by 99 simulations of that null pattern. The aggregated pattern shows an excess of neighbours up to \(r = 0.25\) and the pattern with repulsion shows a significant deficit of neighbours for small values of \(r\).

In addition to \(K\), there are other statistics to describe the second-order properties of point patterns, such as the mean distance between a point and its nearest \(N\) neighbours. You can refer to the Wiegand and Moloney (2013) textbook in the references to learn more about different summary statistics for point patterns.

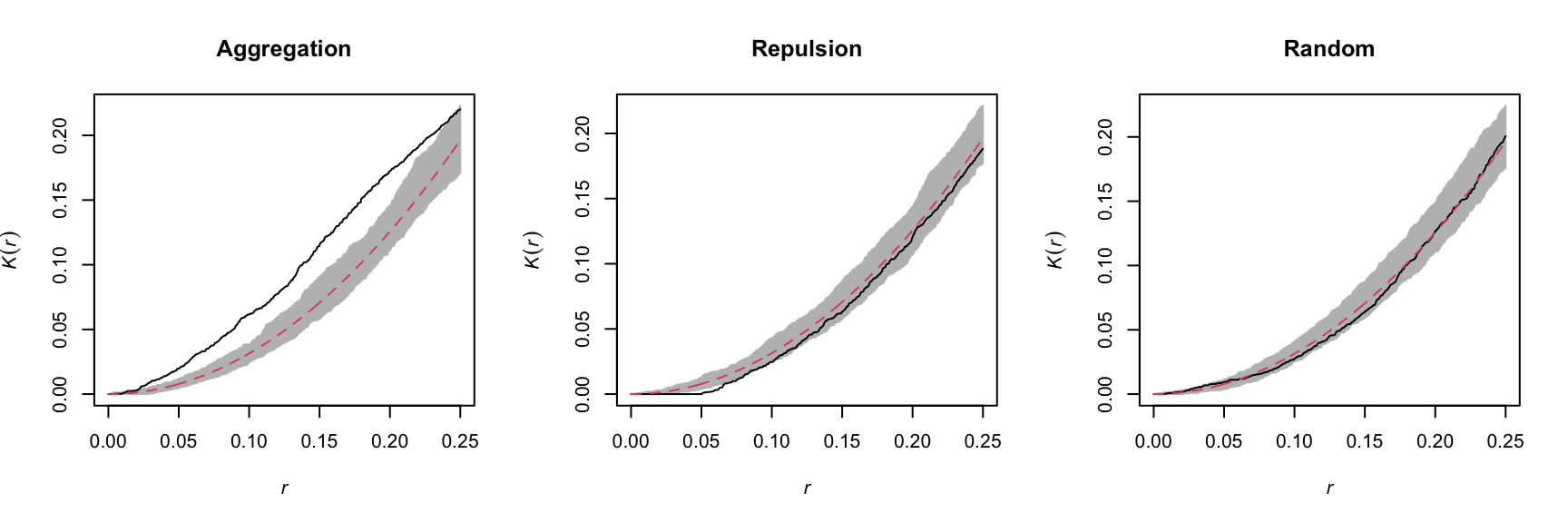

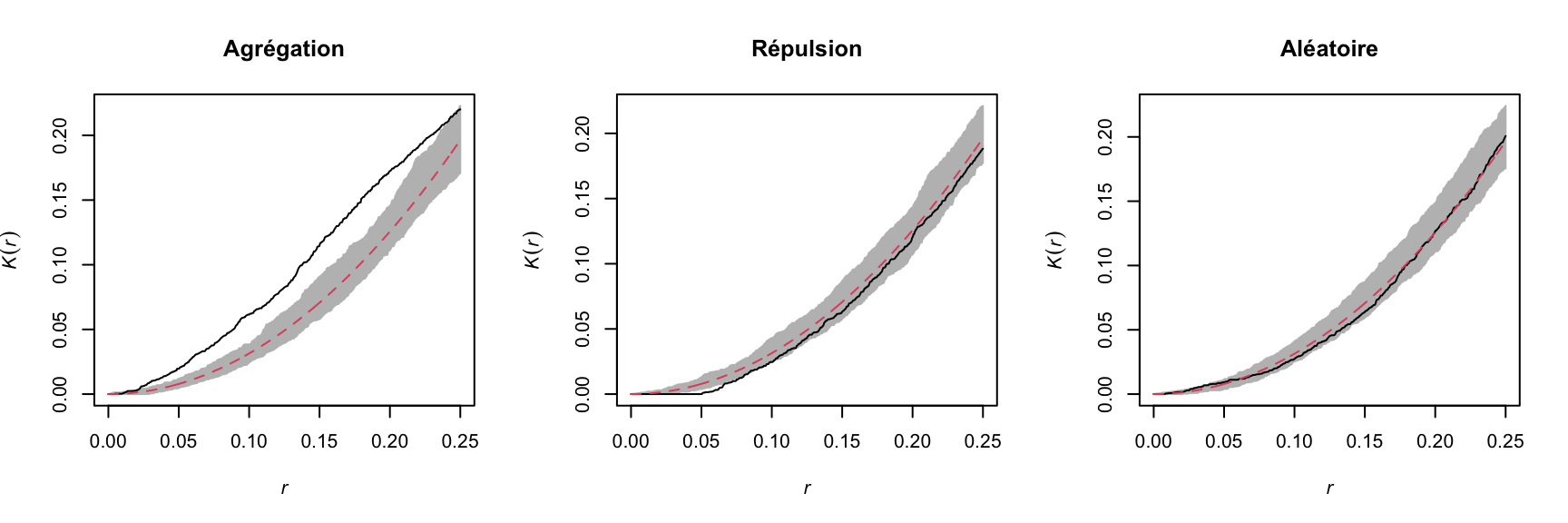

Edge effects

In the context of point pattern analysis, edge effects are due to the fact that we have incomplete knowledge of the neighbourhood of points near the edge of the observation window, which can induce a bias in the calculation of statistics such as Ripley’s \(K\).

Different methods have been developed to correct the bias due to edge effects. In Ripley’s edge correction method, the contribution of a neighbour \(j\) located at a distance \(r\) from a point \(i\) receives a weight \(w_{ij} = 1/\phi_i(r)\), where \(\phi_i(r)\) is the fraction of the circle of radius \(r\) around \(i\) contained in the observation window. For example, if 2/3 of the circle is in the window, this neighbour counts as 3/2 neighbours in the calculation of a statistic like \(K\).

Ripley’s method is one of the simplest to correct for edge effects, but is not necessarily the most efficient; in particular, larger weights given to certain pairs of points tend to increase the variance of the calculated statistic. Other correction methods are presented in specialized textbooks, such as Wiegand and Moloney (2013).

Example

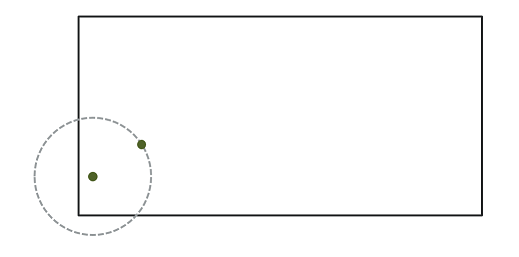

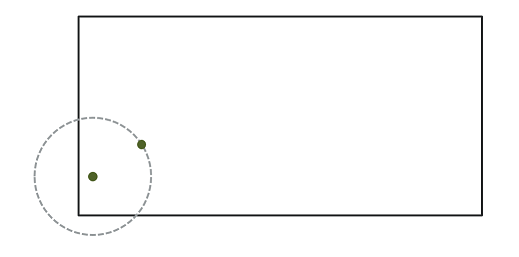

For this example, we use the dataset semis_xy.csv, which represents the \((x, y)\) coordinates for seedlings of two species (sp, B = birch and P = poplar) in a 15 x 15 m plot.

semis <- read.csv("data/semis_xy.csv")

head(semis) x y sp

1 14.73 0.05 P

2 14.72 1.71 P

3 14.31 2.06 P

4 14.16 2.64 P

5 14.12 4.15 B

6 9.88 4.08 BThe spatstat package provides tools for point pattern analysis in R. The first step consists in transforming our data frame into a ppp object (point pattern) with the function of the same name. In this function, we specify which columns contain the coordinates x and y as well as the marks, which here will be the species codes. We also need to specify an observation window (window) using the owin function, where we provide the plot limits in x and y.

library(spatstat)

semis <- ppp(x = semis$x, y = semis$y, marks = as.factor(semis$sp),

window = owin(xrange = c(0, 15), yrange = c(0, 15)))

semisMarked planar point pattern: 281 points

Multitype, with levels = B, P

window: rectangle = [0, 15] x [0, 15] unitsMarks can be numeric or categorical. Note that for categorical marks as is the case here, the variable must be explicitly converted to a factor.

The plot function applied to a point pattern shows a diagram of the pattern.

plot(semis)

The intensity function calculates the density of points of each species by unit area (here, by \(m^2\)).

intensity(semis) B P

0.6666667 0.5822222 To first analyze the distribution of each species separately, we split the pattern with split. Since the pattern contains categorical marks, it is automatically split according to the values of those marks. The result is a list of two point patterns.

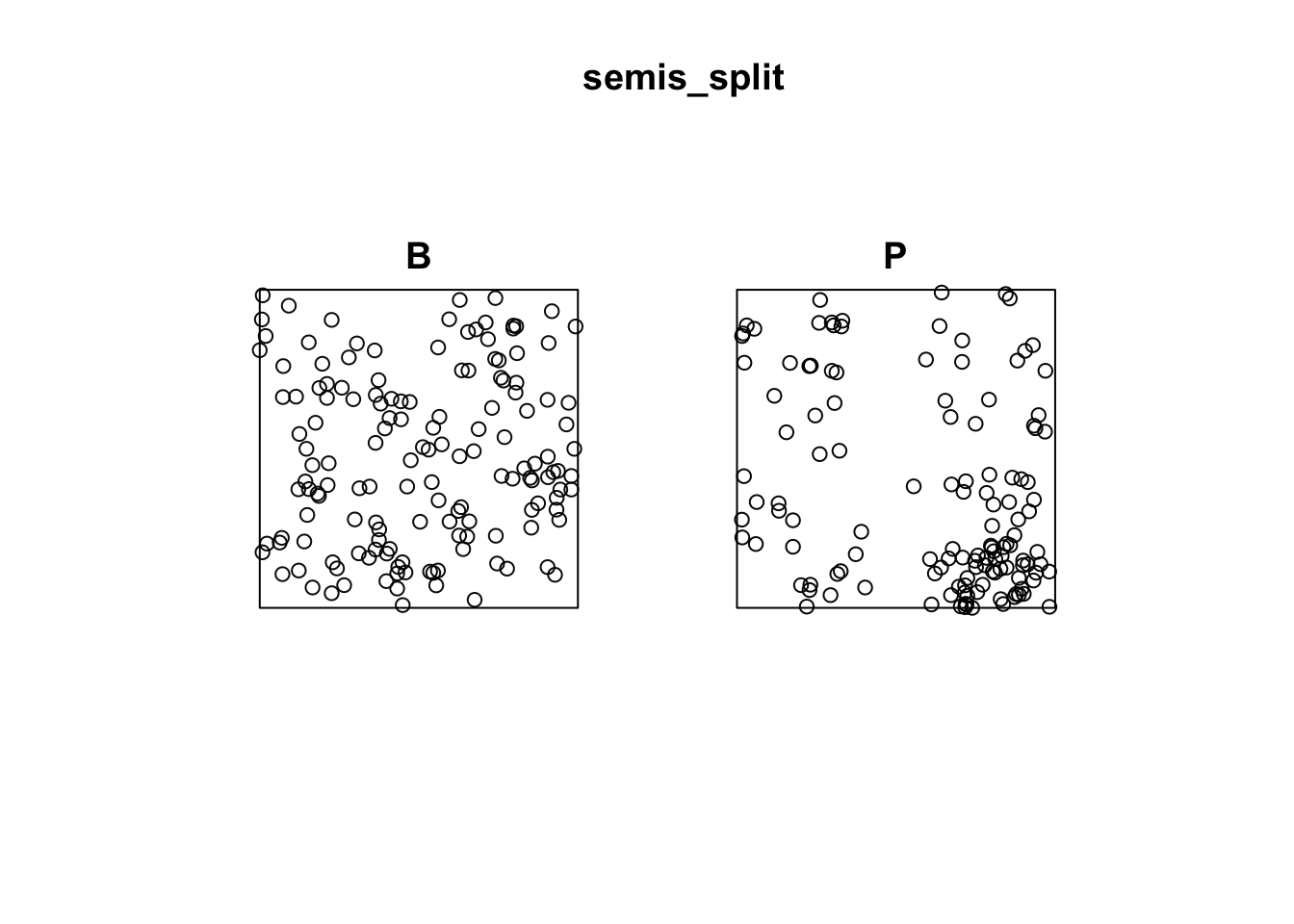

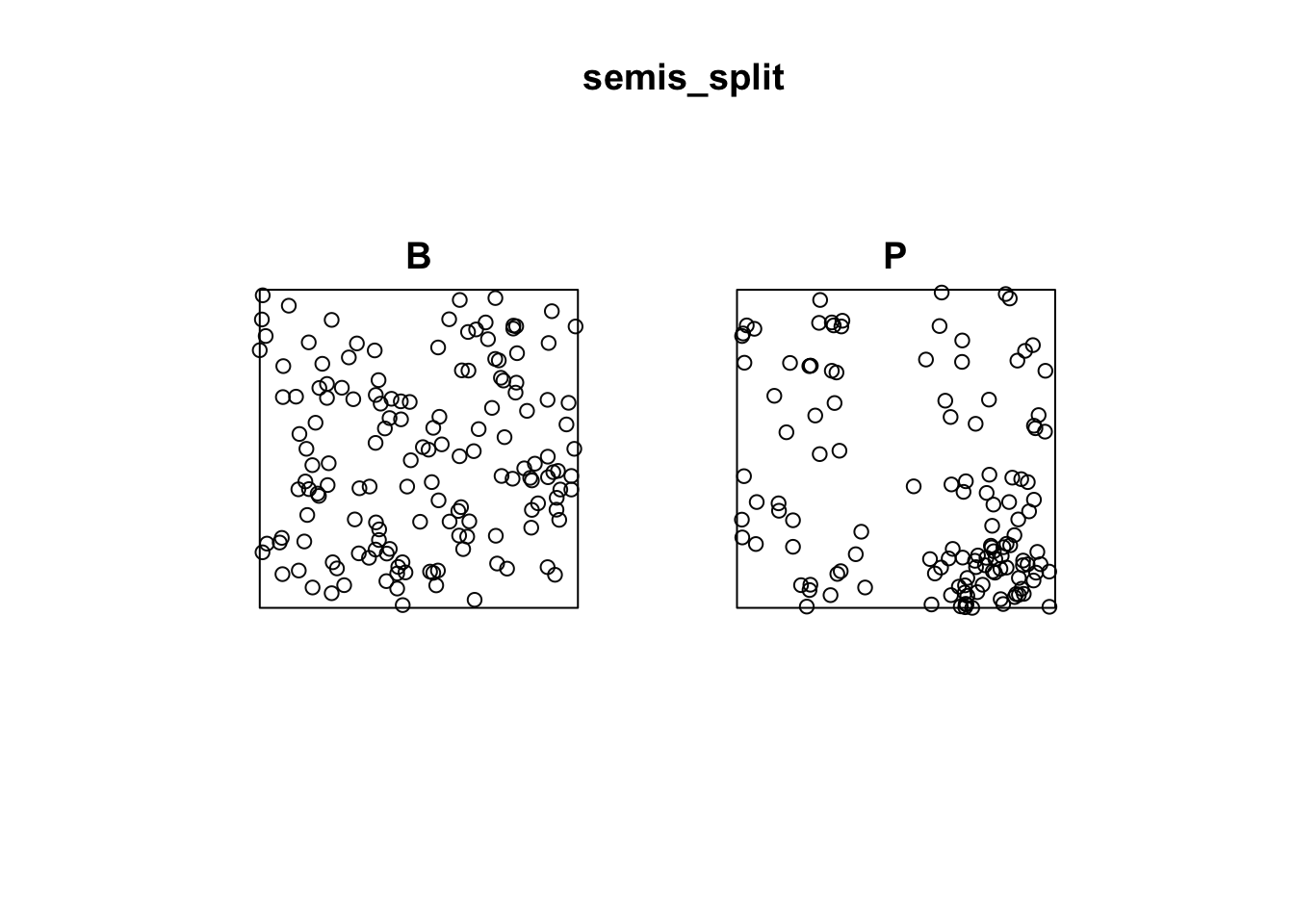

semis_split <- split(semis)

plot(semis_split)

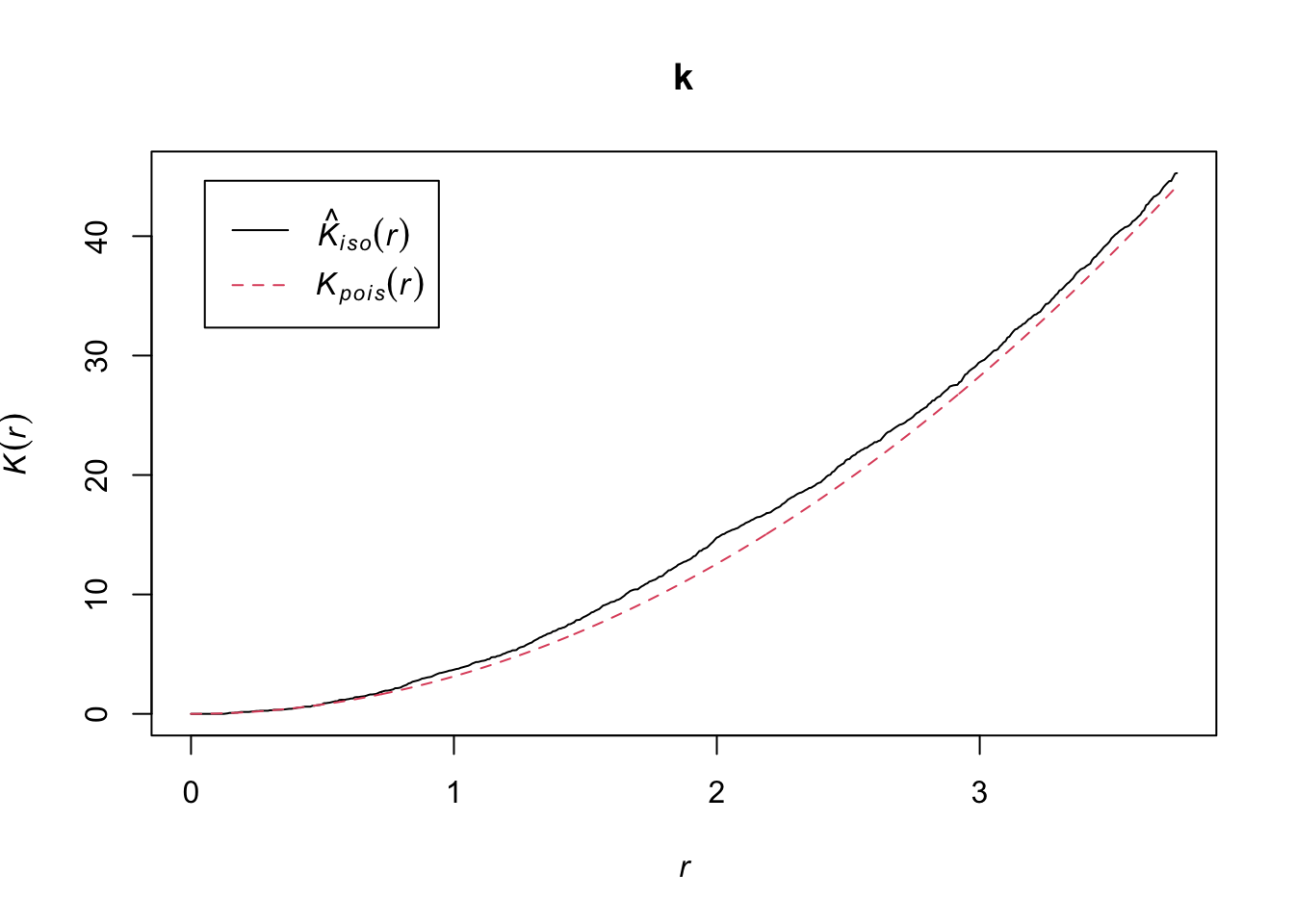

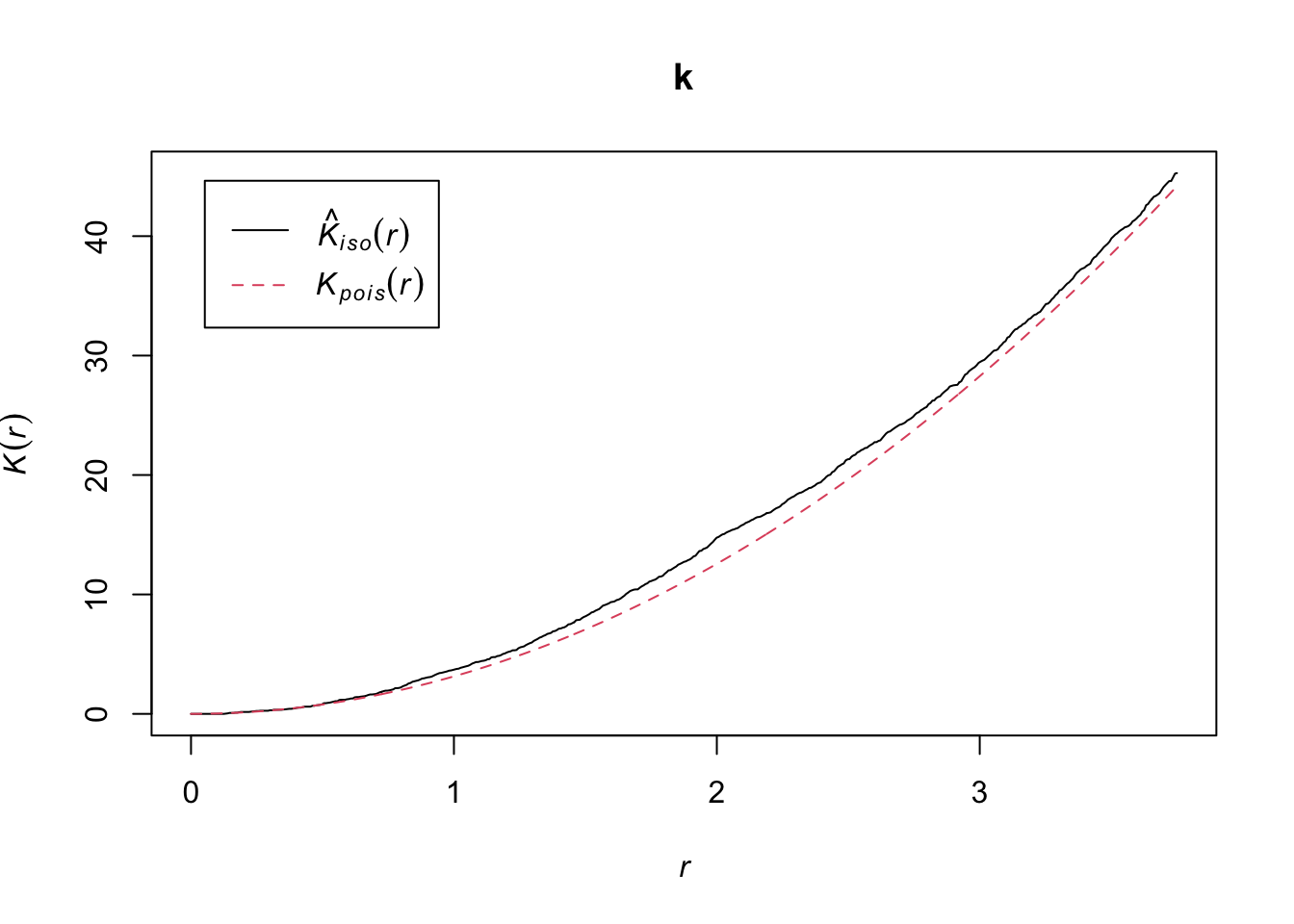

The Kest function calculates Ripley’s \(K\) for a series of distances up to (by default) 1/4 of the width of the window. Here we apply it to the first pattern (birch) by choosing semis_split[[1]]. Note that double square brackets are necessary to choose an item from a list in R.

The argument correction = "iso" tells the function to apply Ripley’s correction for edge effects.

k <- Kest(semis_split[[1]], correction = "iso")

plot(k)

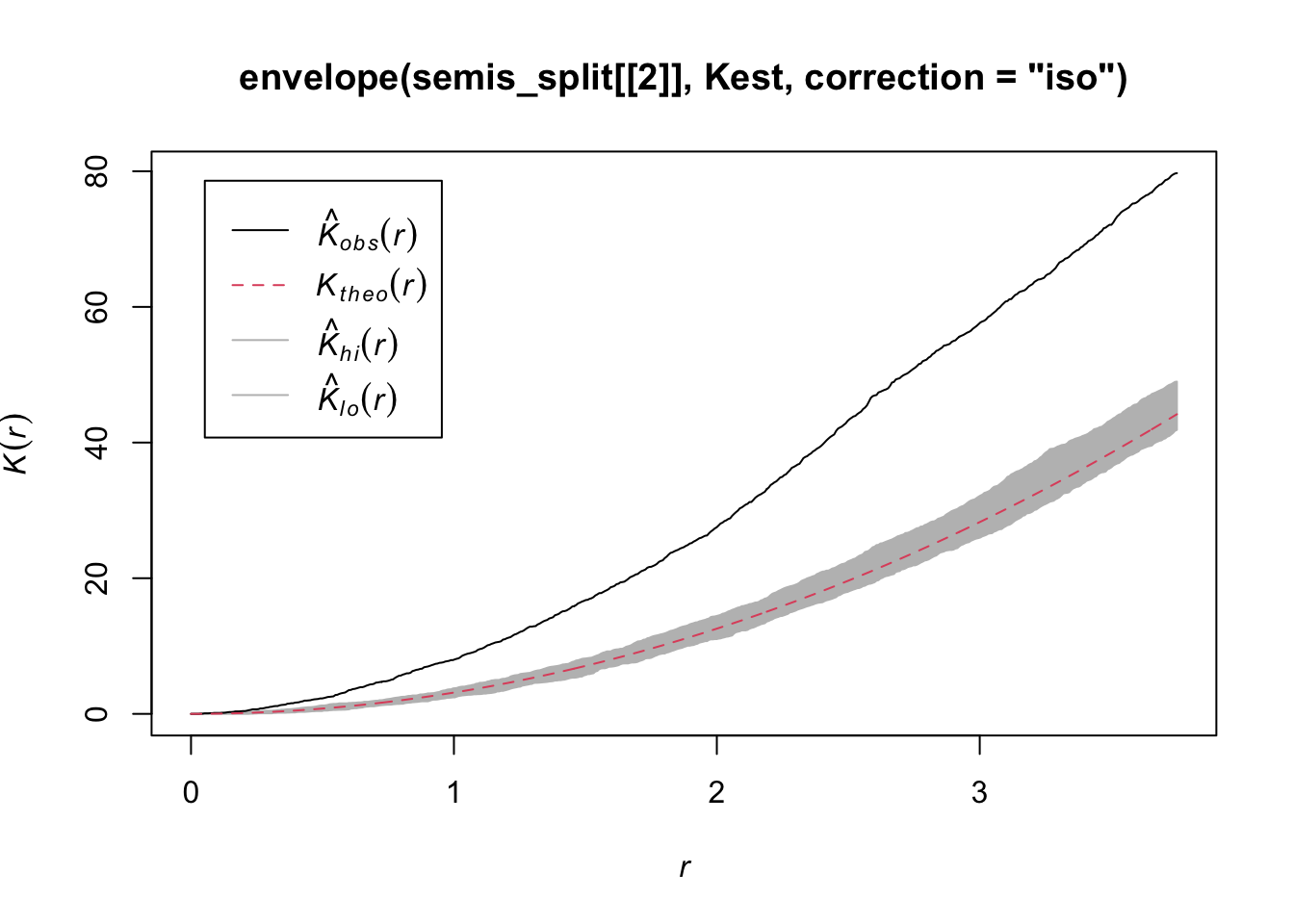

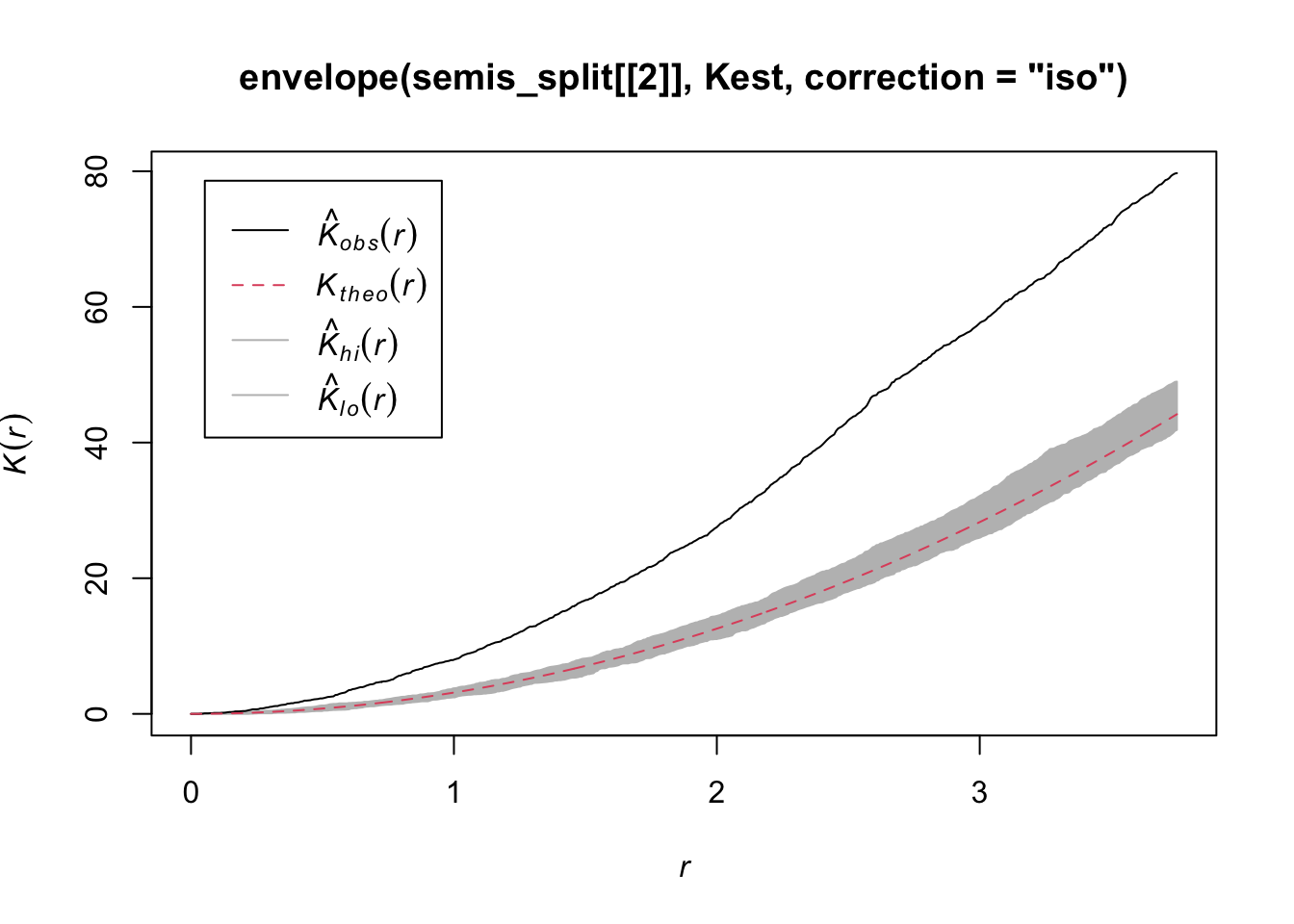

According to this graph, there seems to be an excess of neighbours for distances of 1 m and above. To check if this is a significant difference, we produce a simulation envelope with the envelope function. The first argument of envelope is a point pattern to which the simulations will be compared, the second one is a function to be computed (here, Kest) for each simulated pattern, then we add the arguments of the Kest function (here, only correction).

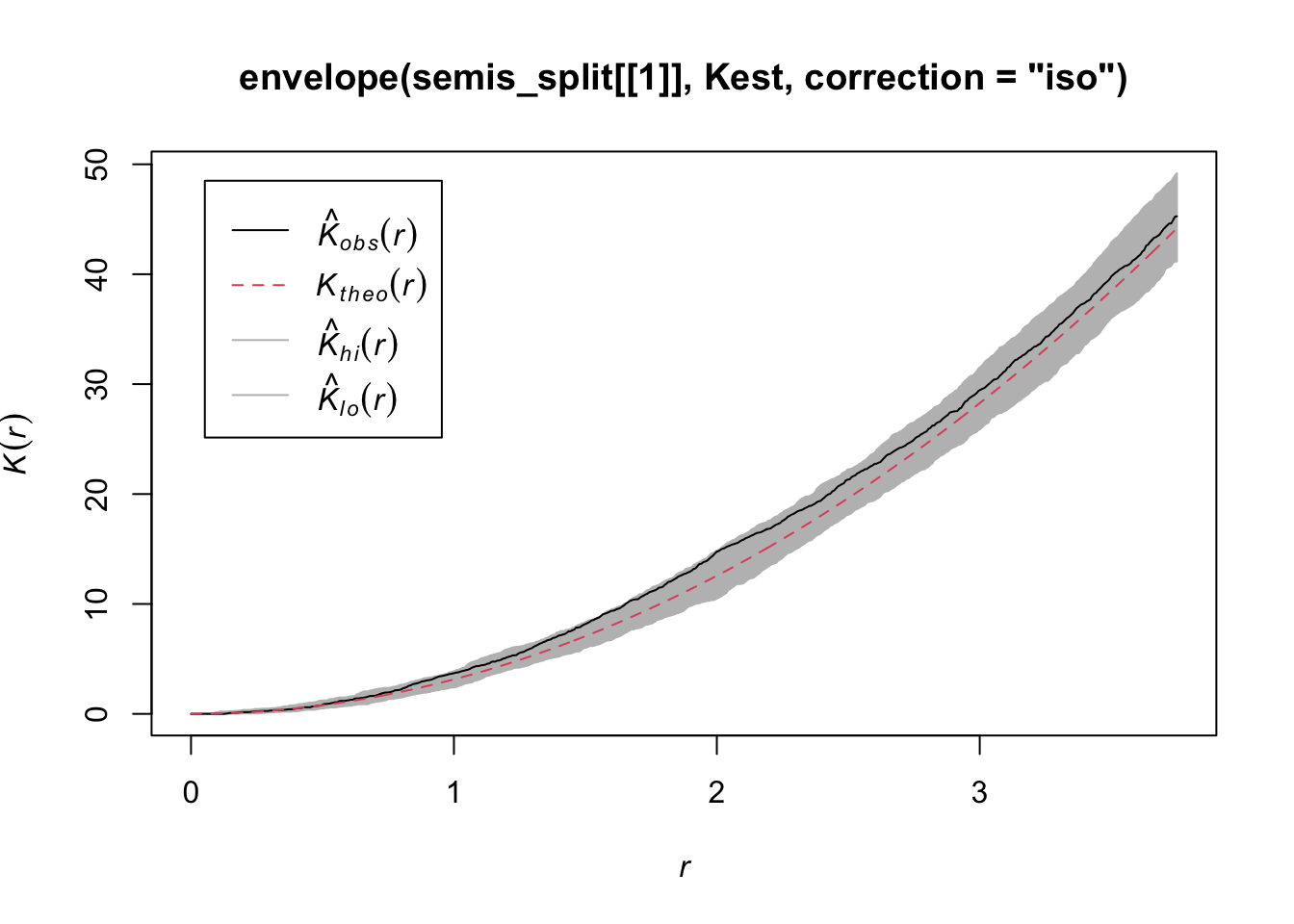

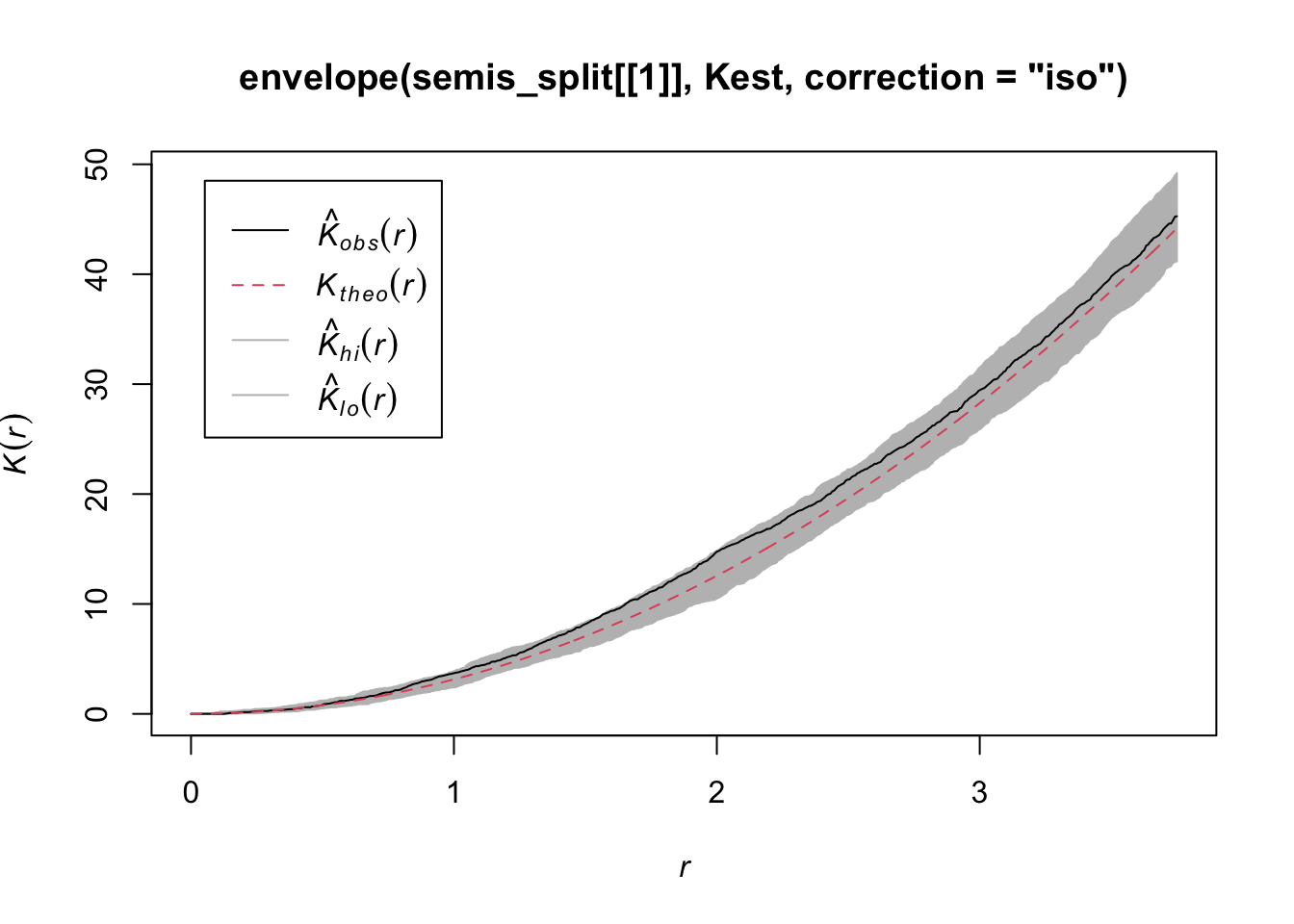

plot(envelope(semis_split[[1]], Kest, correction = "iso"))Generating 99 simulations of CSR ...

1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24, 25, 26, 27, 28, 29, 30, 31, 32, 33, 34, 35, 36, 37, 38, 39, 40,

41, 42, 43, 44, 45, 46, 47, 48, 49, 50, 51, 52, 53, 54, 55, 56, 57, 58, 59, 60, 61, 62, 63, 64, 65, 66, 67, 68, 69, 70, 71, 72, 73, 74, 75, 76, 77, 78, 79, 80,

81, 82, 83, 84, 85, 86, 87, 88, 89, 90, 91, 92, 93, 94, 95, 96, 97, 98, 99.

Done.

As indicated by the message, by default the function performs 99 simulations of the null model corresponding to complete spatial randomness (CSR).

The observed curve falls outside the envelope of the 99 simulations near \(r = 2\). We must be careful not to interpret too quickly a result that is outside the envelope. Although there is about a 1% probability of obtaining a more extreme result under the null hypothesis at a given distance, the envelope is calculated for a large number of values of \(r\) and is not corrected for multiple comparisons. Thus, a significant difference for a very small range of values of \(r\) may be simply due to chance.

Exercise 1

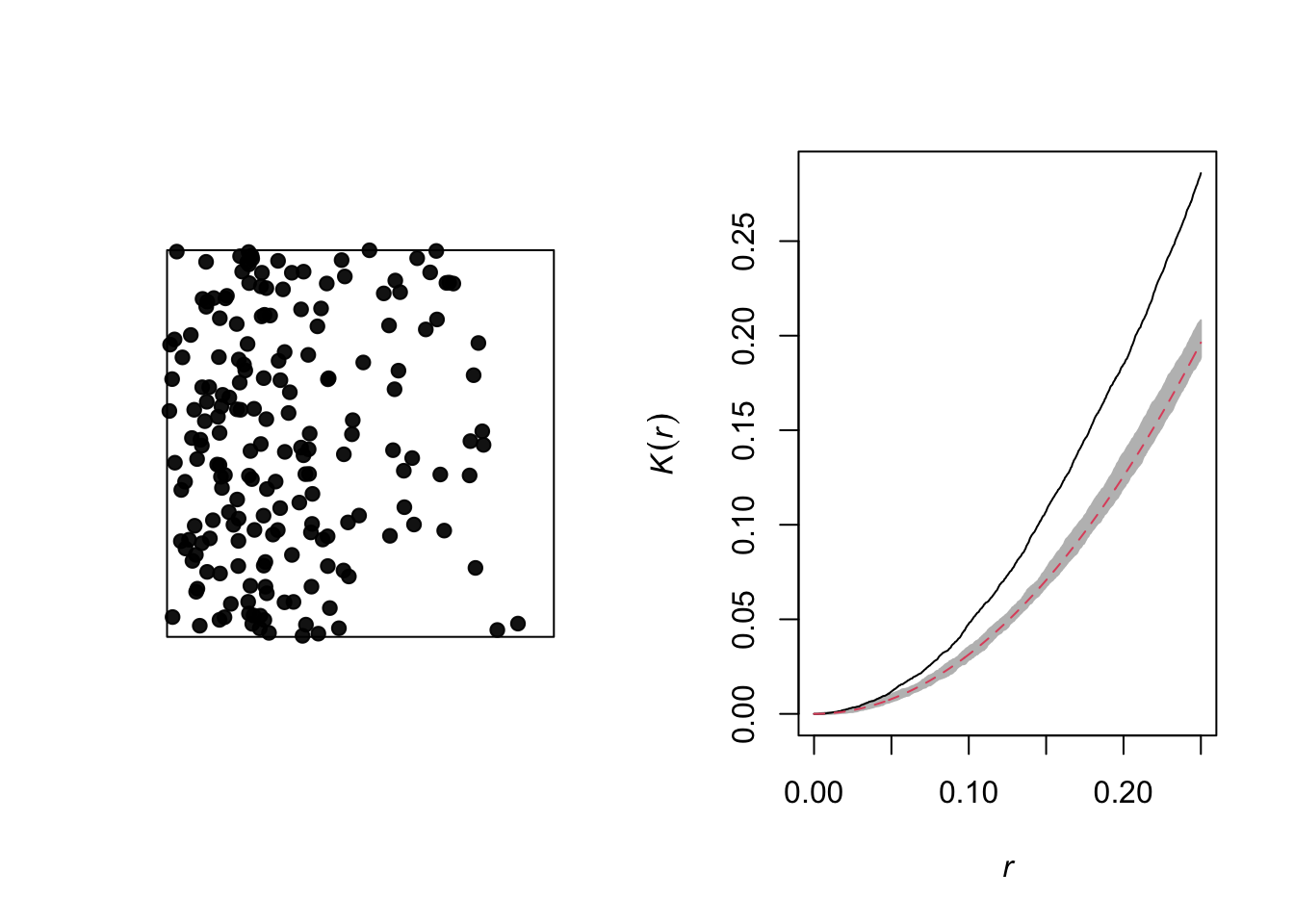

Looking at the graph of the second point pattern (poplar seedlings), can you predict where Ripley’s \(K\) will be in relation to the null hypothesis of complete spatial randomness? Verify your prediction by calculating Ripley’s \(K\) for this point pattern in R.

Effect of heterogeneity

The graph below illustrates a heterogeneous point pattern, i.e. it shows an density gradient (more points on the left than on the right).

A density gradient can be confused with an aggregation of points, as can be seen on the graph of the corresponding Ripley’s \(K\). In theory, these are two different processes:

Heterogeneity: The density of points varies in the study area, for example due to the fact that certain local conditions are more favorable to the presence of the species of interest.

Aggregation: The mean density of points is homogeneous, but the presence of one point increases the presence of other points in its vicinity, for example due to positive interactions between individuals.

However, it may be difficult to differentiate between the two in practice, especially since some patterns may be both heterogeneous and aggregated.

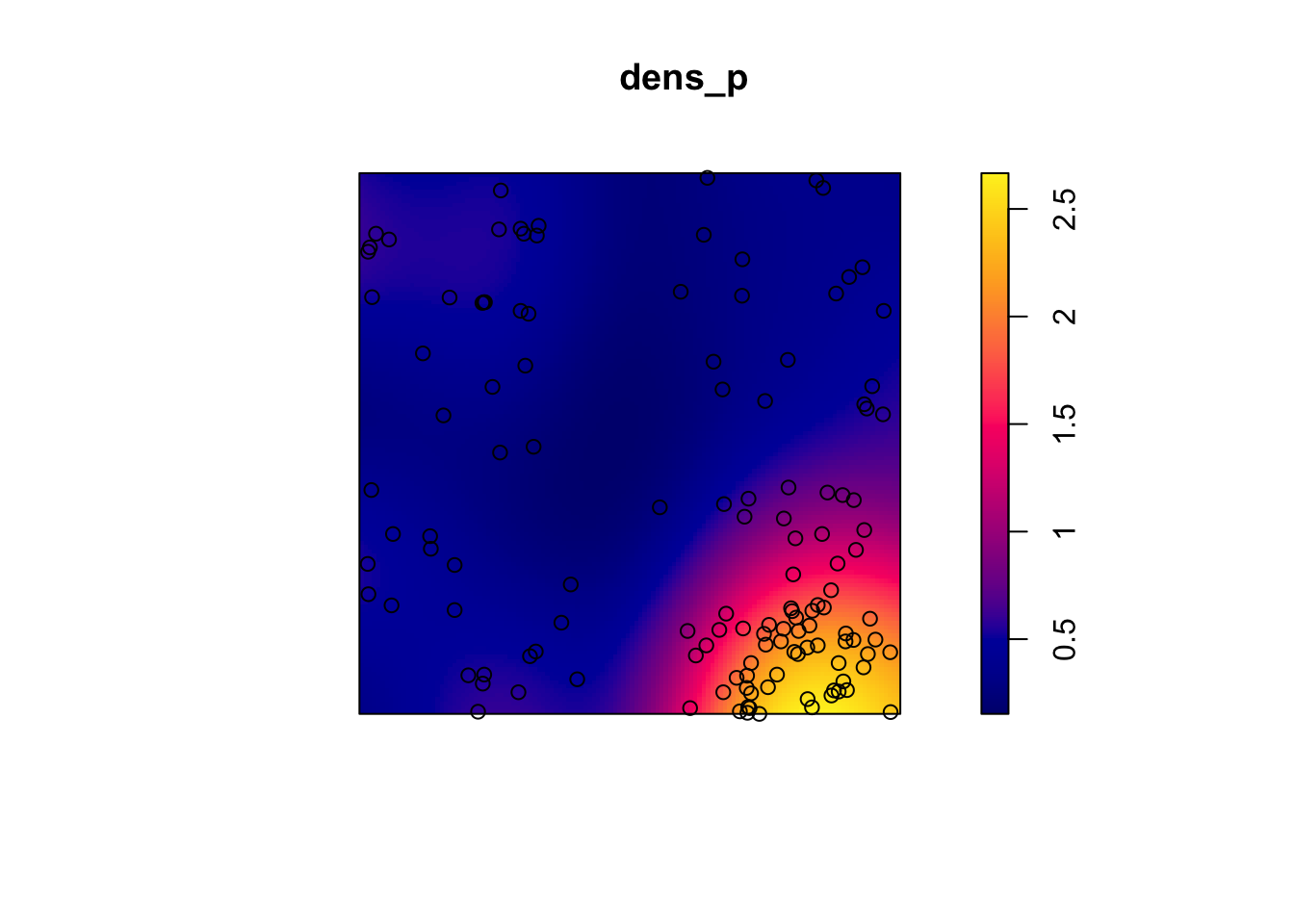

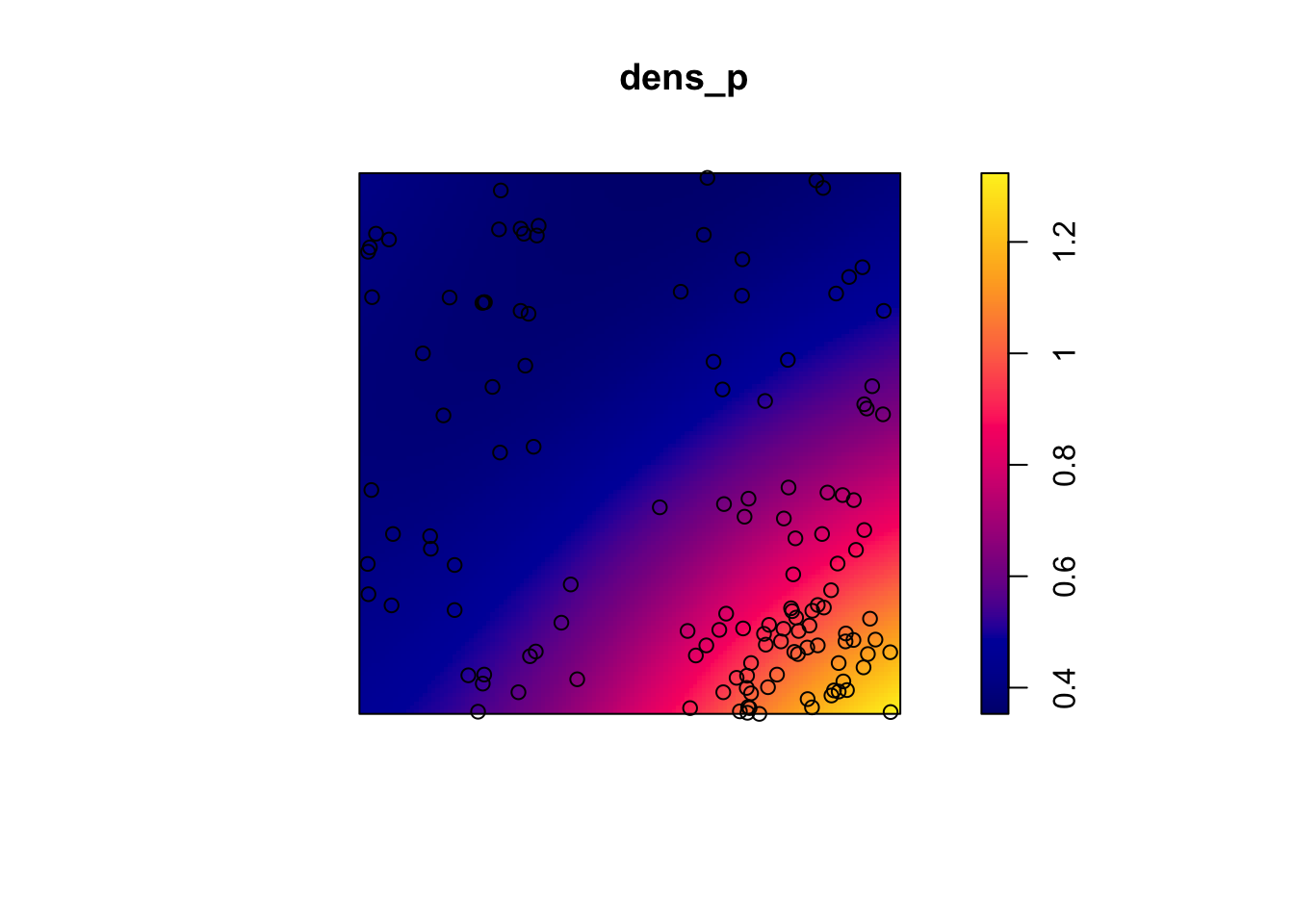

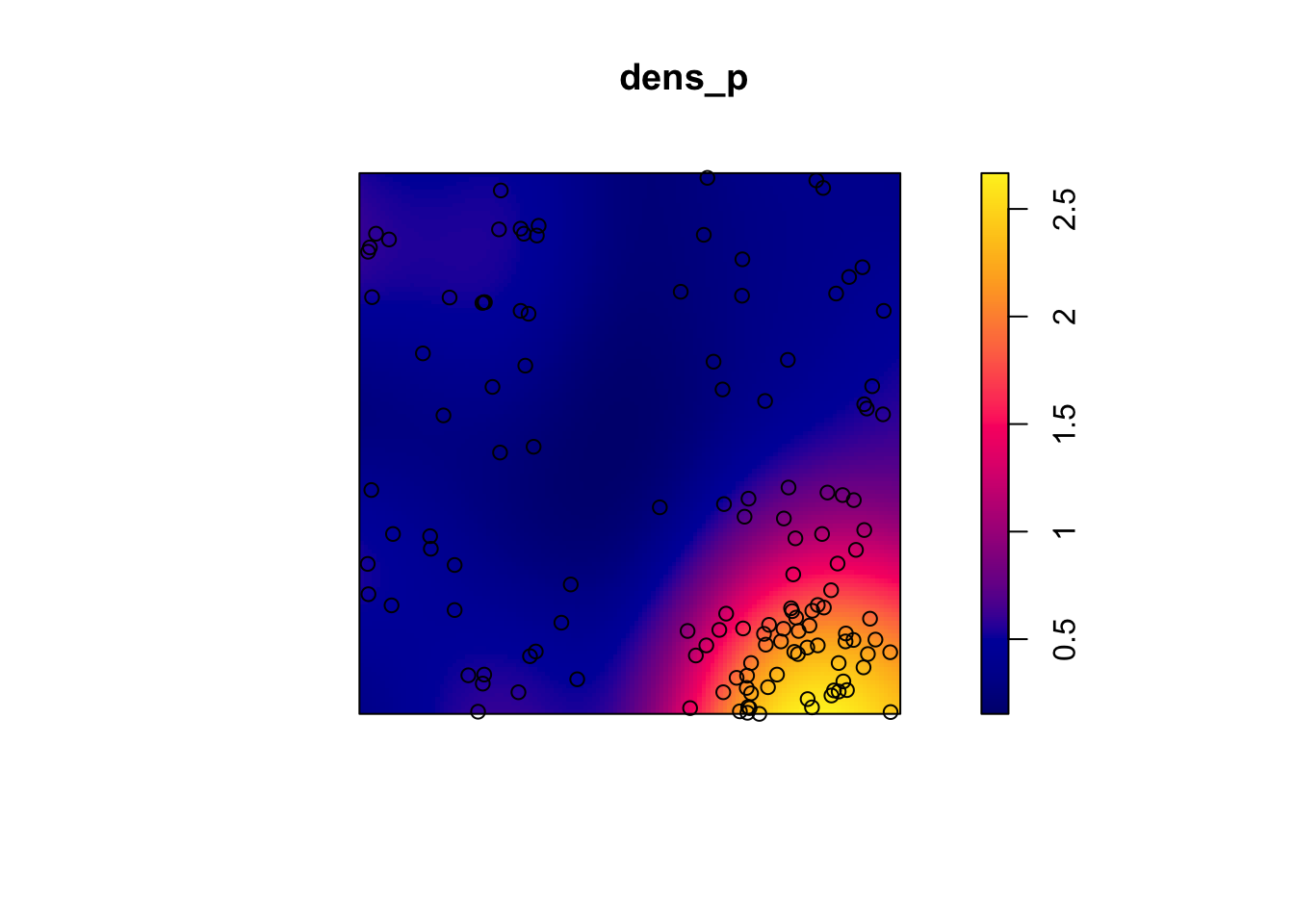

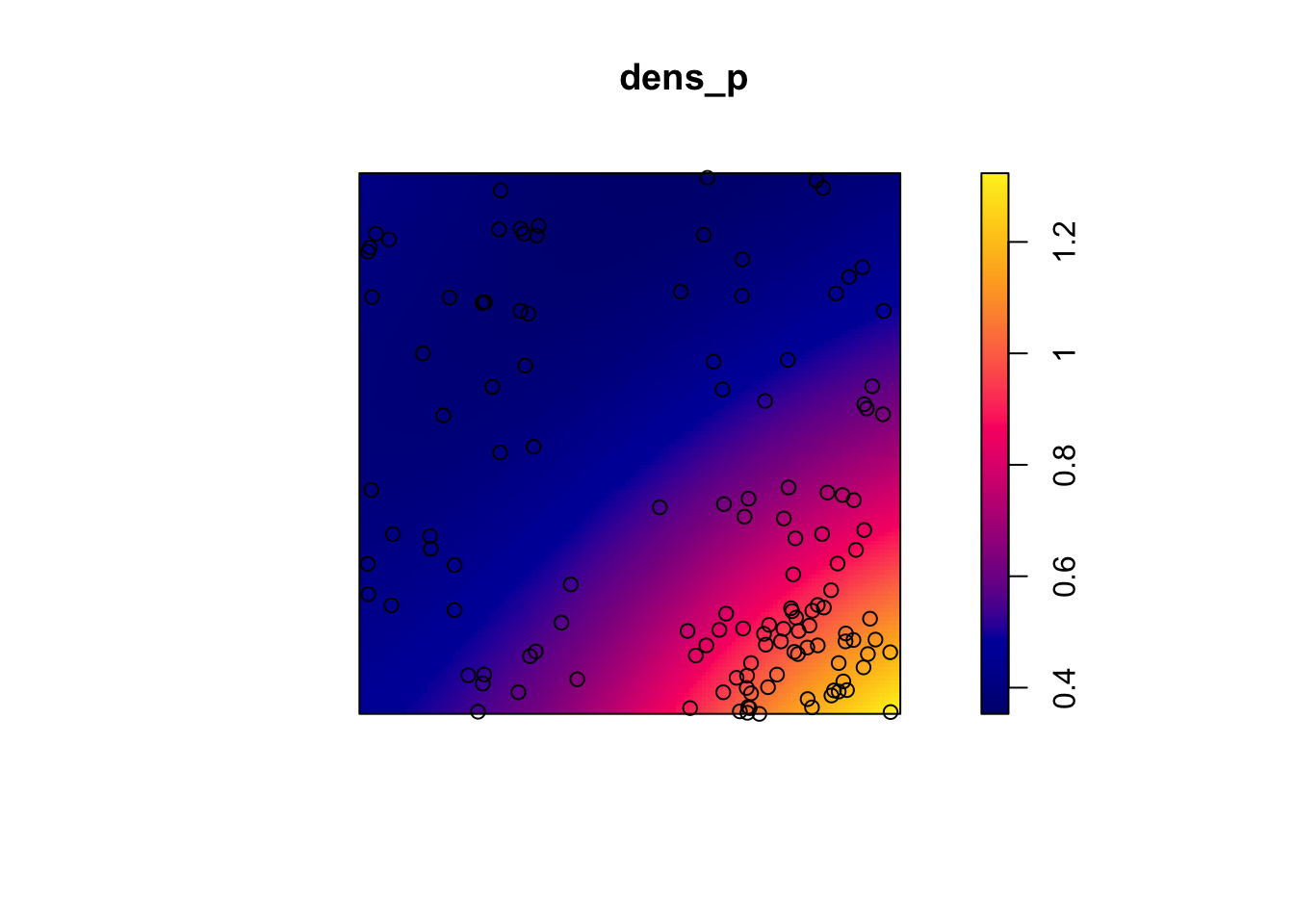

Let’s take the example of the poplar seedlings from the previous exercise. The density function applied to a point pattern performs a kernel density estimation of the density of the seedlings across the plot. By default, this function uses a Gaussian kernel with a standard deviation sigma specified in the function, which determines the scale at which density fluctuations are “smoothed”. Here, we use a value of 2 m for sigma and we first represent the estimated density with plot, before overlaying the points (add = TRUE means that the points are added to the existing plot rather than creating a new plot).

dens_p <- density(semis_split[[2]], sigma = 2)

plot(dens_p)

plot(semis_split[[2]], add = TRUE)

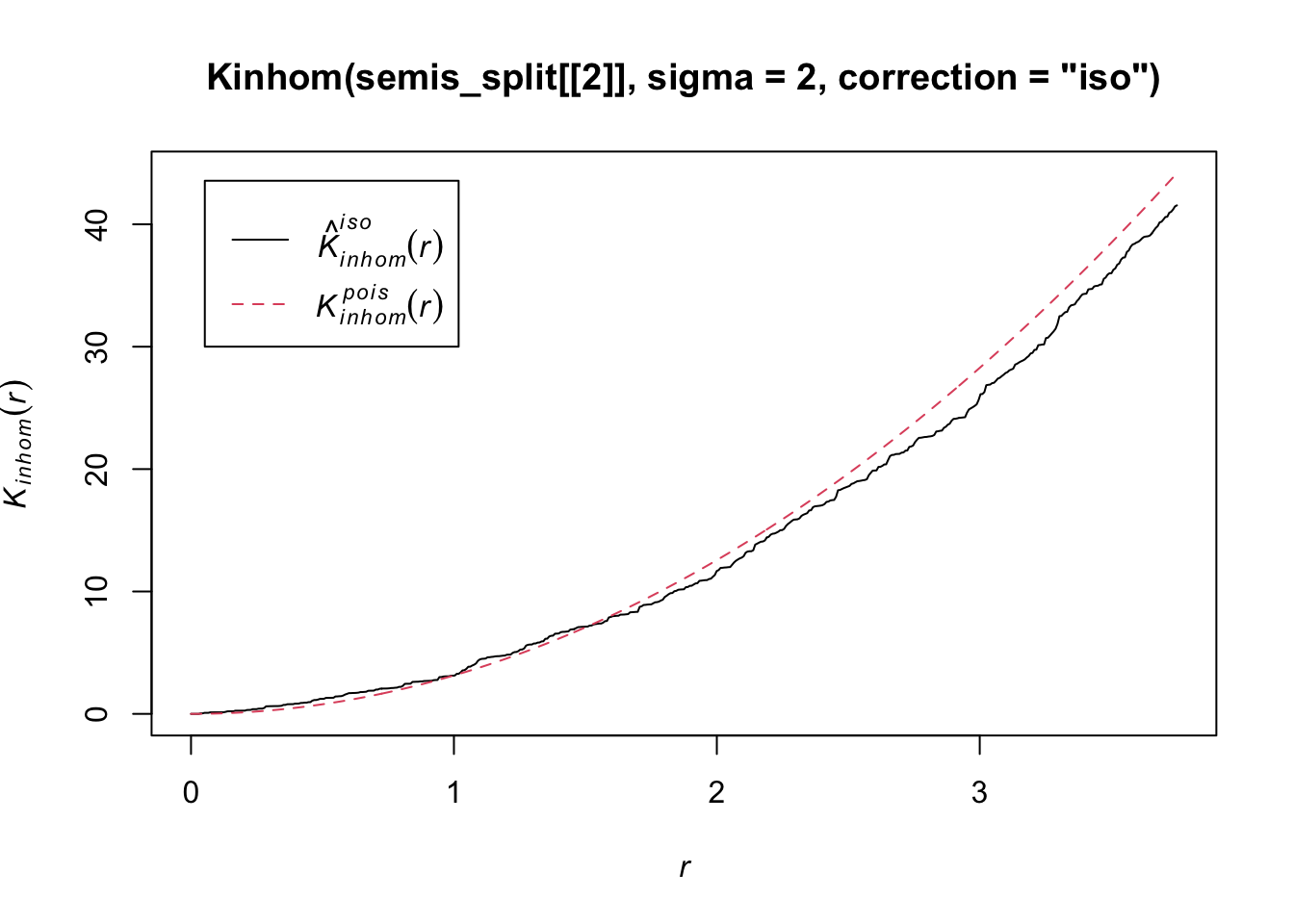

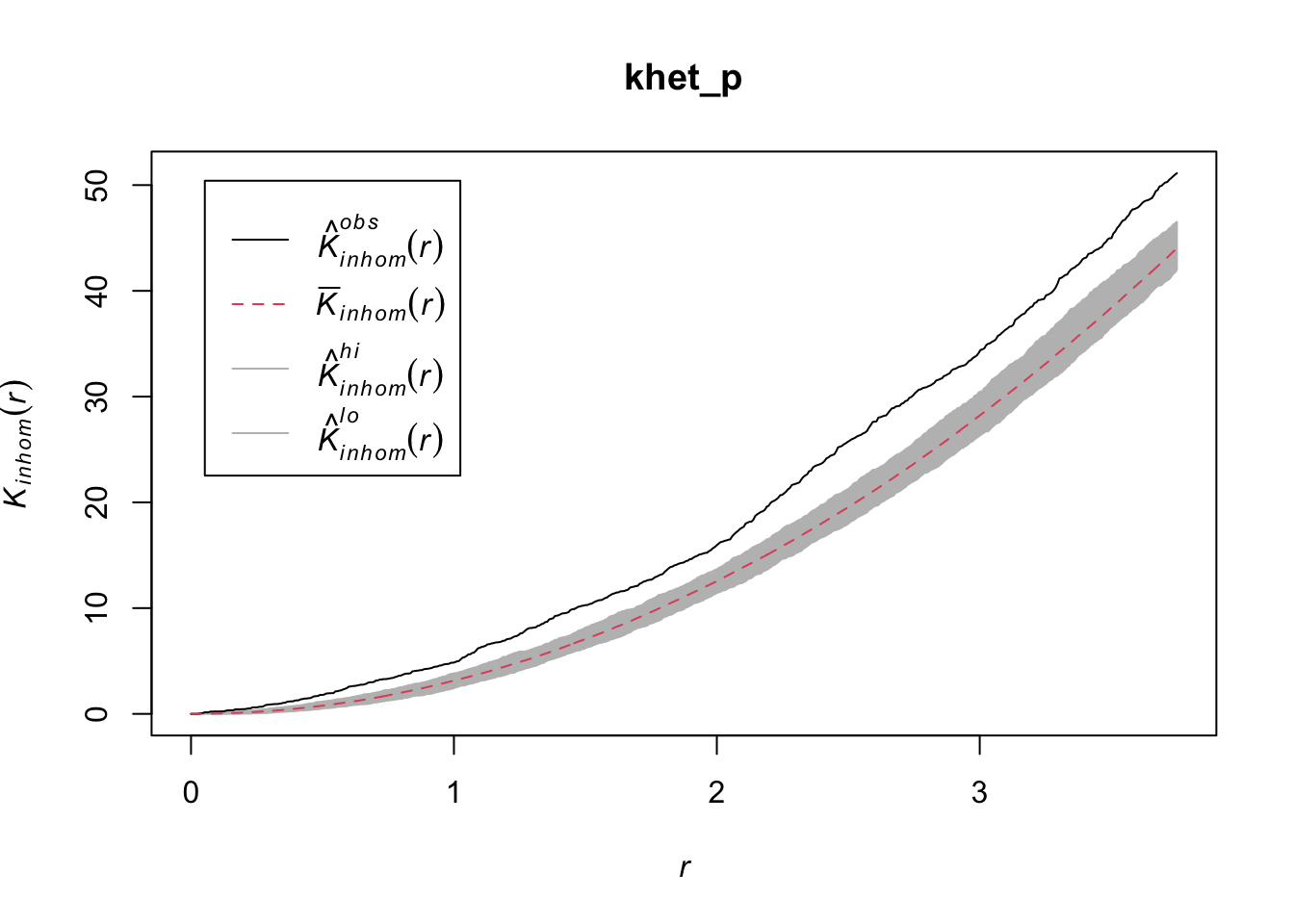

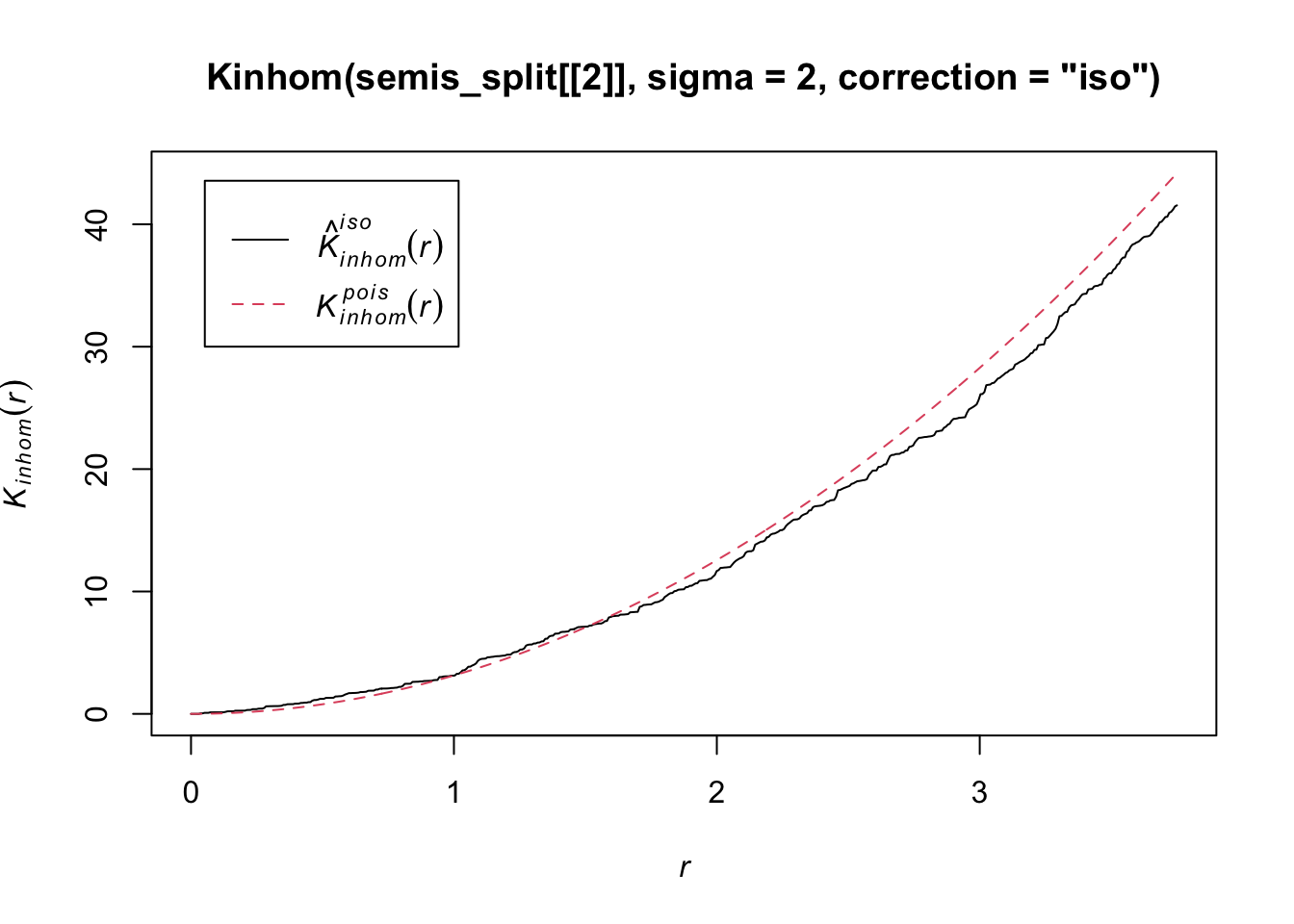

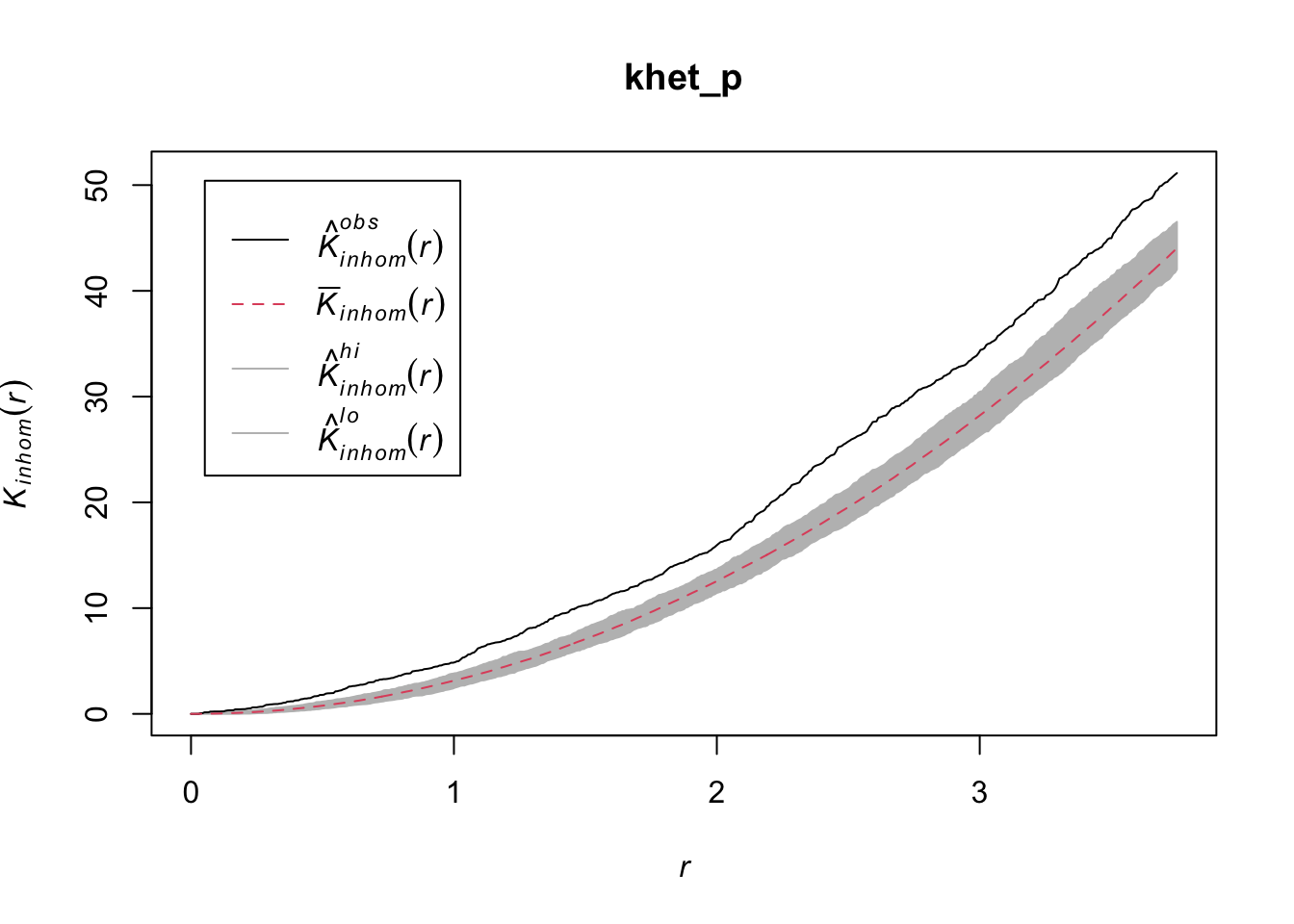

To measure the aggregation or repulsion of points in a heterogeneous pattern, we must use the inhomogeneous version of the \(K\) statistic (Kinhom in spatstat). This statistic is still equal to the mean number of neighbours within a radius \(r\) of a point in the pattern, but rather than standardizing this number by the overall intensity of the pattern, it is standardized by the local estimated density. As above, we specify sigma = 2 to control the level of smoothing for the varying density estimate.

plot(Kinhom(semis_split[[2]], sigma = 2, correction = "iso"))

Taking into account the heterogeneity of the pattern at a scale sigma of 2 m, there seems to be a deficit of neighbours starting at a radius of about 1.5 m. We can now check whether this deviation is significant.

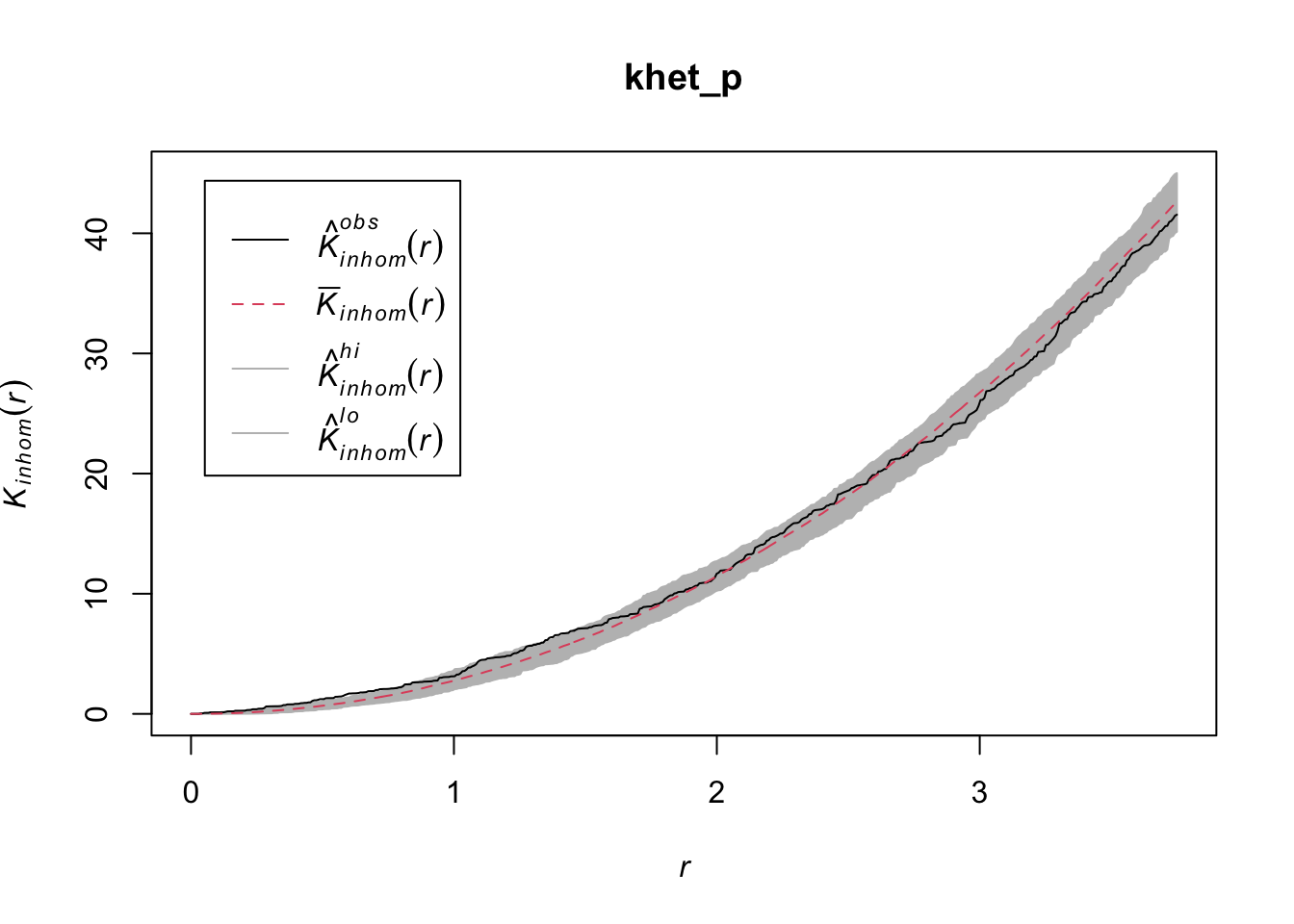

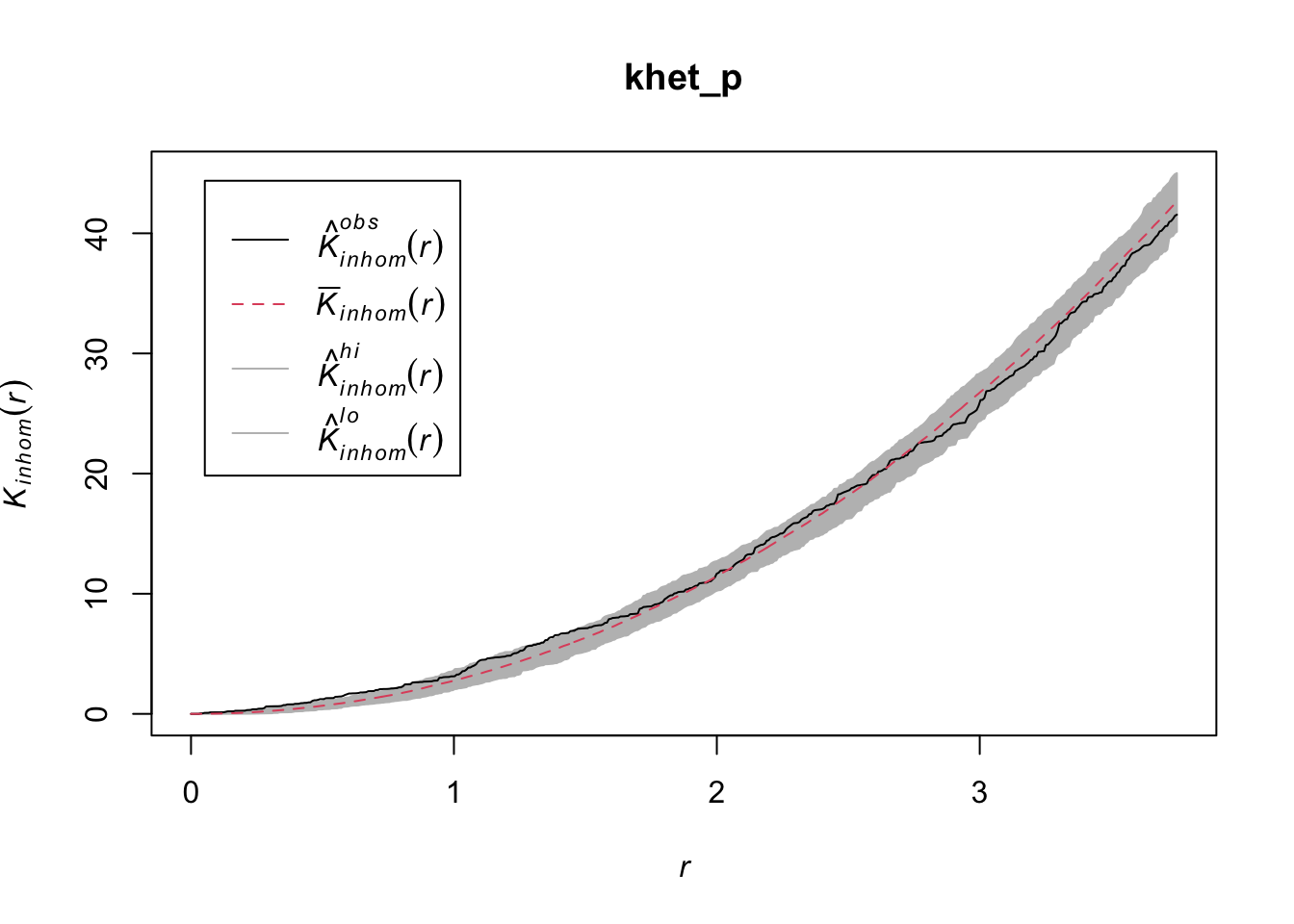

As before, we use envelope to simulate the Kinhom statistic under the null model. However, the null model here is not a homogeneous Poisson process (CSR). It is instead a heterogeneous Poisson process simulated by the function rpoispp(dens_p), i.e. the points are independent of each other, but their density is heterogeneous and given by dens_p. The simulate argument of the envelope function specifies the function used for simulations under the null model; this function must have one argument, here x, even if it is not used.

Finally, in addition to the arguments needed for Kinhom, i.e. sigma and correction, we also specify nsim = 199 to perform 199 simulations and nrank = 5 to eliminate the 5 most extreme results on each side of the envelope, i.e. the 10 most extreme results out of 199, to achieve an interval containing about 95% of the probability under the null hypothesis.

khet_p <- envelope(semis_split[[2]], Kinhom, sigma = 2, correction = "iso",

nsim = 199, nrank = 5, simulate = function(x) rpoispp(dens_p))Generating 199 simulations by evaluating function ...

1, 2, 3, 4.6.8.10.12.14.16.18.20.22.24.26.28.30.32.34.36.38.40

.42.44.46.48.50.52.54.56.58.60.62.64.66.68.70.72.74.76.78.80

.82.84.86.88.90.92.94.96.98.100.102.104.106.108.110.112.114.116.118.120

.122.124.126.128.130.132.134.136.138.140.142.144.146.148.150.152.154.156.158.160

.162.164.166.168.170.172.174.176.178.180.182.184.186.188.190.192.194.196.198 199.

Done.plot(khet_p)

Note: For a hypothesis test based on simulations of a null hypothesis, the \(p\)-value is estimated by \((m + 1)/(n + 1)\), where \(n\) is the number of simulations and \(m\) is the number of simulations where the value of the statistic is more extreme than that of the observed data. This is why the number of simulations is often chosen to be 99, 199, etc.

Exercise 2

Repeat the heterogeneous density estimation and Kinhom calculation with a standard deviation sigma of 5 rather than 2. How does the smoothing level for the density estimation influence the conclusions?

To differentiate between a variation in the density of points from an interaction (aggregation or repulsion) between these points with this type of analysis, it is generally assumed that the two processes operate at different scales. Typically, we can test whether the points are aggregated at a small scale after accounting for a variation in density at a larger scale.

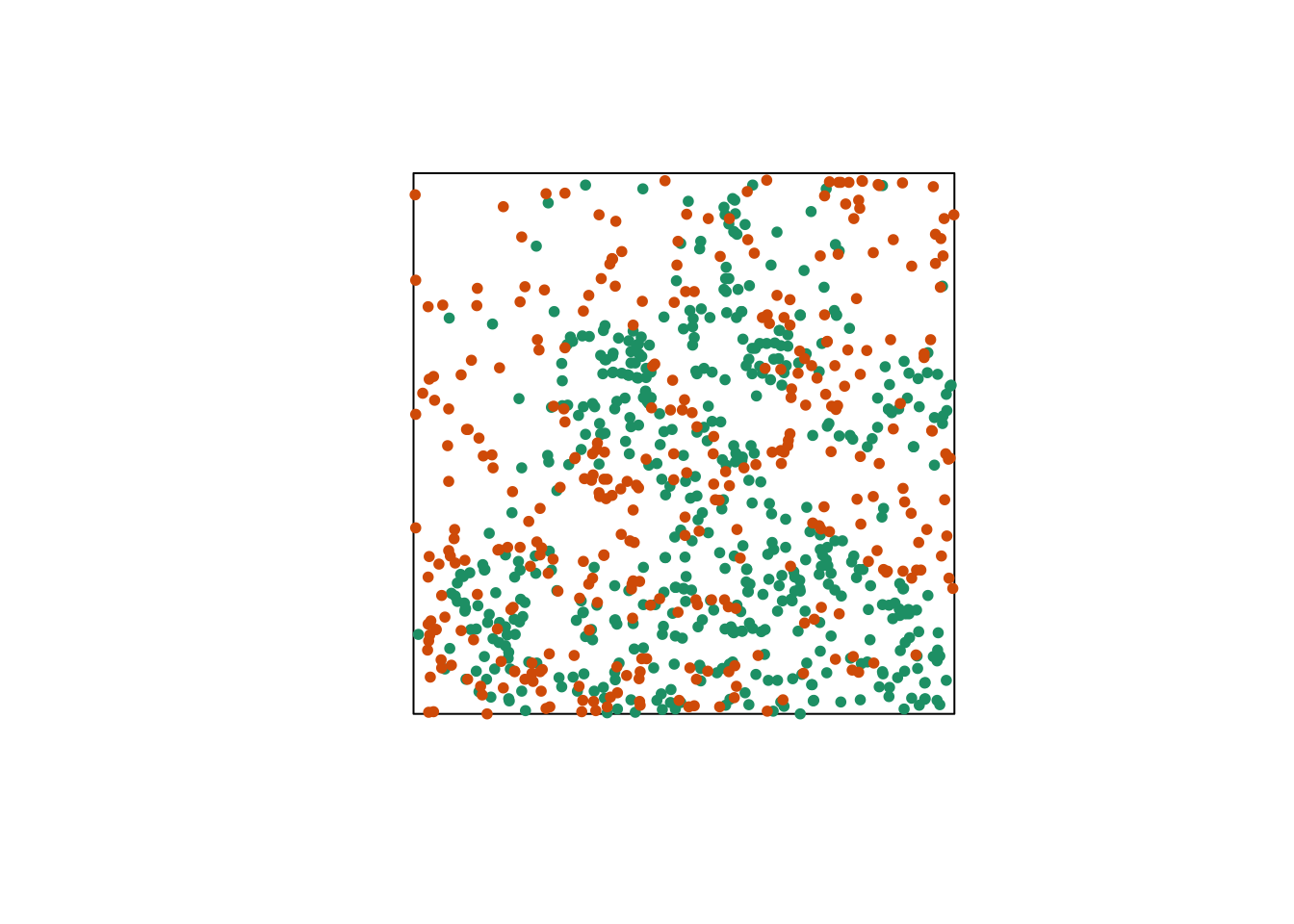

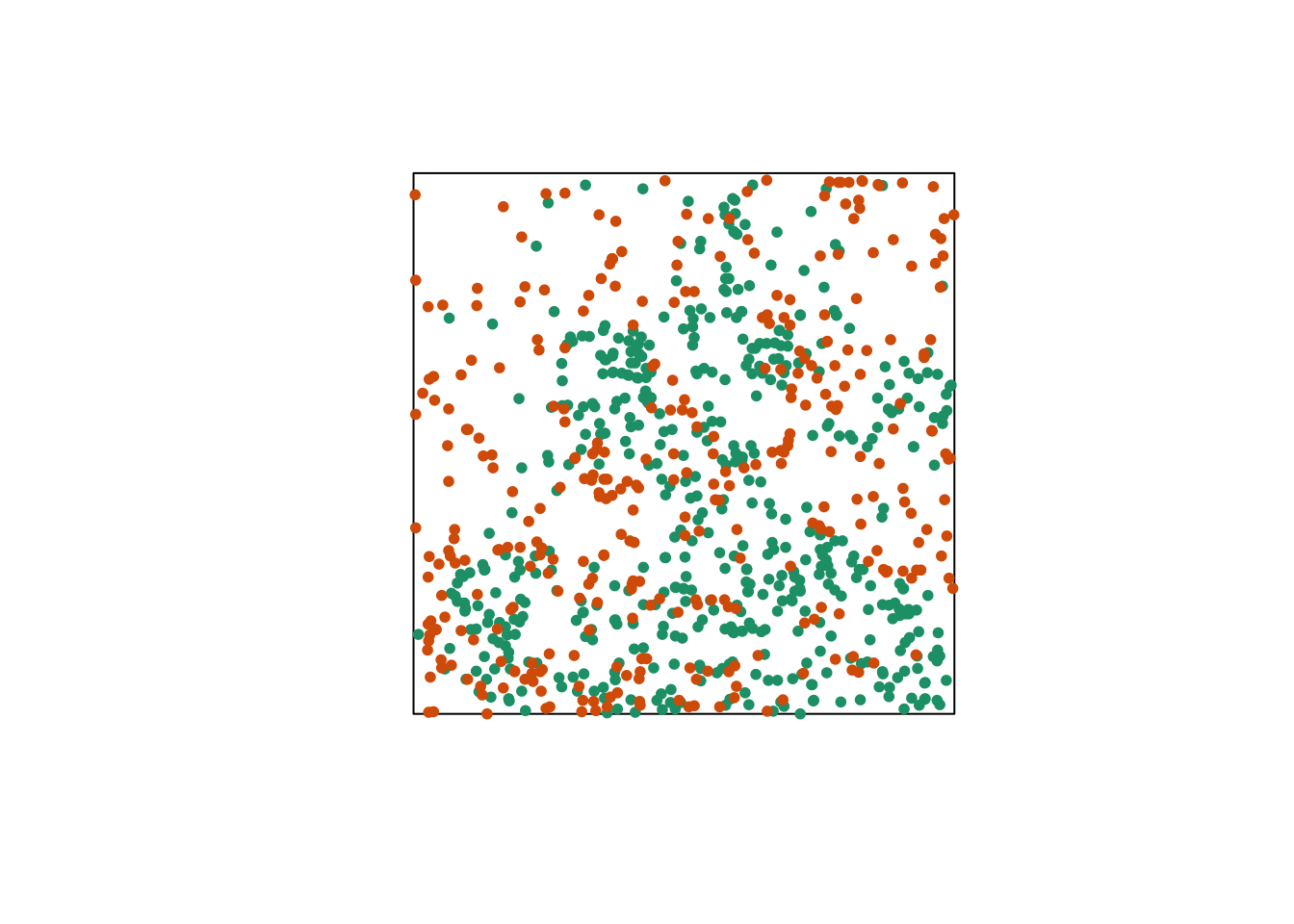

Relationship between two point patterns

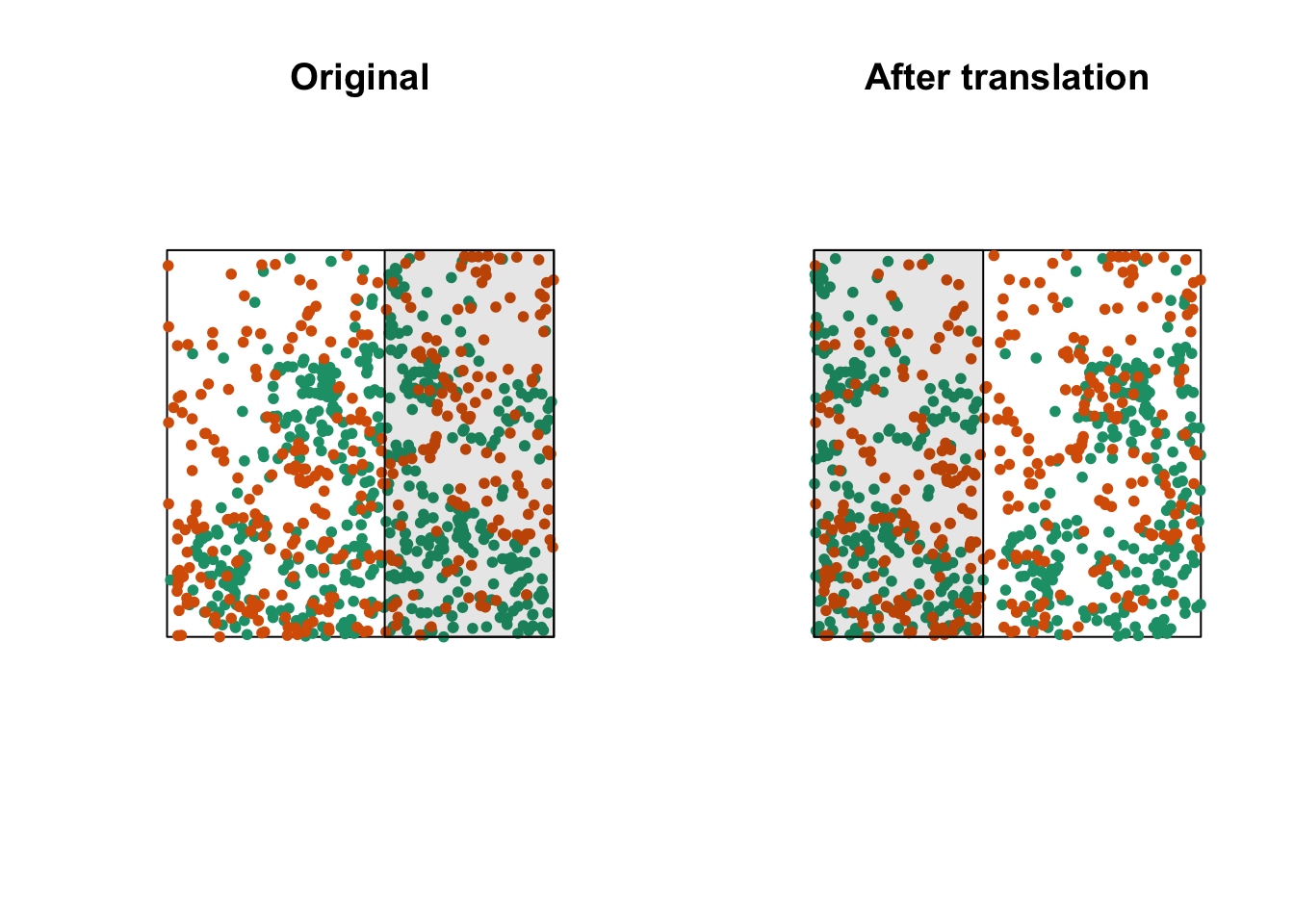

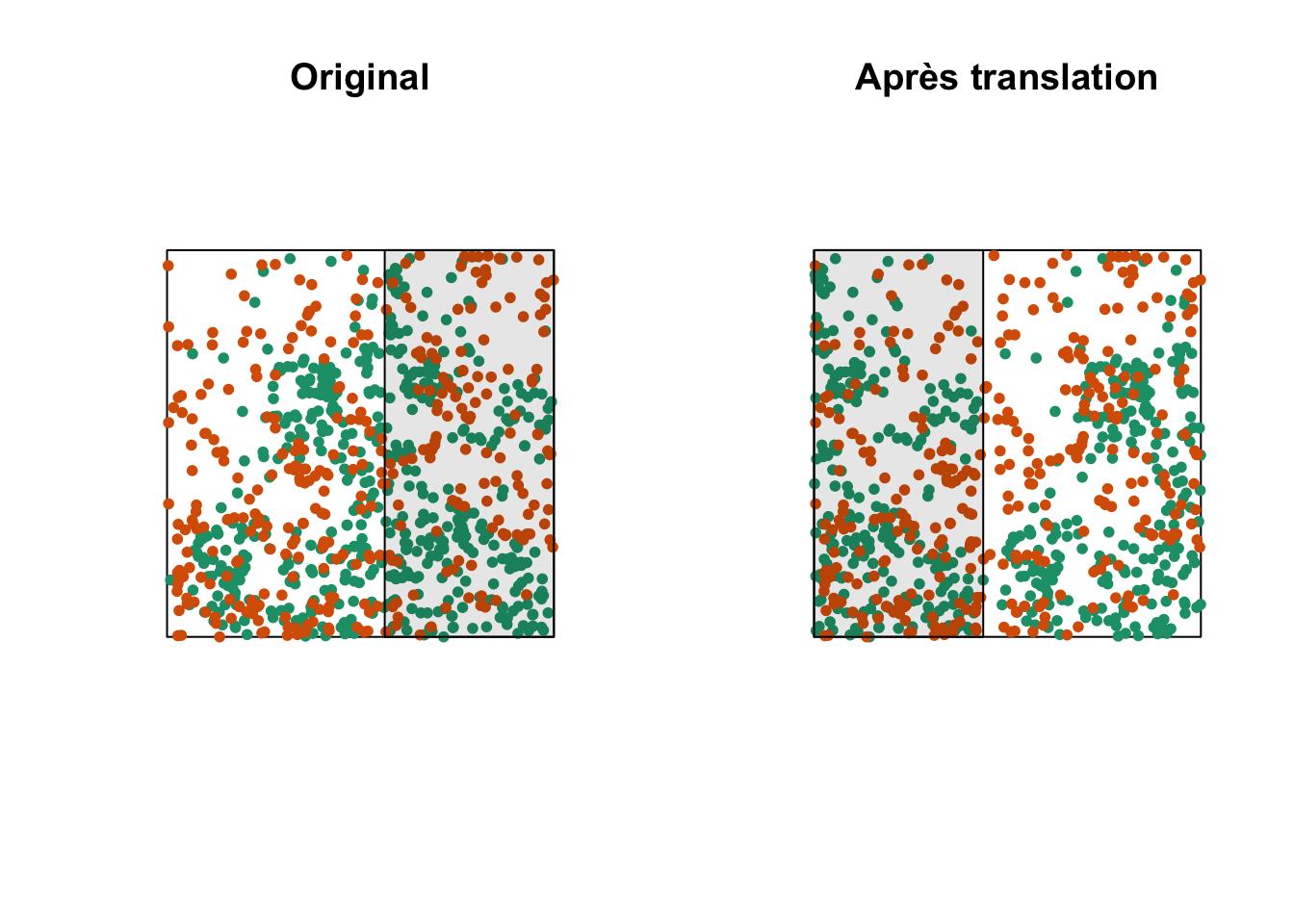

Let’s consider a case where we have two point patterns, for example the position of trees of two species in a plot (orange and green points in the graph below). Each of the two patterns may or may not present an aggregation of points.

Regardless of whether points are aggregated at the species level, we want to determine whether the two species are arranged independently. In other words, does the probability of observing a tree of one species depend on the presence of a tree of the other species at a given distance?

The bivariate version of Ripley’s \(K\) allows us to answer this question. For two patterns noted 1 and 2, the function \(K_{12}(r)\) calculates the mean number of points in pattern 2 within a radius \(r\) from a point in pattern 1, standardized by the density of pattern 2.

In theory, this function is symmetrical, so \(K_{12}(r) = K_{21}(r)\) and the result would be the same whether the points of pattern 1 or 2 are chosen as “focal” points for the analysis. However, the estimation of the two quantities for an observed pattern may differ, in particular because of edge effects. The variance of \(K_{12}\) and \(K_{21}\) between simulations of a null model may also differ, so the null hypothesis test may have more or less power depending on the choice of the focal species.

The choice of an appropriate null model is important here. In order to determine whether there is a significant attraction or repulsion between the two patterns, the position of one of the patterns must be randomly moved relative to that of the other pattern, while keeping the spatial structure of each pattern taken in isolation.

One way to do this randomization is to shift one of the two patterns horizontally and/or vertically by a random distance. The part of the pattern that “comes out” on one side of the window is attached to the other side. This method is called a toroidal shift, because by connecting the top and bottom as well as the left and right of a rectangular surface, we obtain the shape of a torus (a three-dimensional “donut”).

The graph above shows a translation of the green pattern to the right, while the orange pattern remains in the same place. The green points in the shaded area are brought back on the other side. Note that while this method generally preserves the structure of each pattern while randomizing their relative position, it can have some drawbacks, such as dividing point clusters that are near the cutoff point.

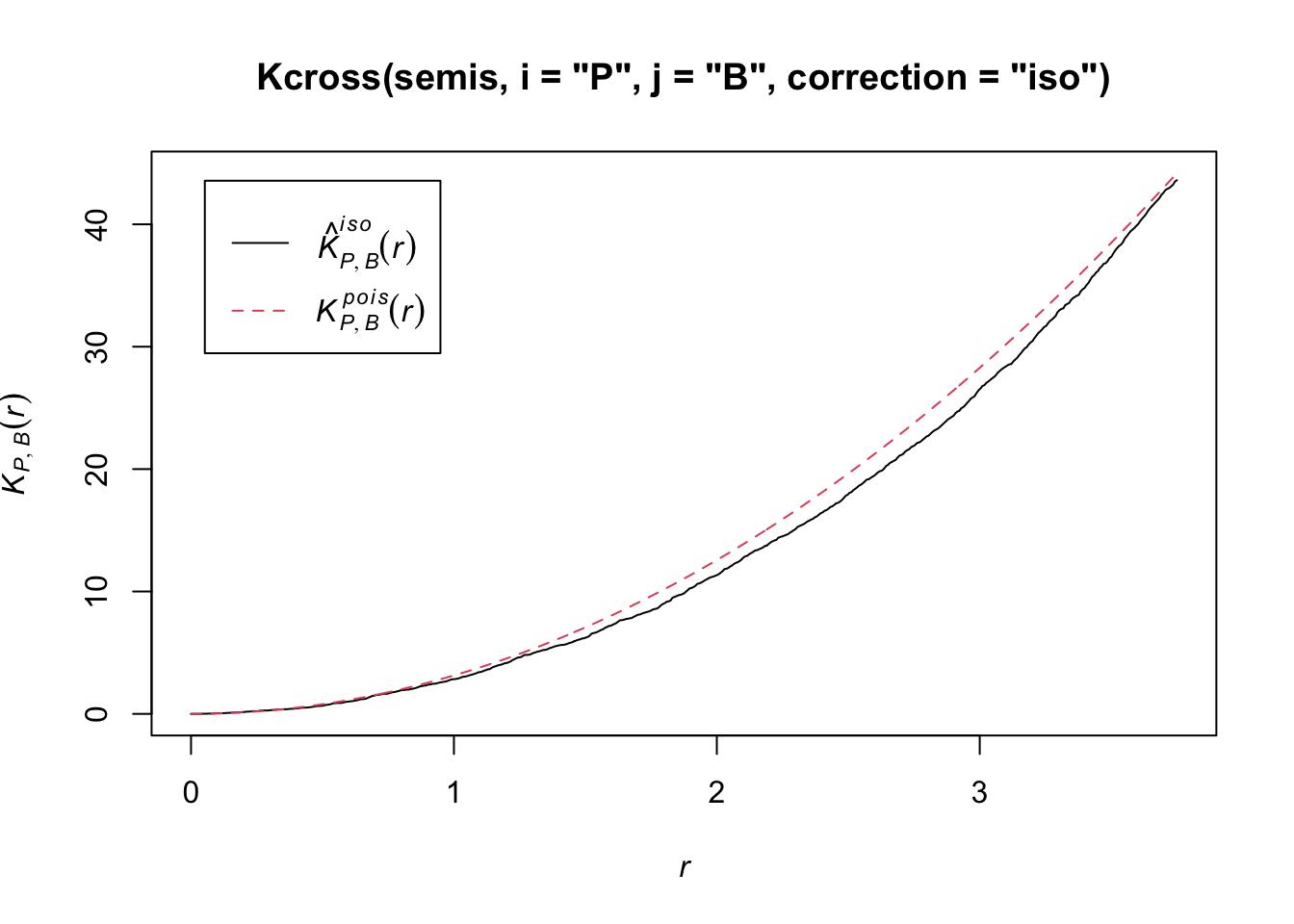

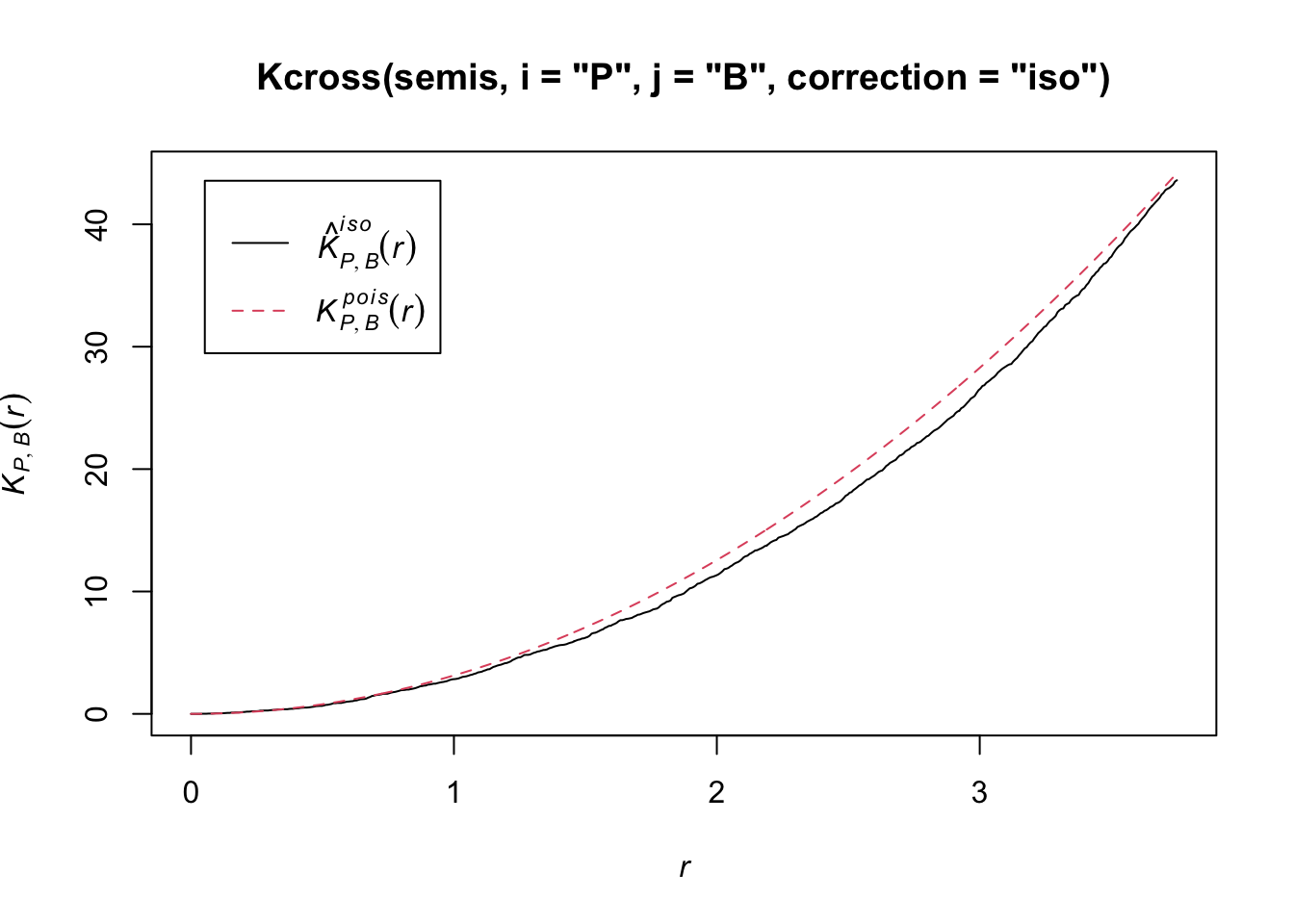

Let’s now check whether the position of the two species (birch and poplar) is independent in our plot. The function Kcross calculates the bivariate \(K_{ij}\), we must specify which type of point (mark) is considered as the focal species \(i\) and the neighbouring species \(j\).

plot(Kcross(semis, i = "P", j = "B", correction = "iso"))

Here, the observed \(K\) is lower than the theoretical value, indicating a possible repulsion between the two patterns.

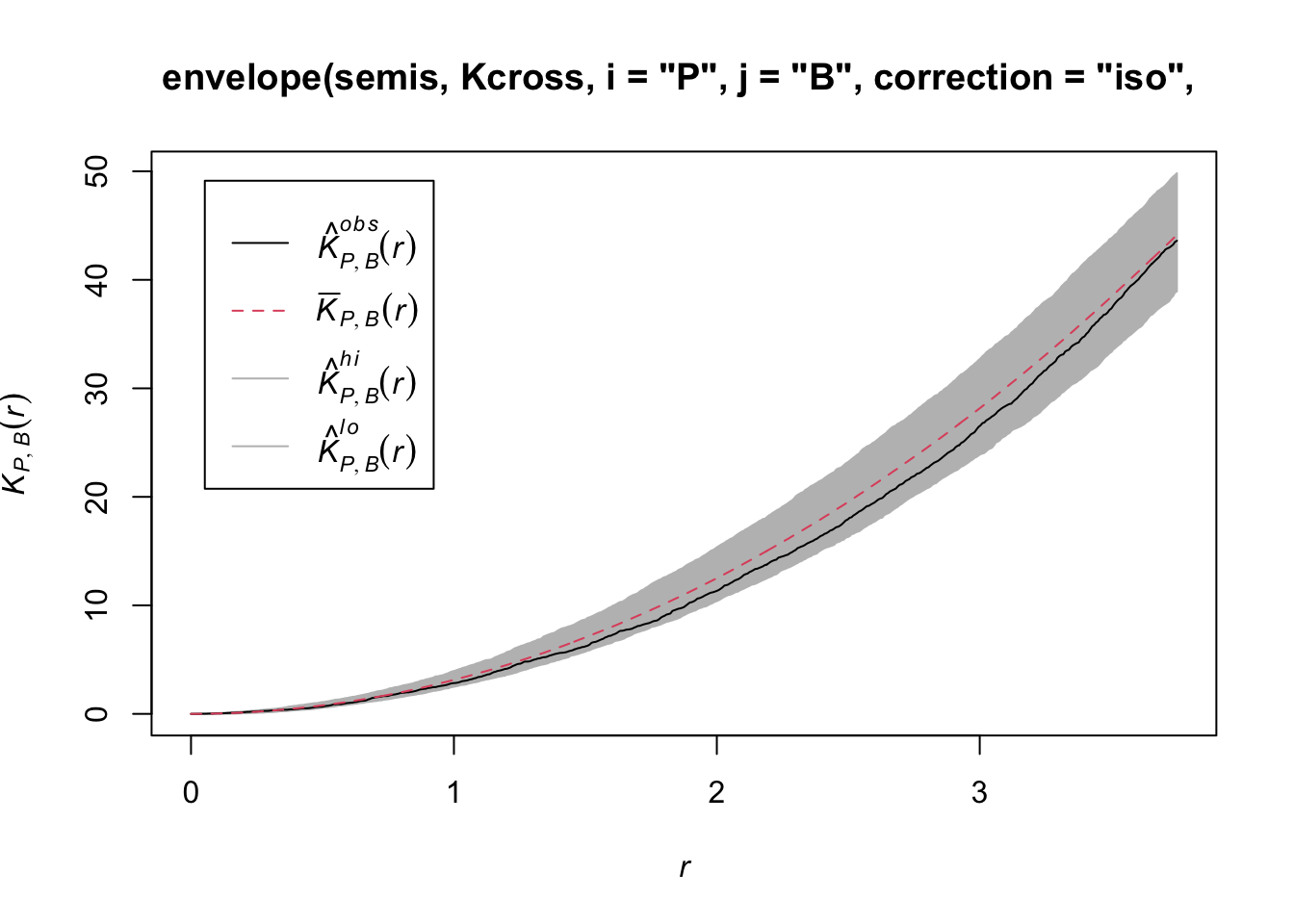

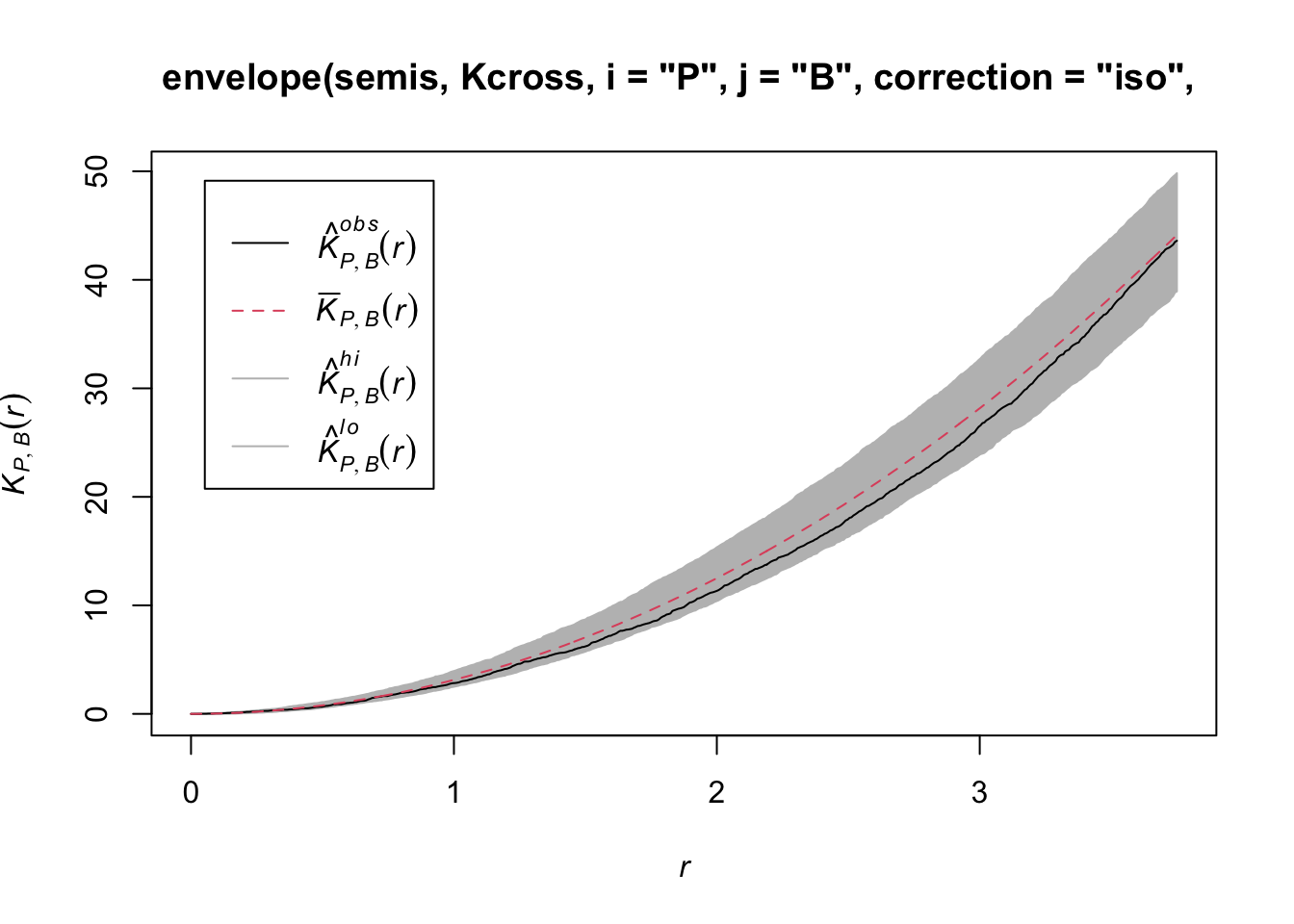

To determine the envelope of the \(K\) under the null hypothesis of independence of the two patterns, we must specify that the simulations are based on a translation of the patterns. We indicate that the simulations use the function rshift (random translation) with the argument simulate = function(x) rshift(x, which = "B"); here, the x argument in simulate corresponds to the original point pattern and the which argument indicates which of the patterns is translated. As in the previous case, the arguments needed for Kcross, i.e. i, j and correction, must be repeated in the envelope function.

plot(envelope(semis, Kcross, i = "P", j = "B", correction = "iso",

nsim = 199, nrank = 5, simulate = function(x) rshift(x, which = "B")))Generating 199 simulations by evaluating function ...

1, 2, 3, 4.6.8.10.12.14.16.18.20.22.24.26.28.30.32.34.36.38.40

.42.44.46.48.50.52.54.56.58.60.62.64.66.68.70.72.74.76.78.80

.82.84.86.88.90.92.94.96.98.100.102.104.106.108.110.112.114.116.118.120

.122.124.126.128.130.132.134.136.138.140.142.144.146.148.150.152.154.156.158.160

.162.164.166.168.170.172.174.176.178.180.182.184.186.188.190.192.194.196.198 199.

Done.

Here, the observed curve is totally within the envelope, so we do not reject the null hypothesis of independence of the two patterns.

Questions

What would be one reason for our choice to translate the points of the birch rather than poplar?

Would the simulations generated by random translation be a good null model if the two patterns were heterogeneous?

Marked point patterns

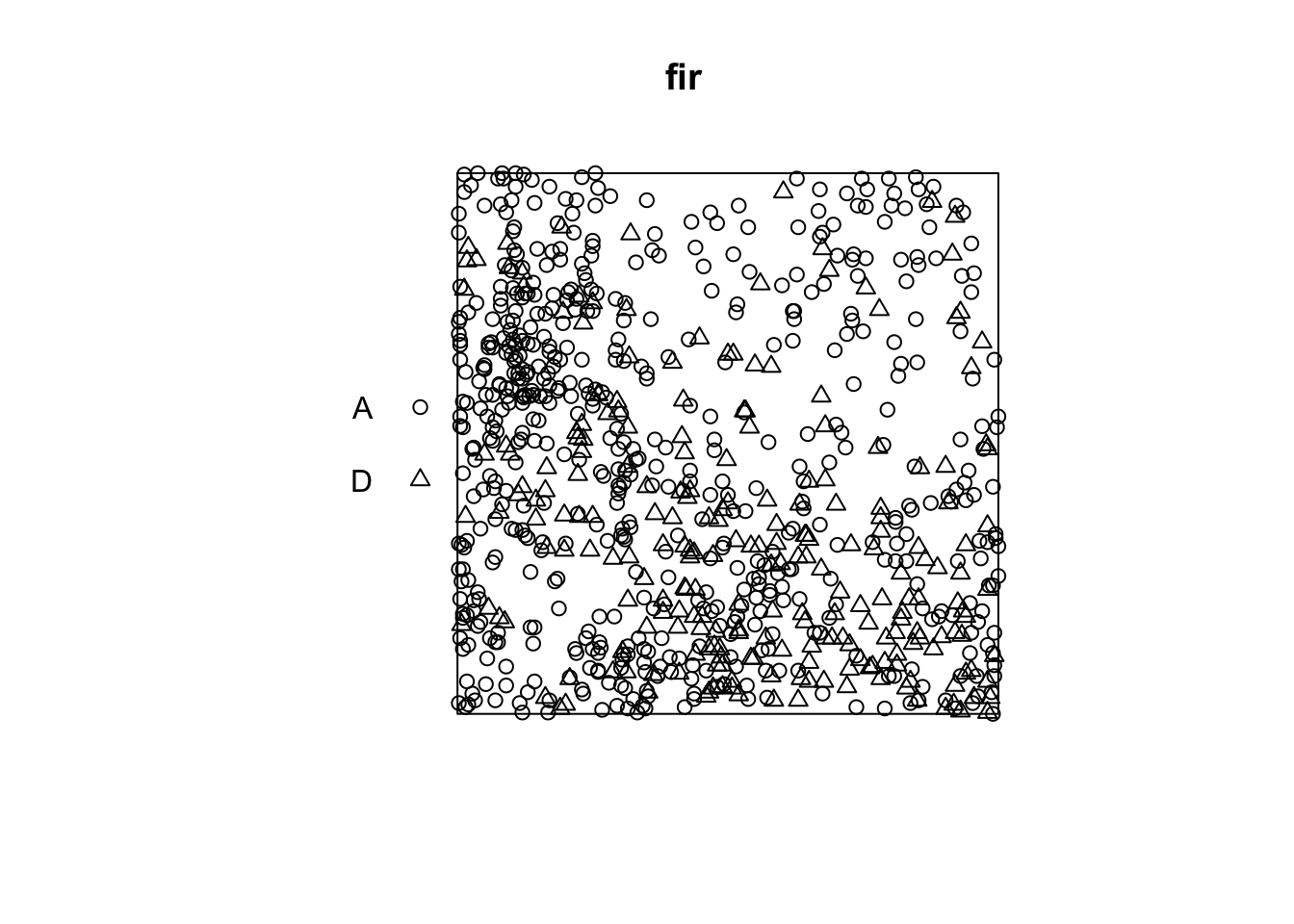

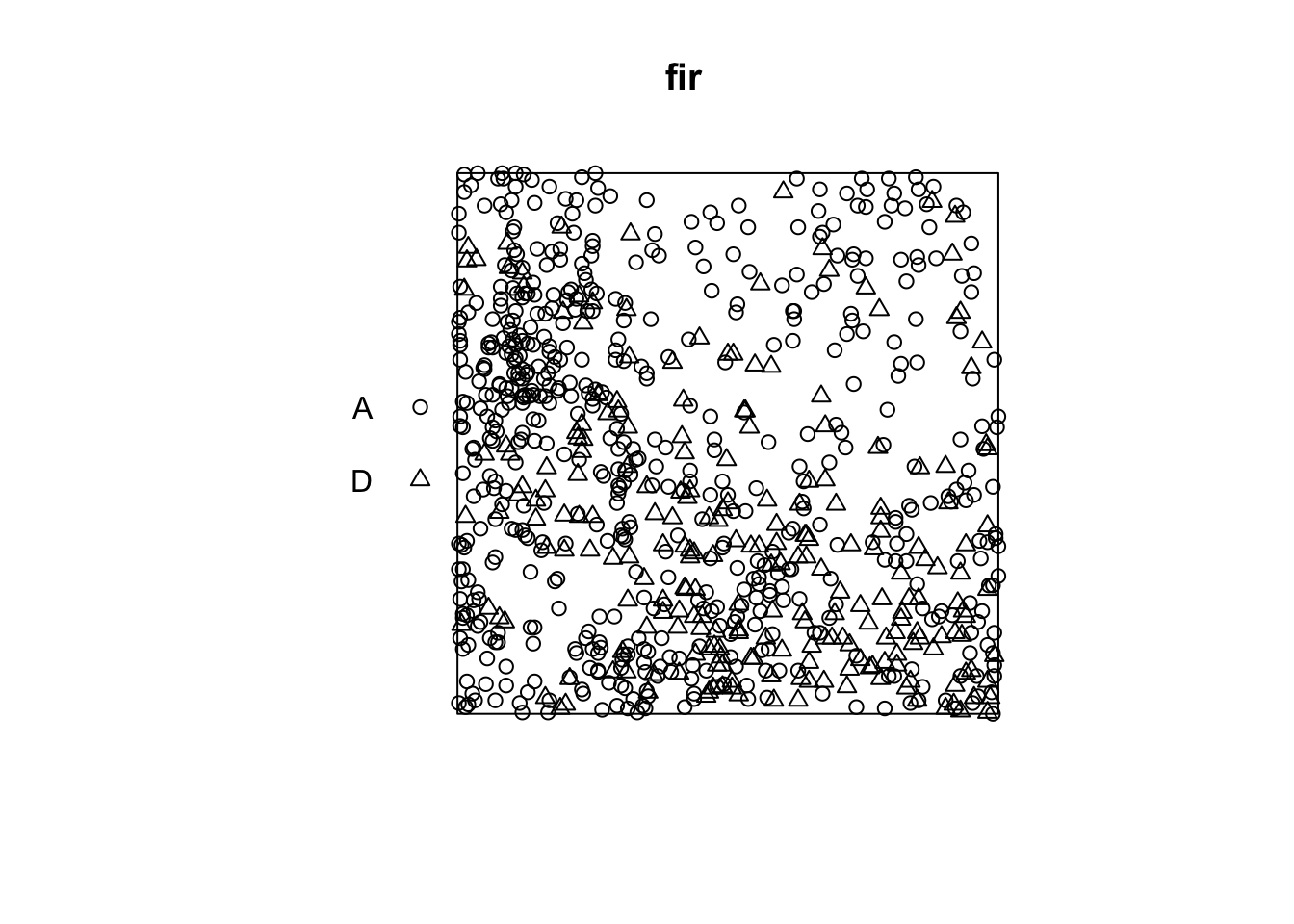

The fir.csv dataset contains the \((x, y)\) coordinates of 822 fir trees in a 1 hectare plot and their status (A = alive, D = dead) following a spruce budworm outbreak.

fir <- read.csv("data/fir.csv")

head(fir) x y status

1 31.50 1.00 A

2 85.25 30.75 D

3 83.50 38.50 A

4 84.00 37.75 A

5 83.00 33.25 A

6 33.25 0.25 Afir <- ppp(x = fir$x, y = fir$y, marks = as.factor(fir$status),

window = owin(xrange = c(0, 100), yrange = c(0, 100)))

plot(fir)

Suppose that we want to check whether fir mortality is independent or correlated between neighbouring trees. How does this question differ from the previous example, where we wanted to know if the position of the points of two species was independent?

In the previous example, the independence or interaction between the species referred to the formation of the pattern itself (whether or not seedlings of one species establish near those of the other species). Here, the characteristic of interest (survival) occurs after the establishment of the pattern, assuming that all those trees were alive at first and that some died as a result of the outbreak. So we take the position of the trees as fixed and we want to know whether the distribution of status (dead, alive) among those trees is random or shows a spatial pattern.

In Wiegand and Moloney’s textbook, the first situation (establishment of seedlings of two species) is called a bivariate pattern, so it is really two interacting patterns, while the second is a single pattern with a qualitative mark. The spatstat package in R does not differentiate between the two in terms of pattern definition (types of points are always represented by the marks argument), but the analysis methods applied to the two questions differ.

In the case of a pattern with a qualitative mark, we can define a mark connection function \(p_{ij}(r)\). For two points separated by a distance \(r\), this function gives the probability that the first point has the mark \(i\) and the second the mark \(j\). Under the null hypothesis where the marks are independent, this probability is equal to the product of the proportions of each mark in the entire pattern, \(p_{ij}(r) = p_i p_j\) independently of \(r\).

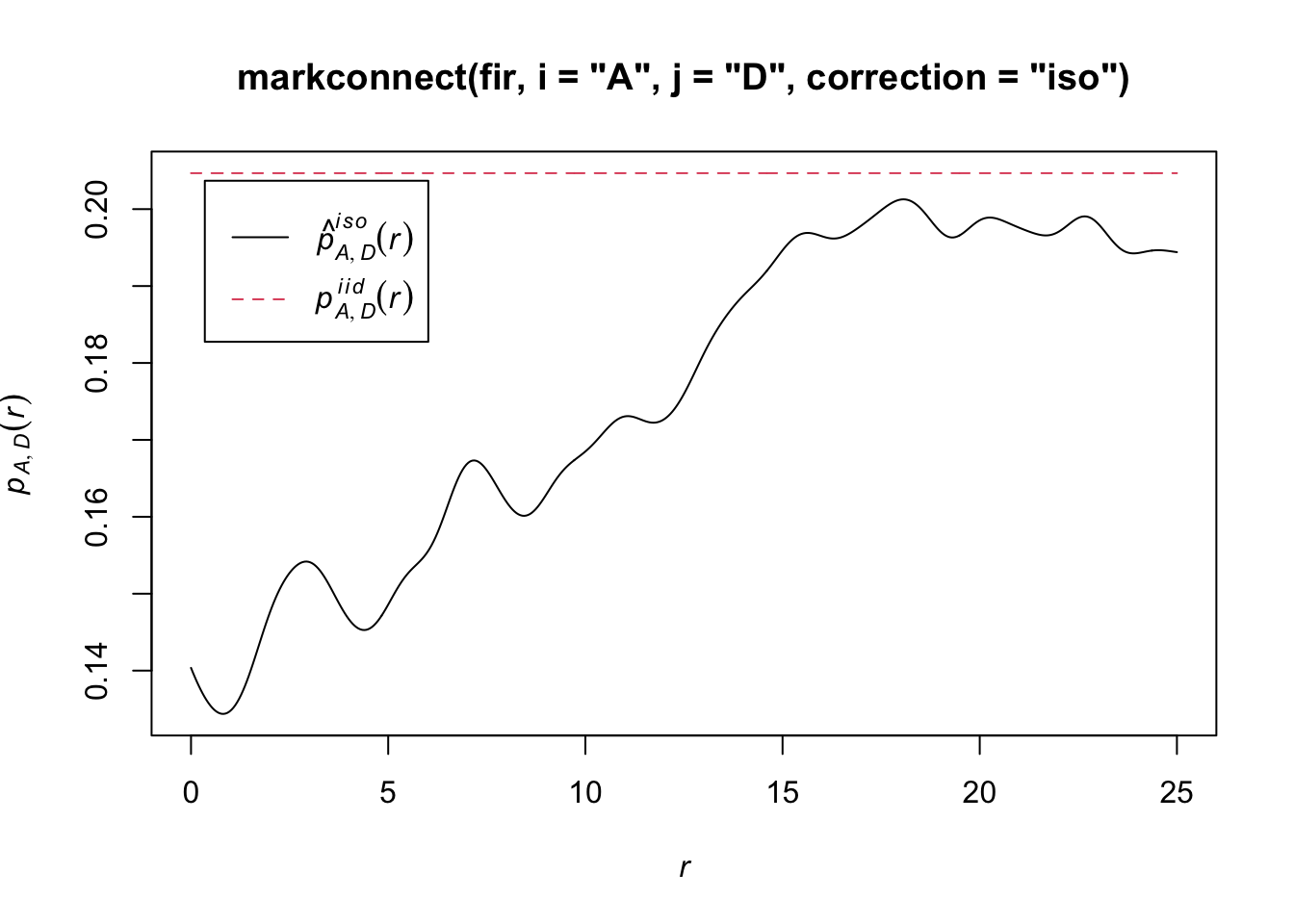

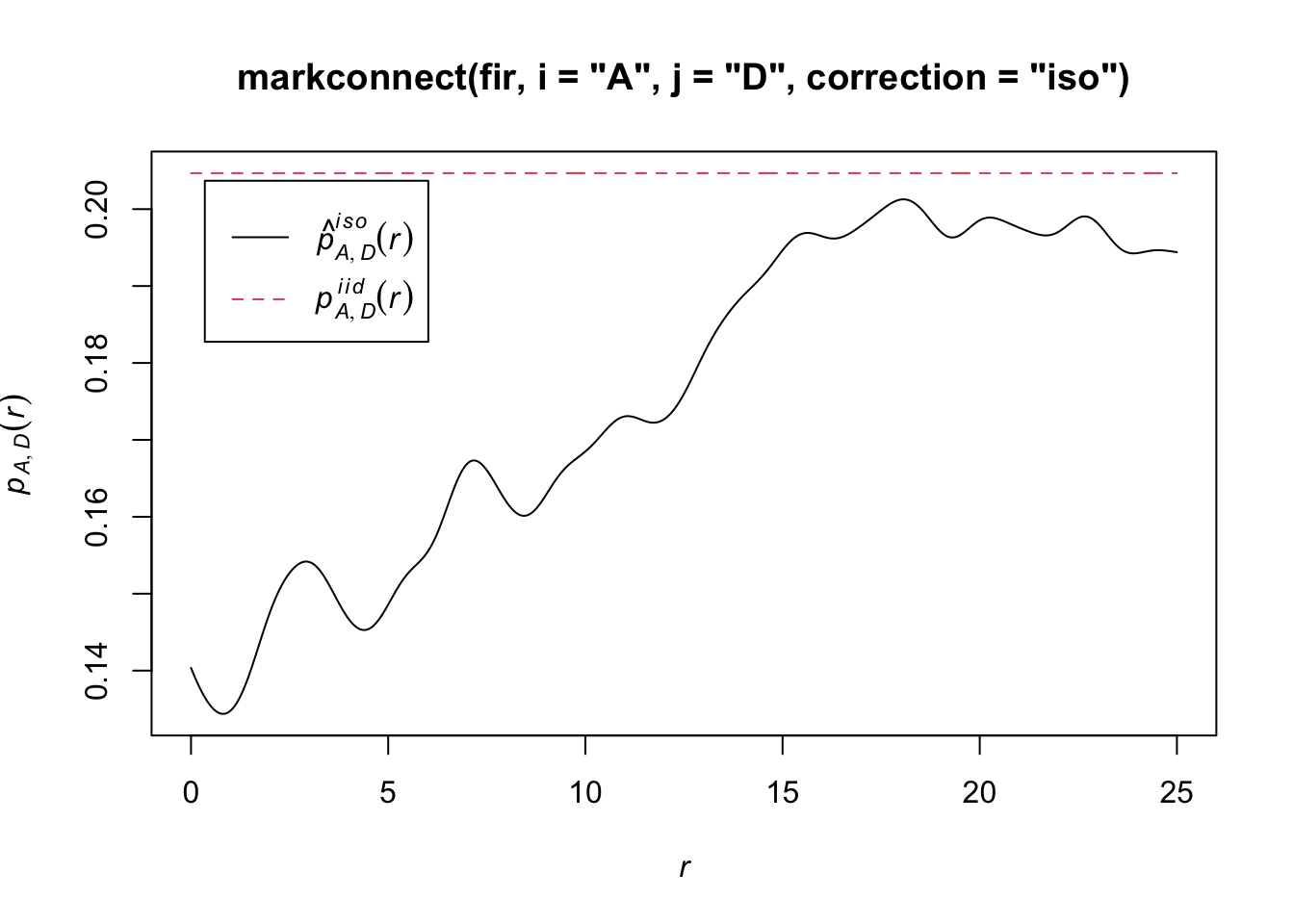

In spatstat, the mark connection function is computed with the markconnect function, where the marks \(i\) and \(j\) and the type of edge correction must be specified. In our example, we see that two closely spaced points are less likely to have a different status (A and D) than expected under the assumption of random and independent distribution of marks (red dotted line).

plot(markconnect(fir, i = "A", j = "D", correction = "iso"))

In this graph, the fluctuations in the function are due to the estimation error of a continuous \(r\) function from a limited number of discrete point pairs.

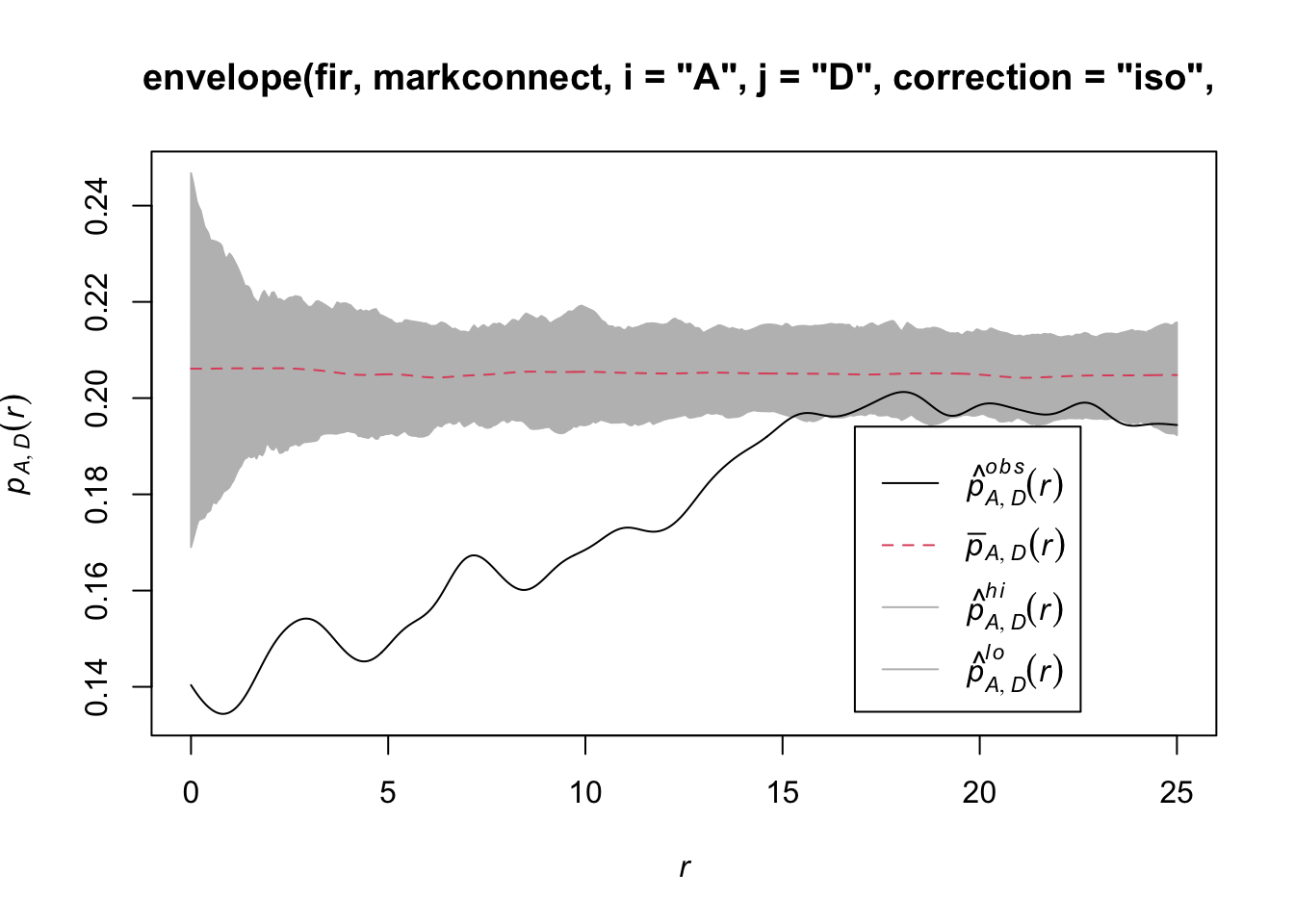

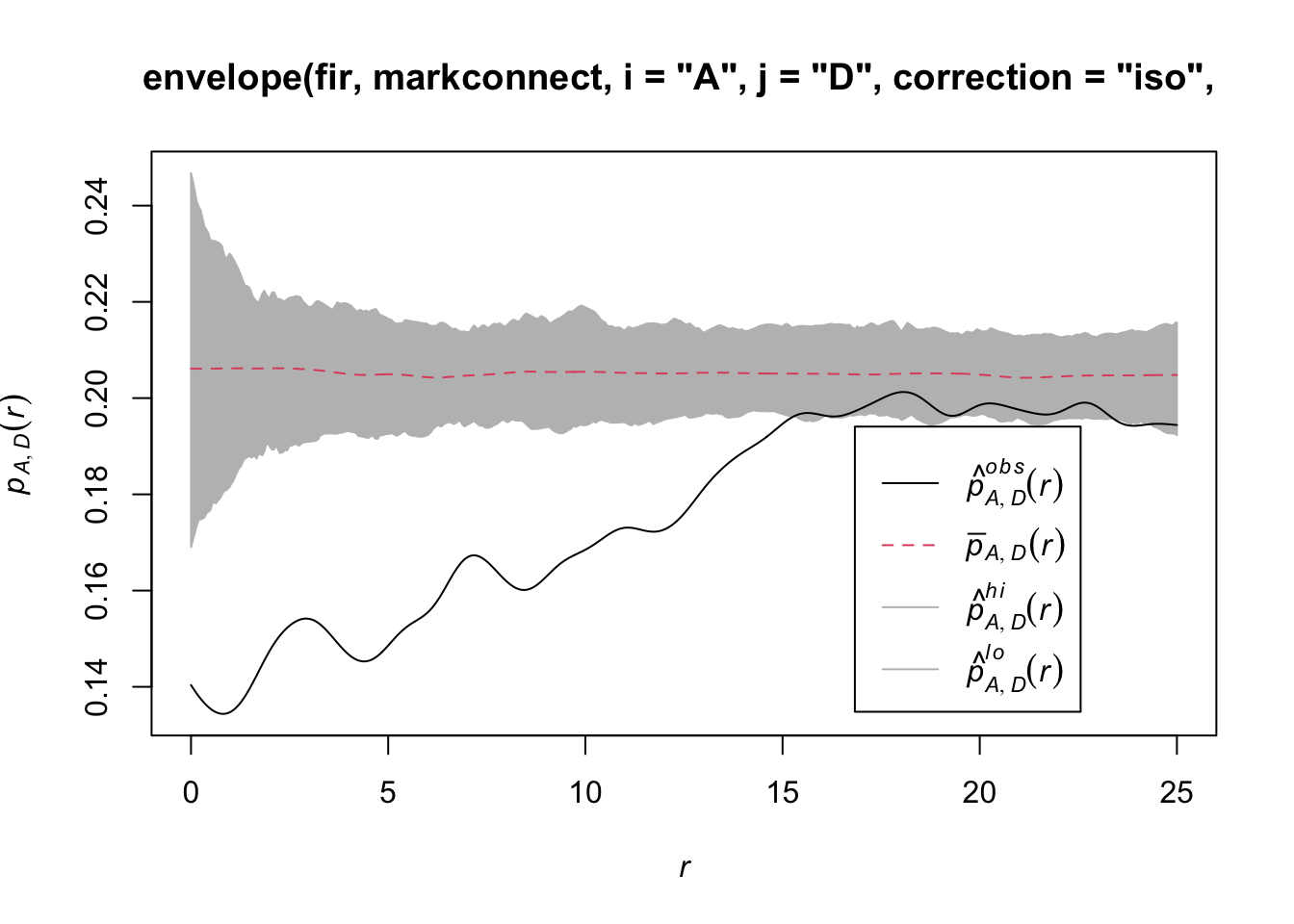

To simulate the null model in this case, we use the rlabel function, which randomly reassigns the marks among the points of the pattern, keeping the points’ positions fixed.

plot(envelope(fir, markconnect, i = "A", j = "D", correction = "iso",

nsim = 199, nrank = 5, simulate = rlabel))Generating 199 simulations by evaluating function ...

1, 2, 3, 4.6.8.10.12.14.16.18.20.22.24.26.28.30.32.34.36.38.40

.42.44.46.48.50.52.54.56.58.60.62.64.66.68.70.72.74.76.78.80

.82.84.86.88.90.92.94.96.98.100.102.104.106.108.110.112.114.116.118.120

.122.124.126.128.130.132.134.136.138.140.142.144.146.148.150.152.154.156.158.160

.162.164.166.168.170.172.174.176.178.180.182.184.186.188.190.192.194.196.198 199.

Done.

Note that since the rlabel function has only one required argument corresponding to the original point pattern, it was not necessary to specify: simulate = function(x) rlabel(x).

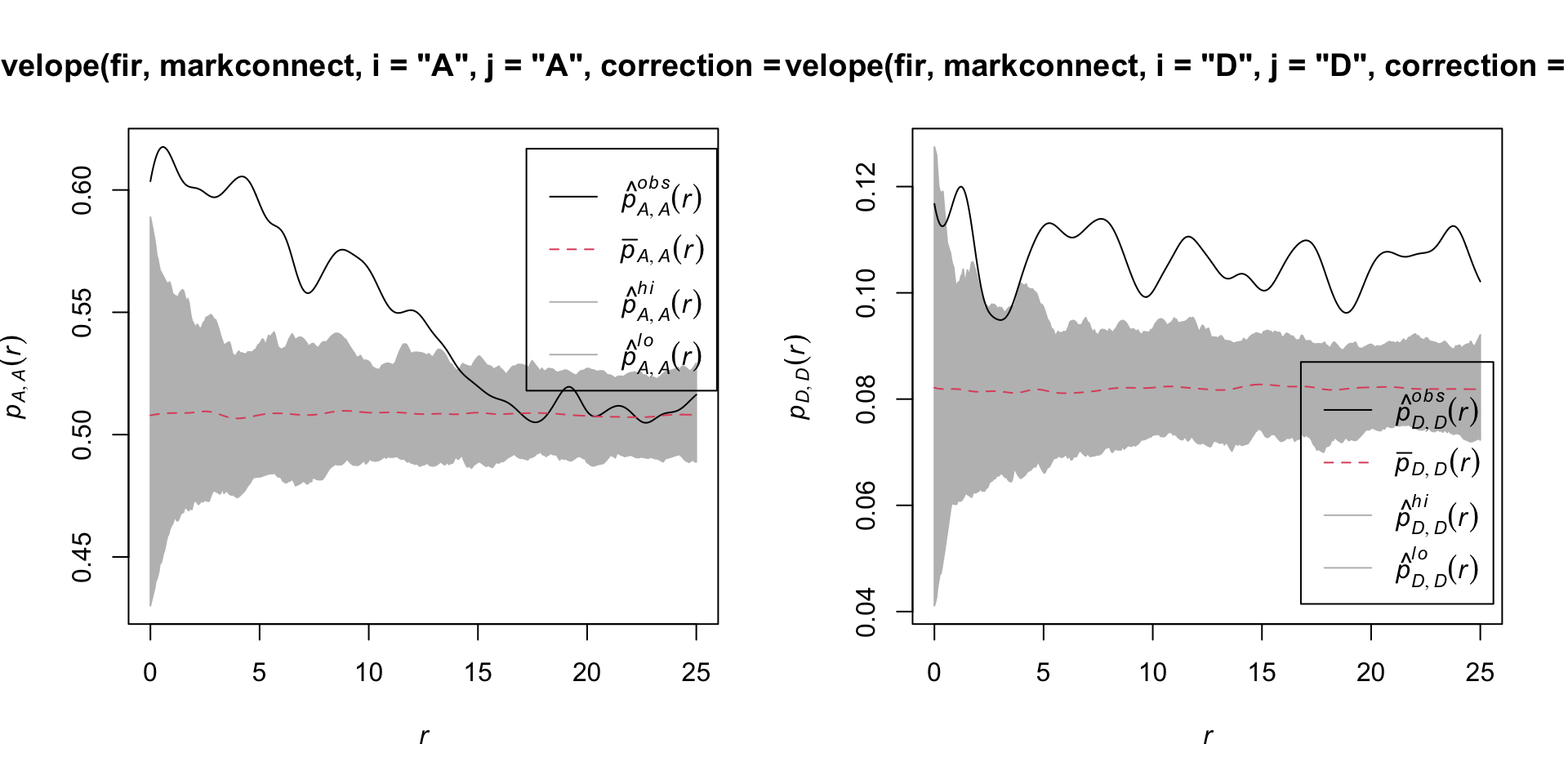

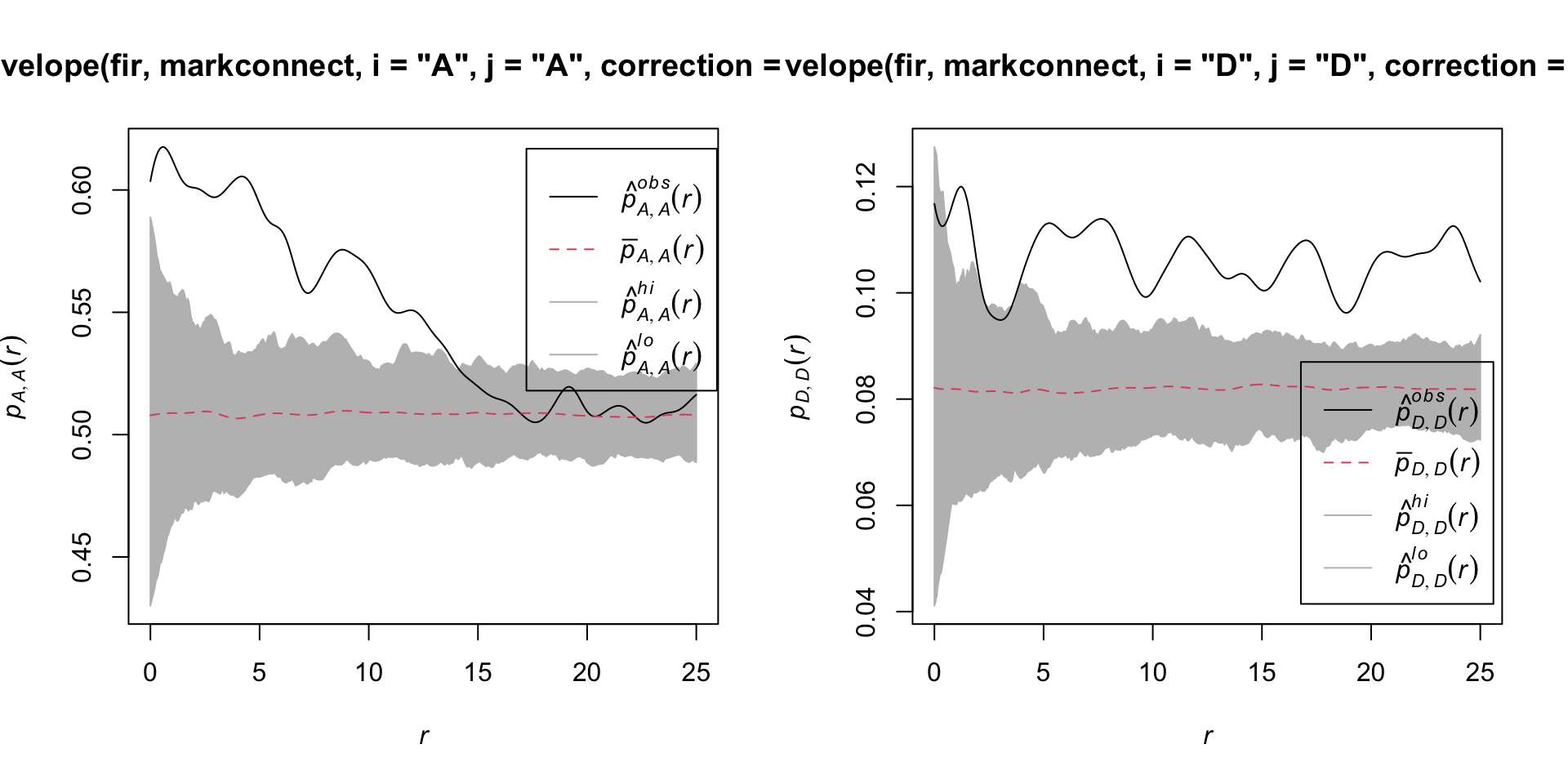

Here are the results for tree pairs of the same status A or D:

par(mfrow = c(1, 2))

plot(envelope(fir, markconnect, i = "A", j = "A", correction = "iso",

nsim = 199, nrank = 5, simulate = rlabel))Generating 199 simulations by evaluating function ...

1, 2, 3, 4.6.8.10.12.14.16.18.20.22.24.26.28.30.32.34.36.38.40

.42.44.46.48.50.52.54.56.58.60.62.64.66.68.70.72.74.76.78.80

.82.84.86.88.90.92.94.96.98.100.102.104.106.108.110.112.114.116.118.120

.122.124.126.128.130.132.134.136.138.140.142.144.146.148.150.152.154.156.158.160

.162.164.166.168.170.172.174.176.178.180.182.184.186.188.190.192.194.196.198 199.

Done.plot(envelope(fir, markconnect, i = "D", j = "D", correction = "iso",

nsim = 199, nrank = 5, simulate = rlabel))Generating 199 simulations by evaluating function ...

1, 2, 3, 4.6.8.10.12.14.16.18.20.22.24.26.28.30.32.34.36.38.40

.42.44.46.48.50.52.54.56.58.60.62.64.66.68.70.72.74.76.78.80

.82.84.86.88.90.92.94.96.98.100.102.104.106.108.110.112.114.116.118.120

.122.124.126.128.130.132.134.136.138.140.142.144.146.148.150.152.154.156.158.160

.162.164.166.168.170.172.174.176.178.180.182.184.186.188.190.192.194.196.198 199.

Done.

It therefore appears that fir mortality due to this outbreak is spatially aggregated, since trees located in close proximity to each other have a greater probability of sharing the same status than predicted by the null hypothesis.

References

Fortin, M.-J. and Dale, M.R.T. (2005) Spatial Analysis: A Guide for Ecologists. Cambridge University Press: Cambridge, UK.

Wiegand, T. and Moloney, K.A. (2013) Handbook of Spatial Point-Pattern Analysis in Ecology, CRC Press.

The dataset in the last example is a subet of the Lake Duparquet Research and Teaching Forest (LDRTF) data, available on Dryad here.

4 Solutions

Exercise 1

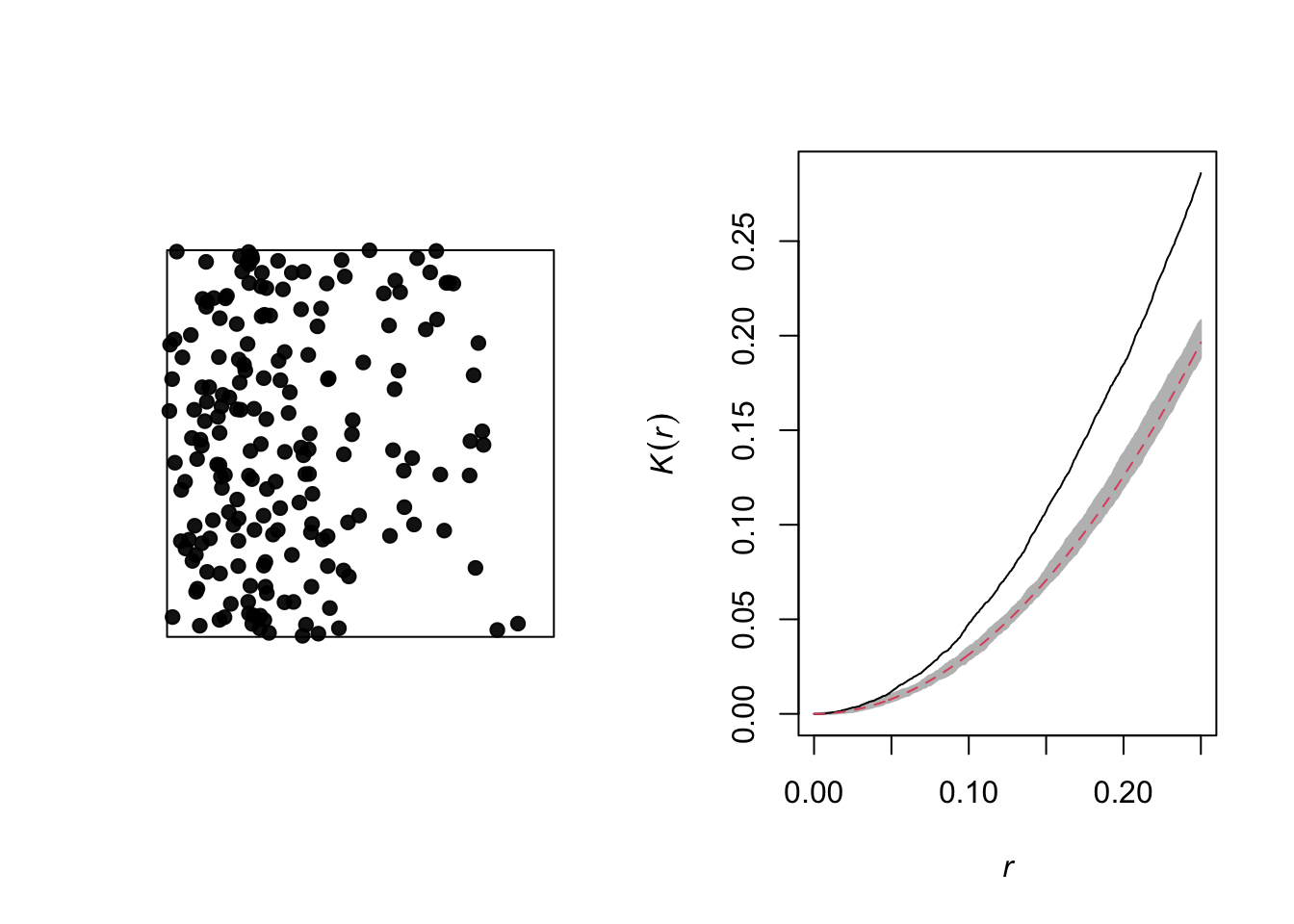

plot(envelope(semis_split[[2]], Kest, correction = "iso"))Generating 99 simulations of CSR ...

1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24, 25, 26, 27, 28, 29, 30, 31, 32, 33, 34, 35, 36, 37, 38, 39, 40,

41, 42, 43, 44, 45, 46, 47, 48, 49, 50, 51, 52, 53, 54, 55, 56, 57, 58, 59, 60, 61, 62, 63, 64, 65, 66, 67, 68, 69, 70, 71, 72, 73, 74, 75, 76, 77, 78, 79, 80,

81, 82, 83, 84, 85, 86, 87, 88, 89, 90, 91, 92, 93, 94, 95, 96, 97, 98, 99.

Done.

Poplar seedlings seem to be significantly aggregated according to the \(K\) function.

Exercise 2

dens_p <- density(semis_split[[2]], sigma = 5)

plot(dens_p)

plot(semis_split[[2]], add = TRUE)

khet_p <- envelope(semis_split[[2]], Kinhom, sigma = 5, correction = "iso",

nsim = 199, nrank = 5, simulate = function(x) rpoispp(dens_p))Generating 199 simulations by evaluating function ...

1, 2, 3, 4.6.8.10.12.14.16.18.20.22.24.26.28.30.32.34.36.38.40

.42.44.46.48.50.52.54.56.58.60.62.64.66.68.70.72.74.76.78.80

.82.84.86.88.90.92.94.96.98.100.102.104.106.108.110.112.114.116.118.120

.122.124.126.128.130.132.134.136.138.140.142.144.146.148.150.152.154.156.158.160

.162.164.166.168.170.172.174.176.178.180.182.184.186.188.190.192.194.196.198 199.

Done.plot(khet_p)

Here, as we estimate density variations at a larger scale, even after accounting for this variation, the poplar seedlings seem to be aggregated at a small scale.

5 Spatial correlation of a variable

Correlation between measurements of a variable taken at nearby points often occurs in environmental data. This principle is sometimes referred to as the “first law of geography” and is expressed in the following quote from Waldo Tobler: “Everything is related to everything else, but near things are more related than distant things”.

In statistics, we often refer to autocorrelation as the correlation between measurements of the same variable taken at different times (temporal autocorrelation) or places (spatial autocorrelation).

Intrinsic or induced dependence

There are two basic types of spatial dependence on a measured variable \(y\): an intrinsic dependence on \(y\), or a dependence induced by external variables influencing \(y\), which are themselves spatially correlated.

For example, suppose that the abundance of a species is correlated between two sites located near each other:

this spatial dependence can be induced if it is due to a spatial correlation of habitat factors that are favorable or unfavorable to the species;

or it can be intrinsic if it is due to the dispersion of individuals to nearby sites.

In many cases, both types of dependence affect a given variable.

If the dependence is simply induced and the external variables that cause it are included in the model explaining \(y\), then the model residuals will be independent and we can use all the methods already seen that ignore spatial correlation.

However, if the dependence is intrinsic or due to unmeasured external factors, then the spatial correlation of the residuals in the model will have to be taken into account.

Different ways to model spatial effects

In this training, we will directly model the spatial correlations of our data. It is useful to compare this approach to other ways of including spatial aspects in a statistical model.

First, we could include predictors in the model that represent position (e.g., longitude, latitude). Such predictors may be useful for detecting a systematic large-scale trend or gradient, whether or not the trend is linear (e.g., with a generalized additive model).

In contrast to this approach, the models we will see now serve to model a spatial correlation in the random fluctuations of a variable (i.e., in the residuals after removing any systematic effect).

Mixed models use random effects to represent the non-independence of data on the basis of their grouping, i.e., after accounting for systematic fixed effects, data from the same group are more similar (their residual variation is correlated) than data from different groups. These groups were sometimes defined according to spatial criteria (observations grouped into sites).

However, in the context of a random group effect, all groups are as different from each other, e.g., two sites within 100 km of each other are no more or less similar than two sites 2 km apart.

The methods we will see here and in the next parts of the training therefore allow us to model non-independence on a continuous scale (closer = more correlated) rather than just discrete (hierarchy of groups).

6 Geostatistical models

Geostatistics refers to a group of techniques that originated in the earth sciences. Geostatistics is concerned with variables that are continuously distributed in space and where a number of points are sampled to estimate this distribution. A classic example of these techniques comes from the mining field, where the aim was to create a map of the concentration of ore at a site from samples taken at different points on the site.

For these models, we will assume that \(z(x, y)\) is a stationary spatial variable measured at points with coordinates \(x\) and \(y\).

Variogram

A central aspect of geostatistics is the estimation of the variogram \(\gamma_z\) . The variogram is equal to half the mean square difference between the values of \(z\) for two points \((x_i, y_i)\) and \((x_j, y_j)\) separated by a distance \(h\).

\[\gamma_z(h) = \frac{1}{2} \text{E} \left[ \left( z(x_i, y_i) - z(x_j, y_j) \right)^2 \right]_{d_{ij} = h}\]

In this equation, the \(\text{E}\) function with the index \(d_{ij}=h\) designates the statistical expectation (i.e., the mean) of the squared deviation between the values of \(z\) for points separated by a distance \(h\).

If we want instead to express the autocorrelation \(\rho_z(h)\) between measures of \(z\) separated by a distance \(h\), it is related to the variogram by the equation:

\[\gamma_z = \sigma_z^2(1 - \rho_z)\] ,

where \(\sigma_z^2\) is the global variance of \(z\).

Note that \(\gamma_z = \sigma_z^2\) when we reach a distance where the measurements of \(z\) are independent, so \(\rho_z = 0\). In this case, we can see that \(\gamma_z\) is similar to a variance, although it is sometimes called “semivariogram” or “semivariance” because of the 1/2 factor in the above equation.

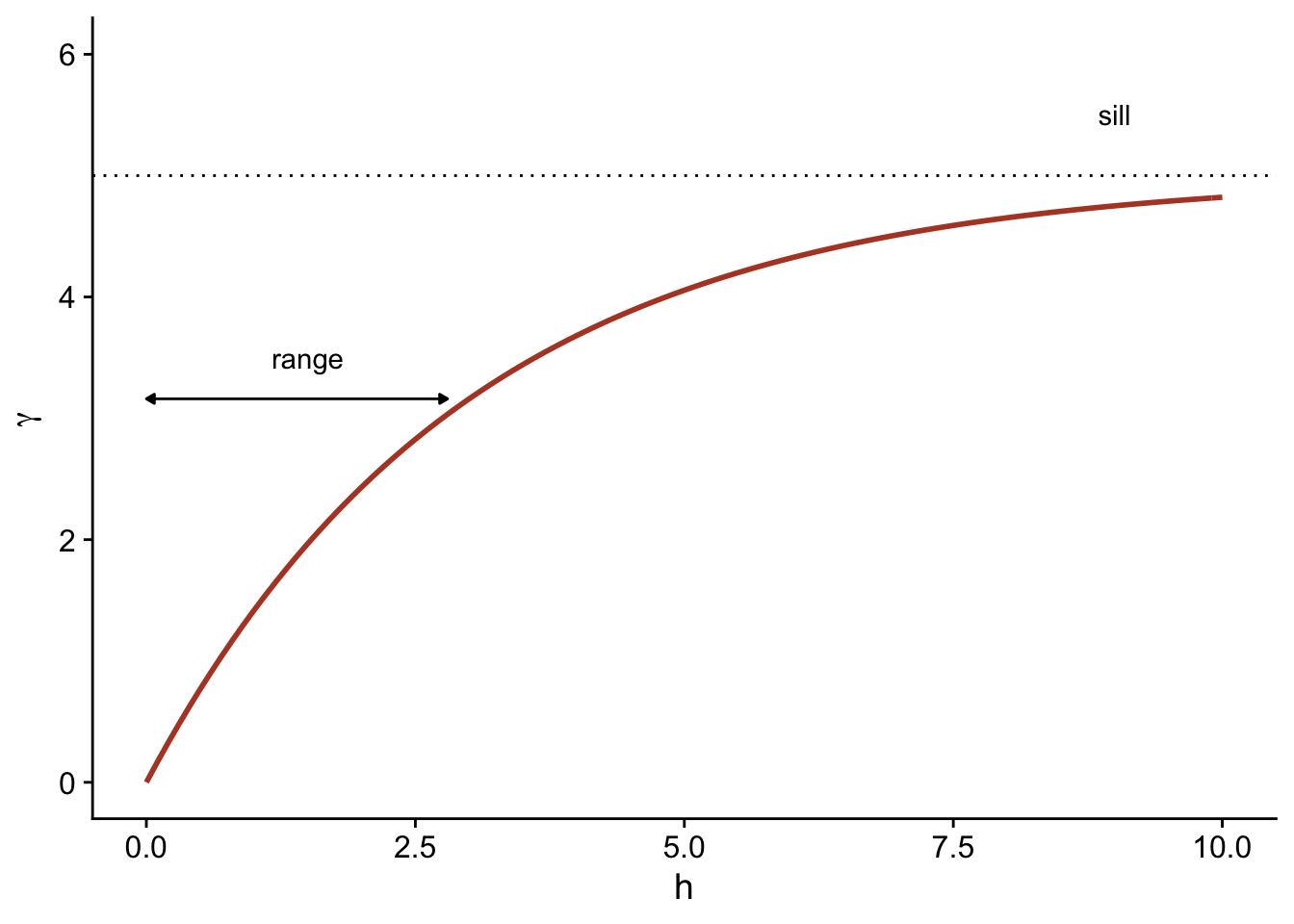

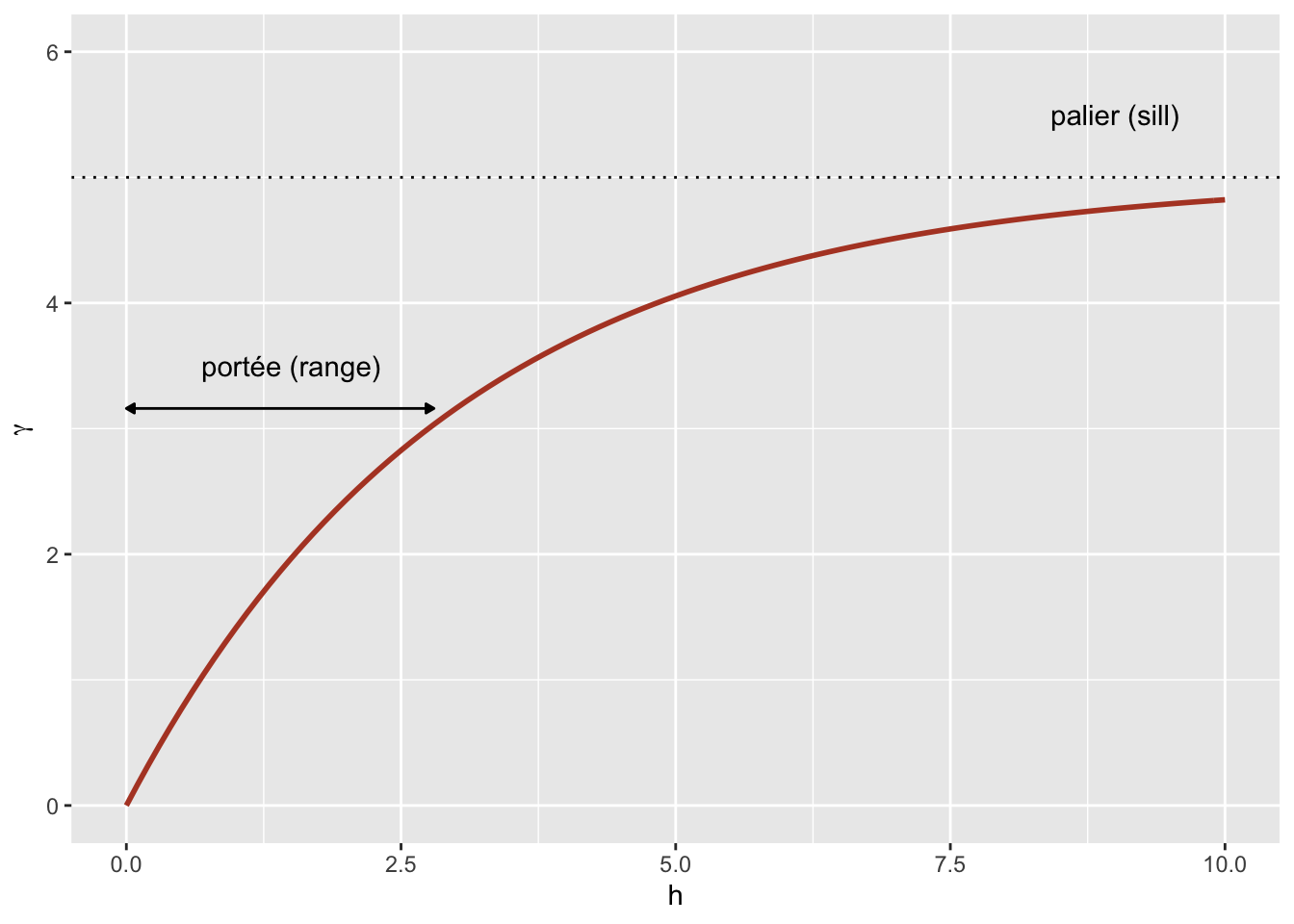

Theoretical models for the variogram

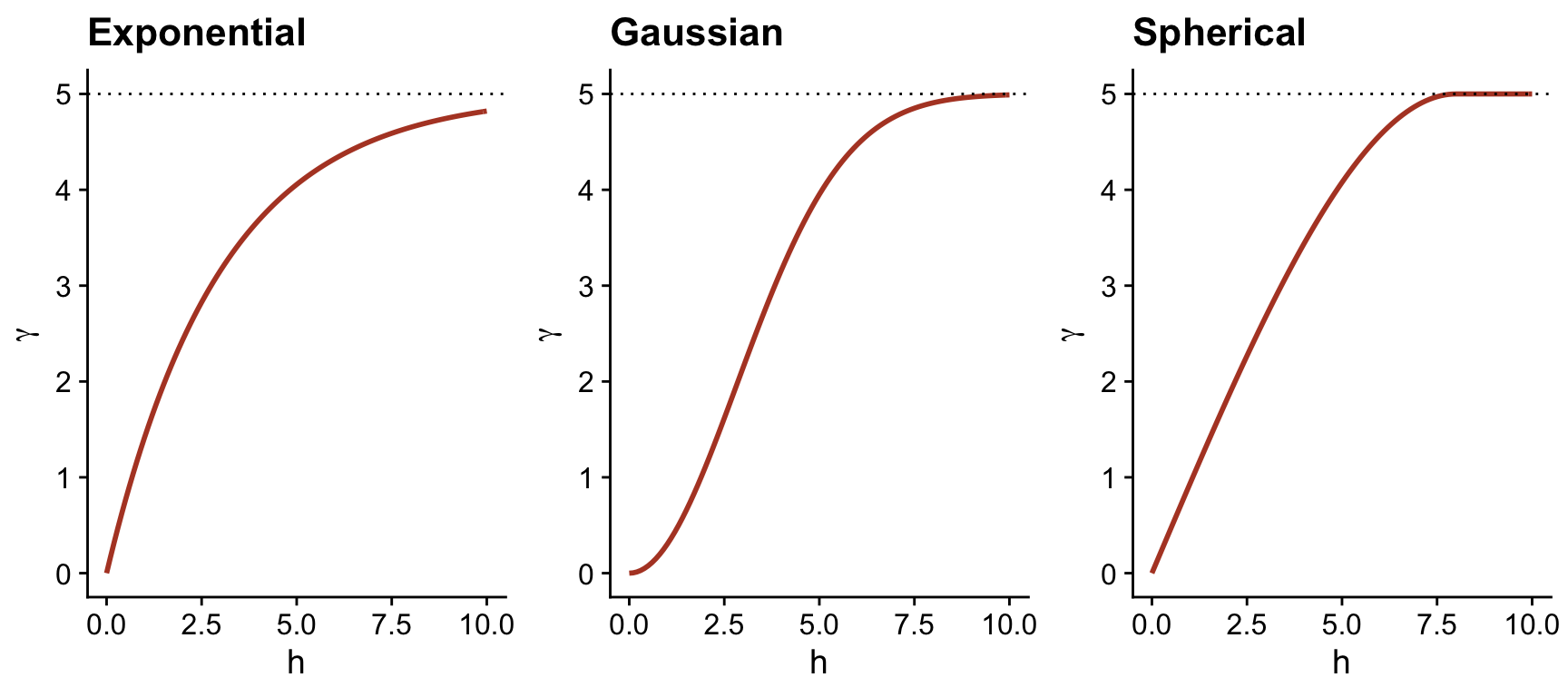

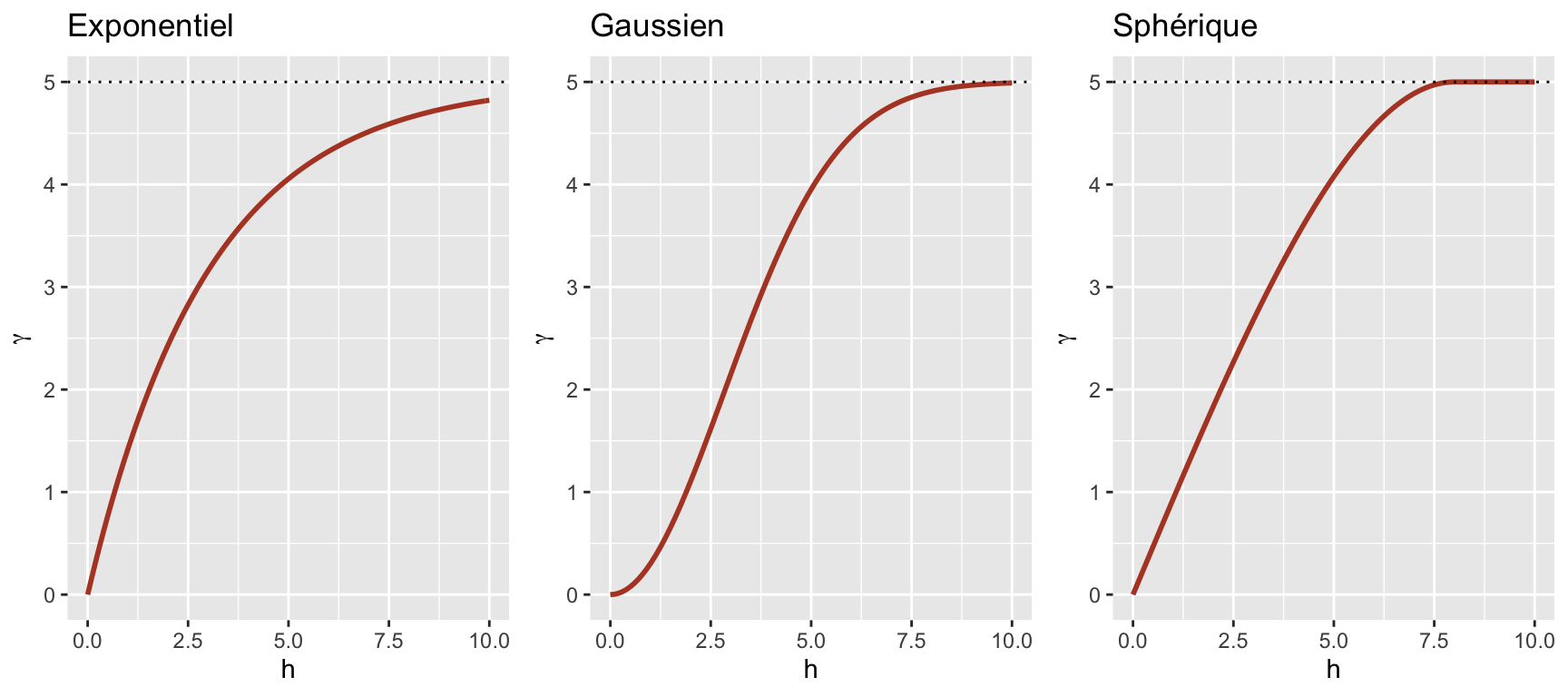

Several parametric models have been proposed to represent the spatial correlation as a function of the distance between sampling points. Let us first consider a correlation that decreases exponentially:

\[\rho_z(h) = e^{-h/r}\]

Here, \(\rho_z = 1\) for \(h = 0\) and the correlation is multiplied by \(1/e \approx 0.37\) each time the distance increases by \(r\). In this context, \(r\) is called the range of the correlation.

From the above equation, we can calculate the corresponding variogram.

\[\gamma_z(h) = \sigma_z^2 (1 - e^{-h/r})\]

Here is a graphical representation of this variogram.

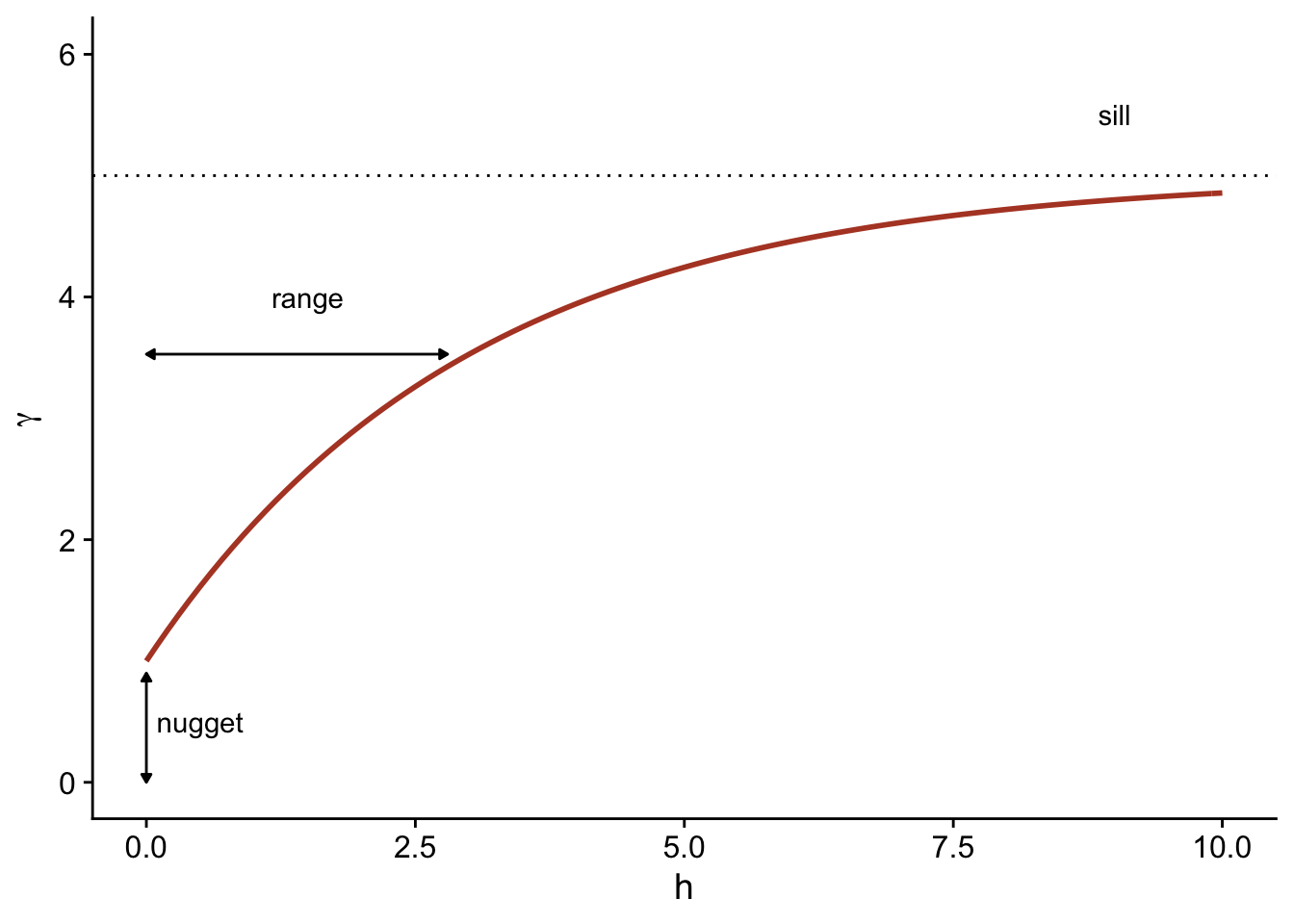

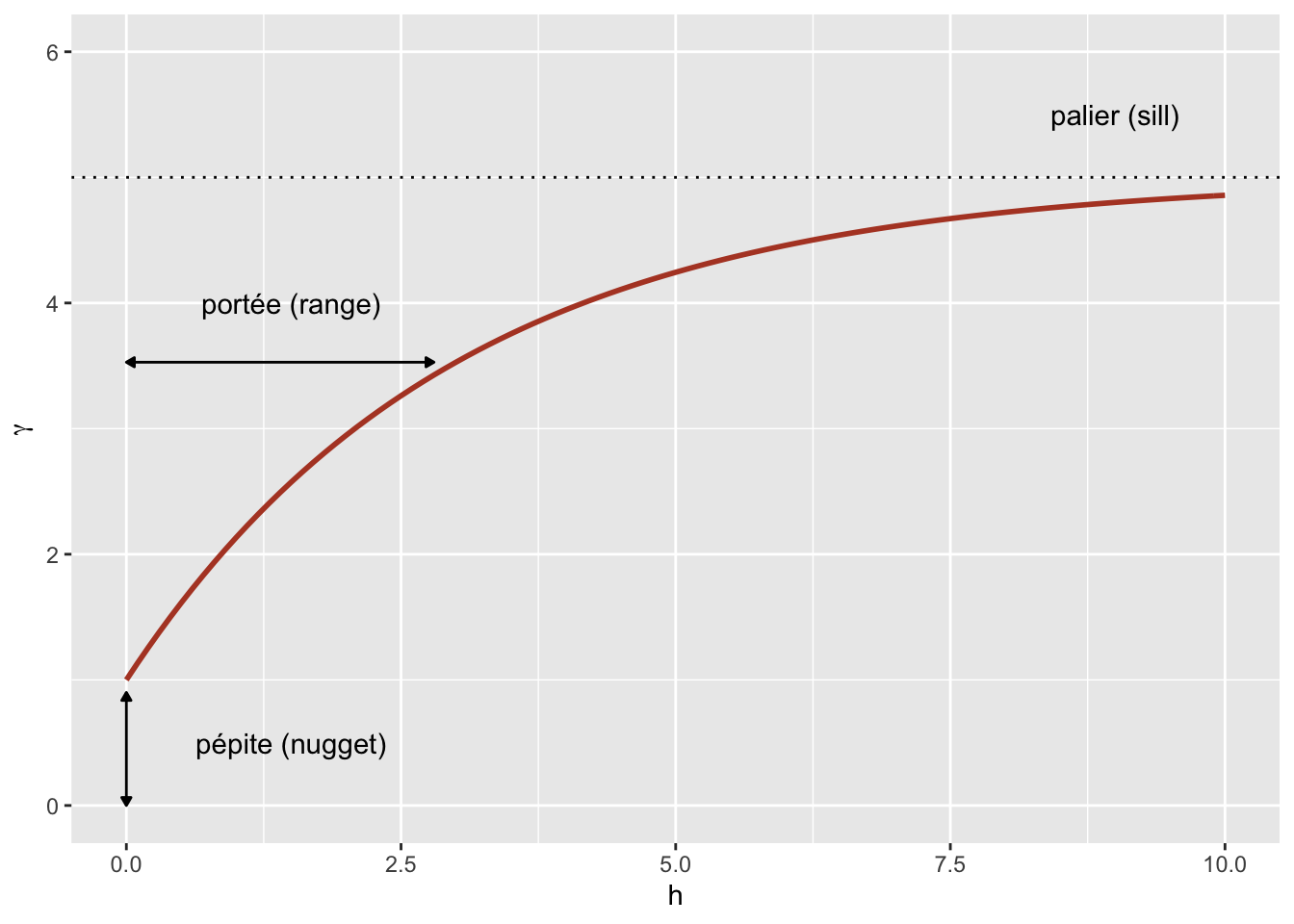

Because of the exponential function, the value of \(\gamma\) at large distances approaches the global variance \(\sigma_z^2\) without exactly reaching it. This asymptote is called a sill in the geostatistical context and is represented by the symbol \(s\).

Finally, it is sometimes unrealistic to assume a perfect correlation when the distance tends towards 0, because of a possible variation of \(z\) at a very small scale. A nugget effect, denoted \(n\), can be added to the model so that \(\gamma\) approaches \(n\) (rather than 0) if \(h\) tends towards 0. The term nugget comes from the mining origin of these techniques, where a nugget could be the source of a sudden small-scale variation in the concentration of a mineral.

By adding the nugget effect, the remainder of the variogram is “compressed” to keep the same sill, resulting in the following equation.

\[\gamma_z(h) = n + (s - n) (1 - e^{-h/r})\]

In the gstat package that we use below, the term \((s-n)\) is called a partial sill or psill for the exponential portion of the variogram.

In addition to the exponential model, two other common theoretical models for the variogram are the Gaussian model (where the correlation follows a half-normal curve), and the spherical model (where the variogram increases linearly at the start and then curves and reaches the plateau at a distance equal to its range \(r\)). The spherical model thus allows the correlation to be exactly 0 at large distances, rather than gradually approaching zero in the case of the other models.

| Model | \(\rho(h)\) | \(\gamma(h)\) |

|---|---|---|

| Exponential | \(\exp\left(-\frac{h}{r}\right)\) | \(s \left(1 - \exp\left(-\frac{h}{r}\right)\right)\) |

| Gaussian | \(\exp\left(-\frac{h^2}{r^2}\right)\) | \(s \left(1 - \exp\left(-\frac{h^2}{r^2}\right)\right)\) |

| Spherical \((h < r)\) * | \(1 - \frac{3}{2}\frac{h}{r} + \frac{1}{2}\frac{h^3}{r^3}\) | \(s \left(\frac{3}{2}\frac{h}{r} - \frac{1}{2}\frac{h^3}{r^3} \right)\) |

* For the spherical model, \(\rho = 0\) and \(\gamma = s\) if \(h \ge r\).

Empirical variogram

To estimate \(\gamma_z(h)\) from empirical data, we need to define distance classes, thus grouping different distances within a margin of \(\pm \delta\) around a distance \(h\), then calculating the mean square deviation for the pairs of points in that distance class.

\[\hat{\gamma_z}(h) = \frac{1}{2 N_{\text{paires}}} \sum \left[ \left( z(x_i, y_i) - z(x_j, y_j) \right)^2 \right]_{d_{ij} = h \pm \delta}\]

We will see in the next section how to estimate a variogram in R.

Regression model with spatial correlation

The following equation represents a multiple linear regression including residual spatial correlation:

\[v = \beta_0 + \sum_i \beta_i u_i + z + \epsilon\]

Here, \(v\) designates the response variable and \(u\) the predictors, to avoid confusion with the spatial coordinates \(x\) and \(y\).

In addition to the residual \(\epsilon\) that is independent between observations, the model includes a term \(z\) that represents the spatially correlated portion of the residual variance.

Here are suggested steps to apply this type of model:

Fit the regression model without spatial correlation.

Verify the presence of spatial correlation from the empirical variogram of the residuals.

Fit one or more regression models with spatial correlation and select the one that shows the best fit to the data.

7 Geostatistical models in R

The gstat package contains functions related to geostatistics. For this example, we will use the oxford dataset from this package, which contains measurements of physical and chemical properties for 126 soil samples from a site, along with their coordinates XCOORD and YCOORD.

library(gstat)

data(oxford)

str(oxford)'data.frame': 126 obs. of 22 variables:

$ PROFILE : num 1 2 3 4 5 6 7 8 9 10 ...

$ XCOORD : num 100 100 100 100 100 100 100 100 100 100 ...

$ YCOORD : num 2100 2000 1900 1800 1700 1600 1500 1400 1300 1200 ...

$ ELEV : num 598 597 610 615 610 595 580 590 598 588 ...

$ PROFCLASS: Factor w/ 3 levels "Cr","Ct","Ia": 2 2 2 3 3 2 3 2 3 3 ...

$ MAPCLASS : Factor w/ 3 levels "Cr","Ct","Ia": 2 3 3 3 3 2 2 3 3 3 ...

$ VAL1 : num 3 3 4 4 3 3 4 4 4 3 ...

$ CHR1 : num 3 3 3 3 3 2 2 3 3 3 ...

$ LIME1 : num 4 4 4 4 4 0 2 1 0 4 ...

$ VAL2 : num 4 4 5 8 8 4 8 4 8 8 ...

$ CHR2 : num 4 4 4 2 2 4 2 4 2 2 ...

$ LIME2 : num 4 4 4 5 5 4 5 4 5 5 ...

$ DEPTHCM : num 61 91 46 20 20 91 30 61 38 25 ...

$ DEP2LIME : num 20 20 20 20 20 20 20 20 40 20 ...

$ PCLAY1 : num 15 25 20 20 18 25 25 35 35 12 ...

$ PCLAY2 : num 10 10 20 10 10 20 10 20 10 10 ...

$ MG1 : num 63 58 55 60 88 168 99 59 233 87 ...

$ OM1 : num 5.7 5.6 5.8 6.2 8.4 6.4 7.1 3.8 5 9.2 ...

$ CEC1 : num 20 22 17 23 27 27 21 14 27 20 ...

$ PH1 : num 7.7 7.7 7.5 7.6 7.6 7 7.5 7.6 6.6 7.5 ...

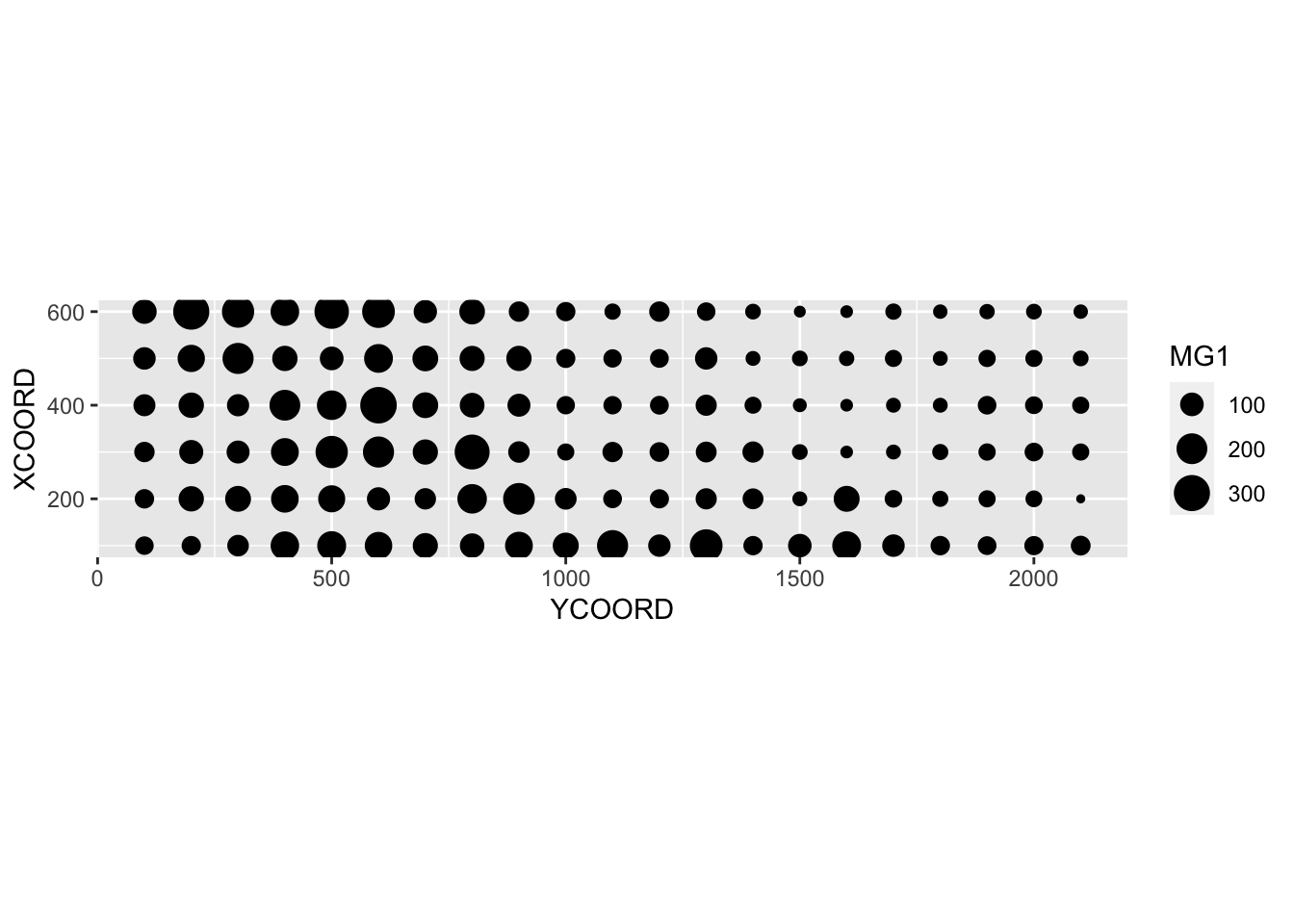

$ PHOS1 : num 13 9.2 10.5 8.8 13 9.3 10 9 15 12.6 ...

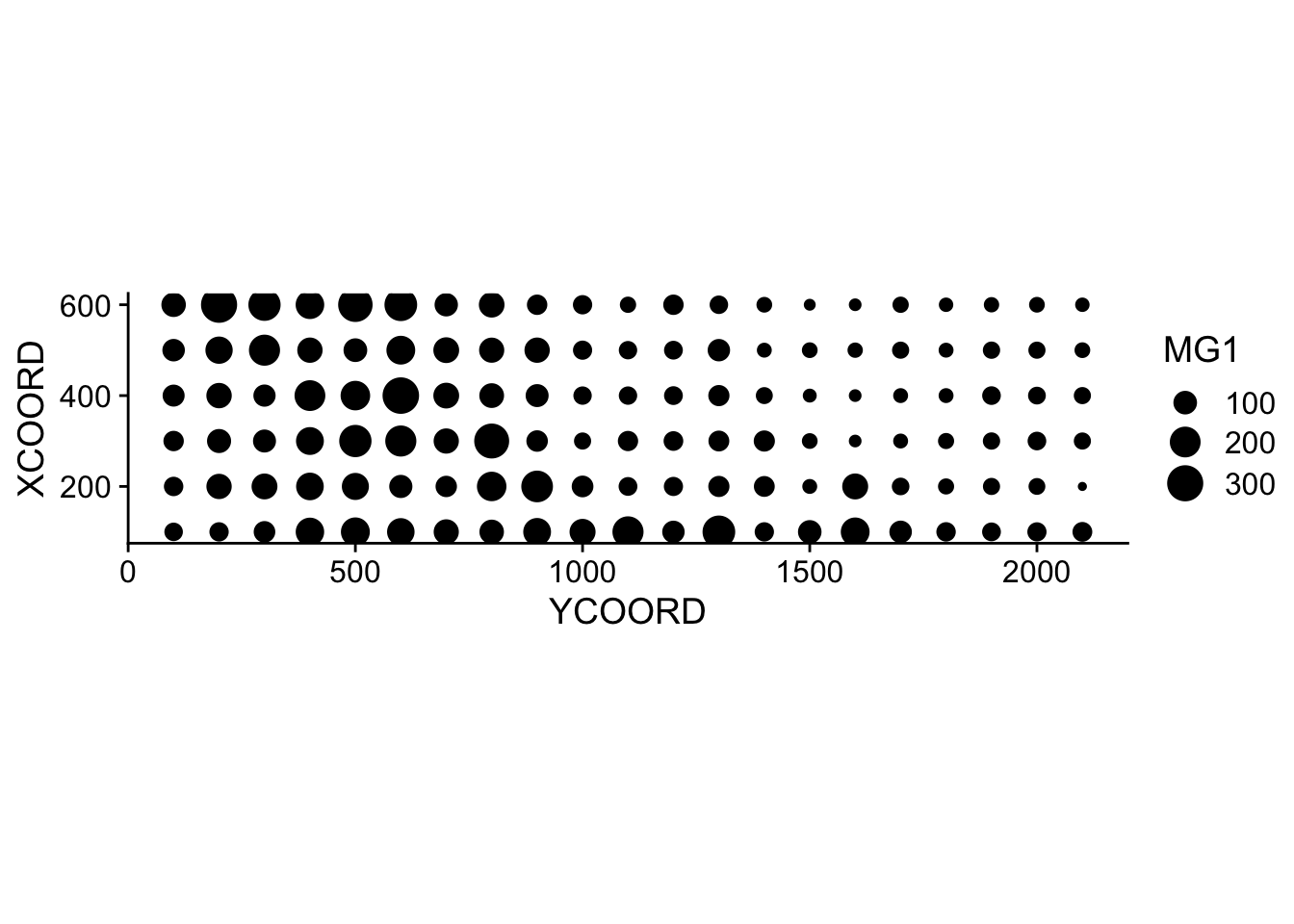

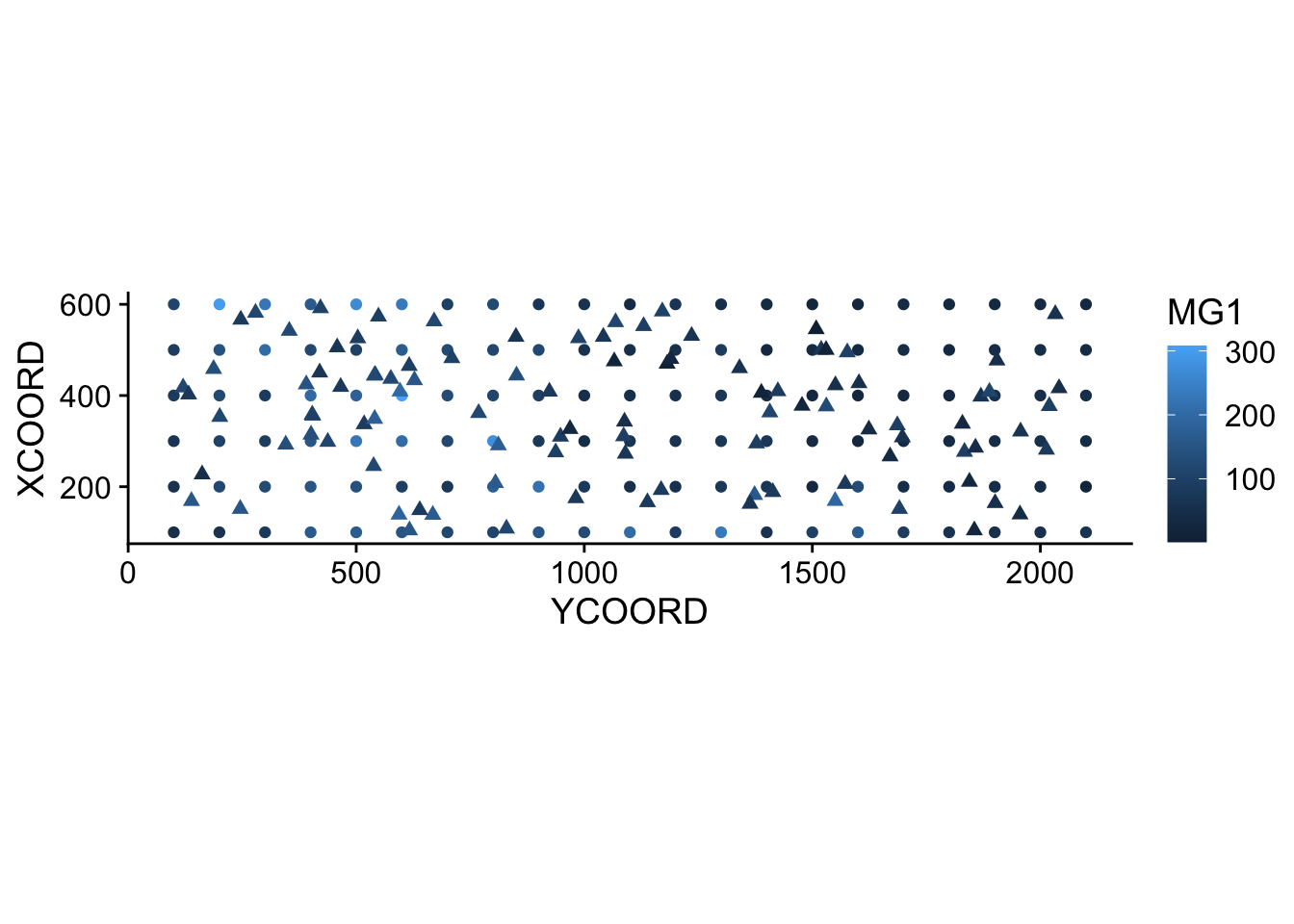

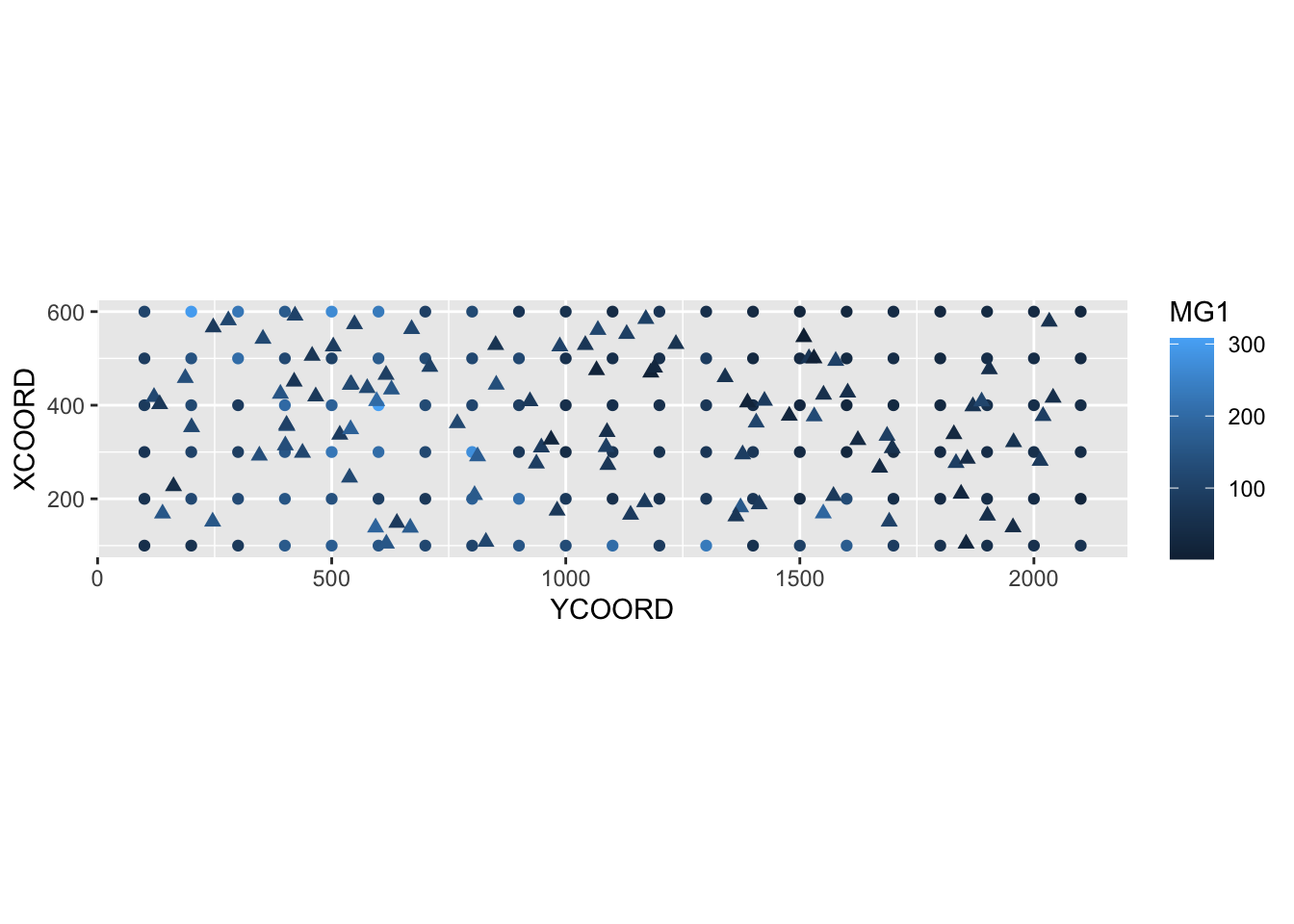

$ POT1 : num 196 157 115 172 238 164 312 184 123 282 ...Suppose that we want to model the magnesium concentration (MG1), represented as a function of the spatial position in the following graph.

library(ggplot2)

ggplot(oxford, aes(x = YCOORD, y = XCOORD, size = MG1)) +

geom_point() +

coord_fixed()

Note that the \(x\) and \(y\) axes have been inverted to save space. The coord_fixed() function of ggplot2 ensures that the scale is the same on both axes, which is useful for representing spatial data.

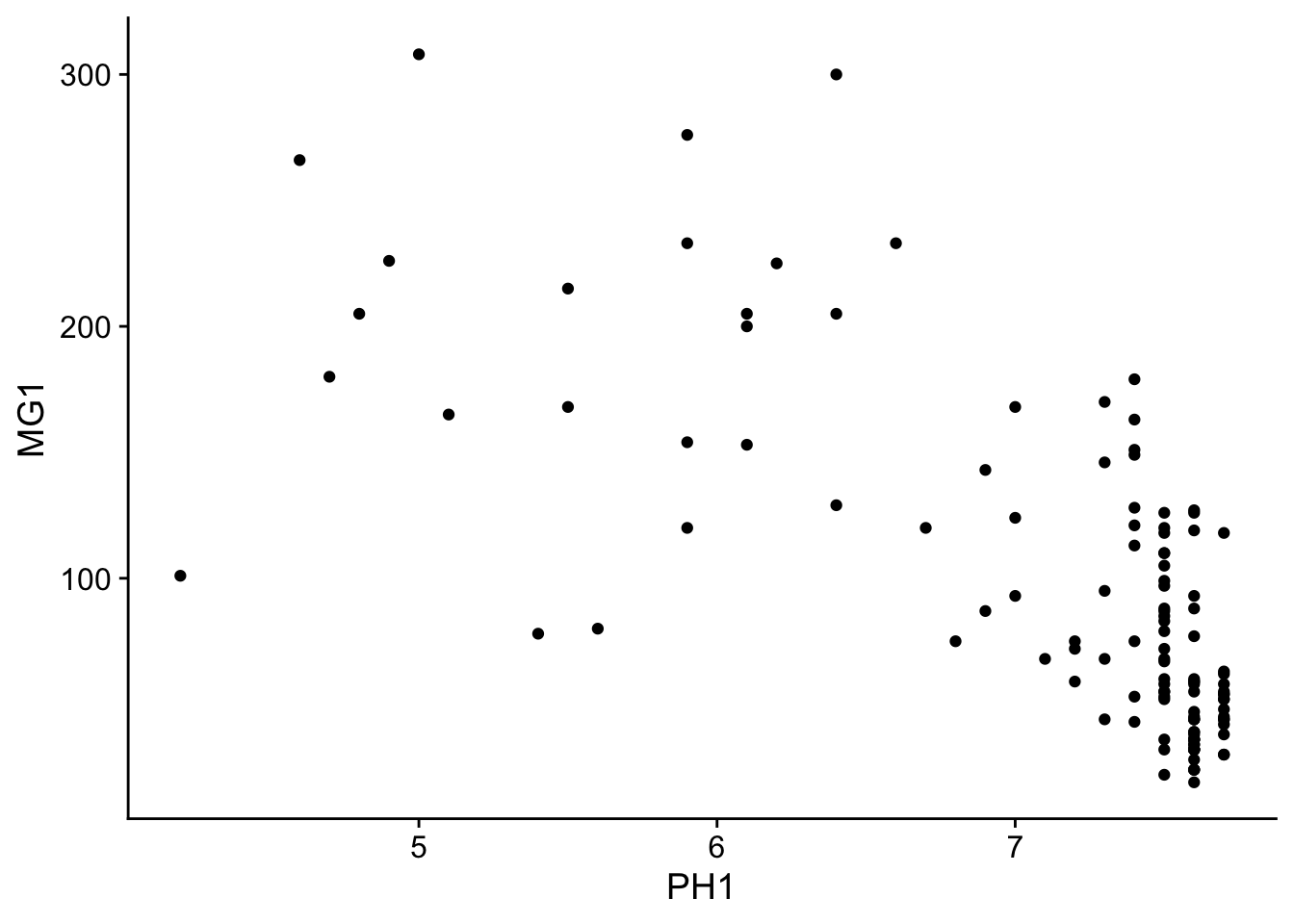

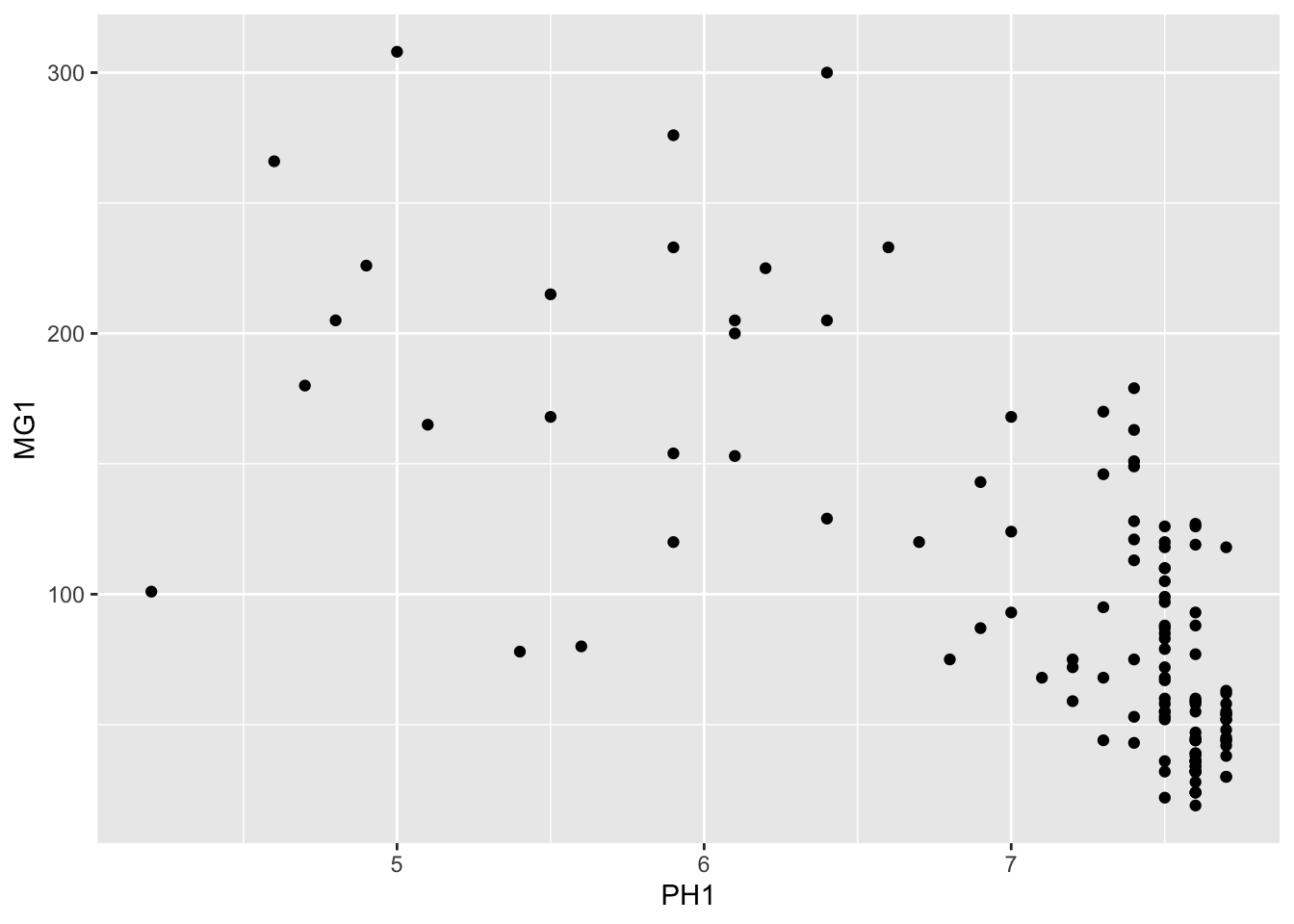

We can immediately see that these measurements were taken on a 100 m grid. It seems that the magnesium concentration is spatially correlated, although it may be a correlation induced by another variable. In particular, we know that the concentration of magnesium is negatively related to the soil pH (PH1).

ggplot(oxford, aes(x = PH1, y = MG1)) +

geom_point()

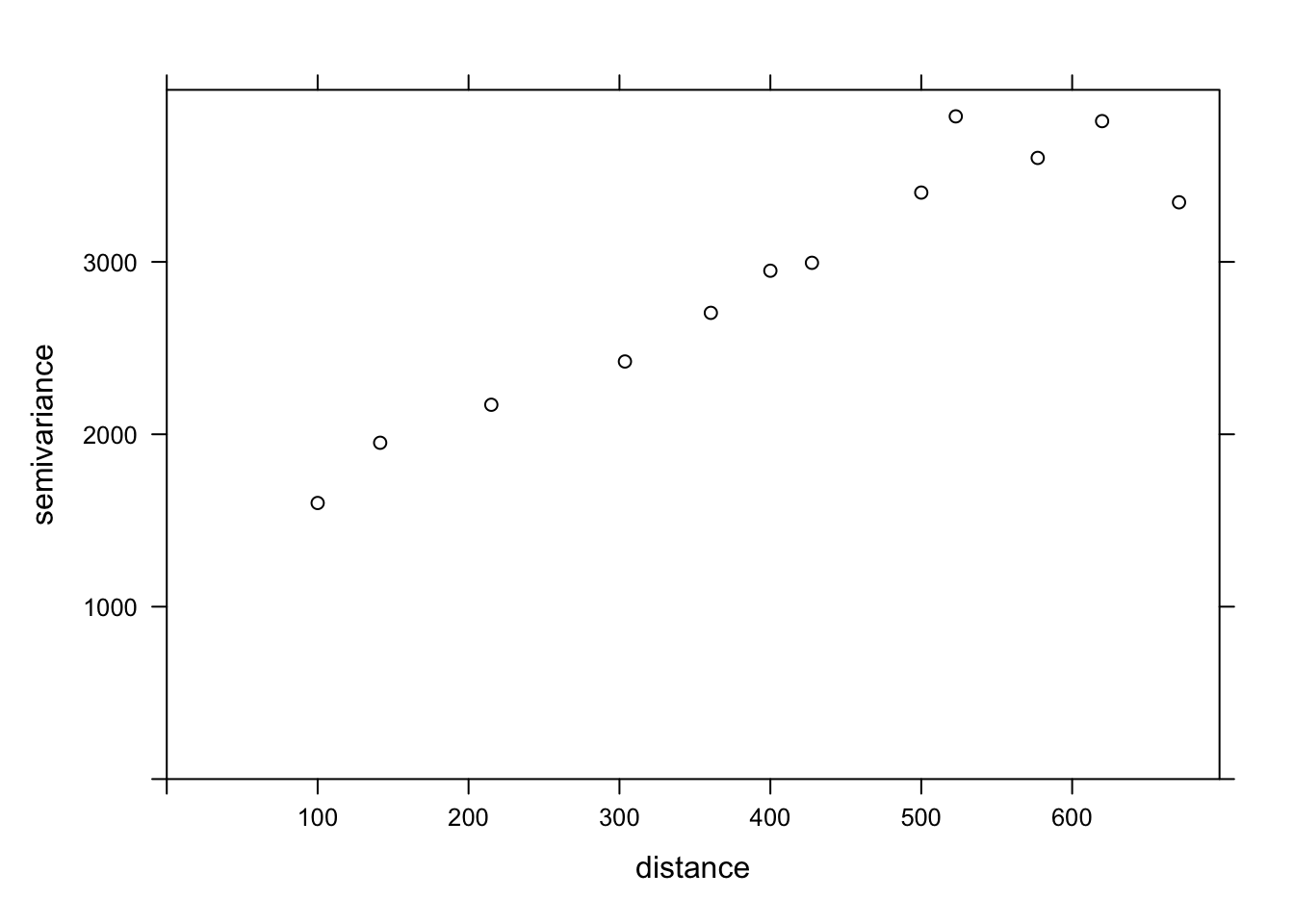

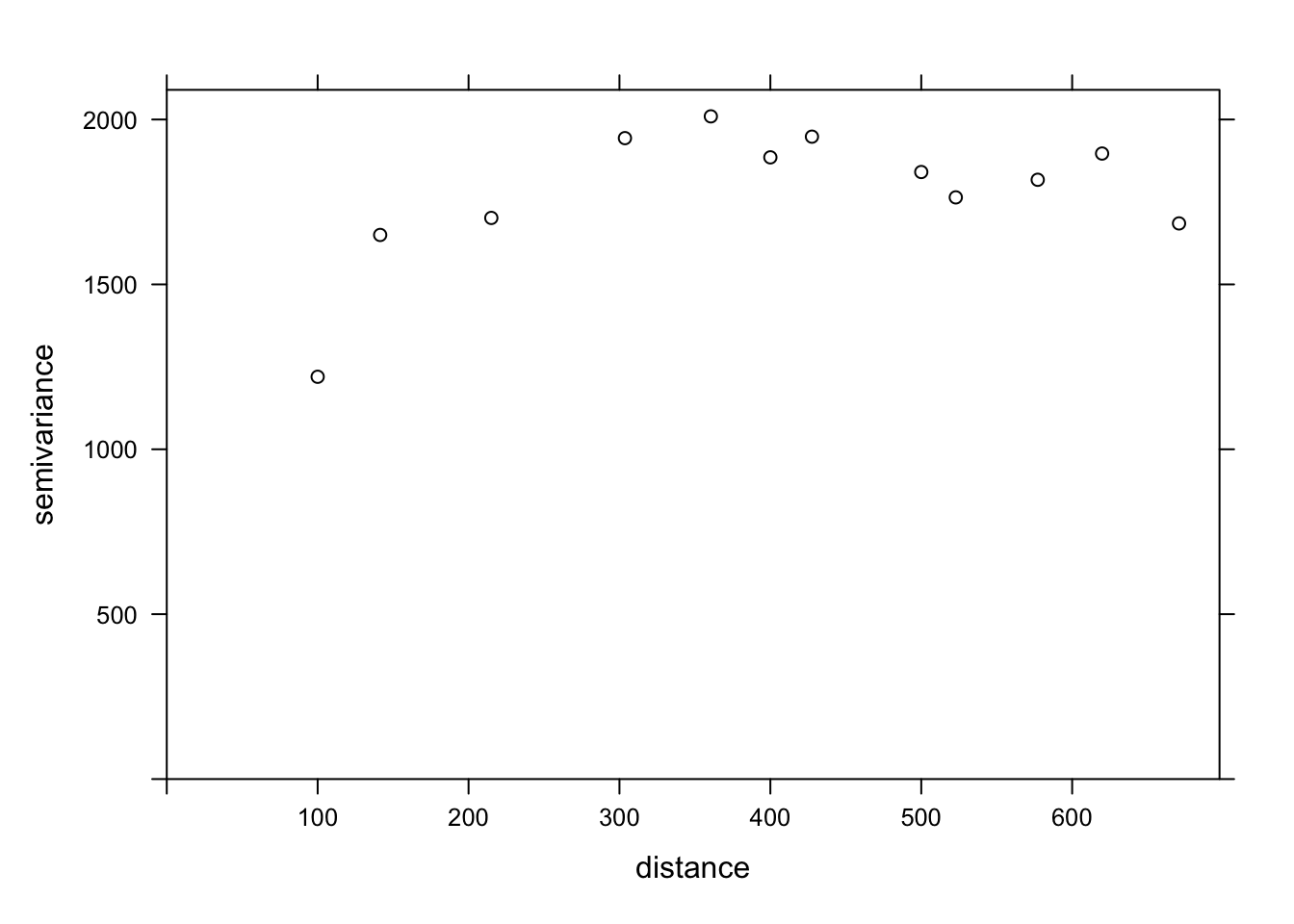

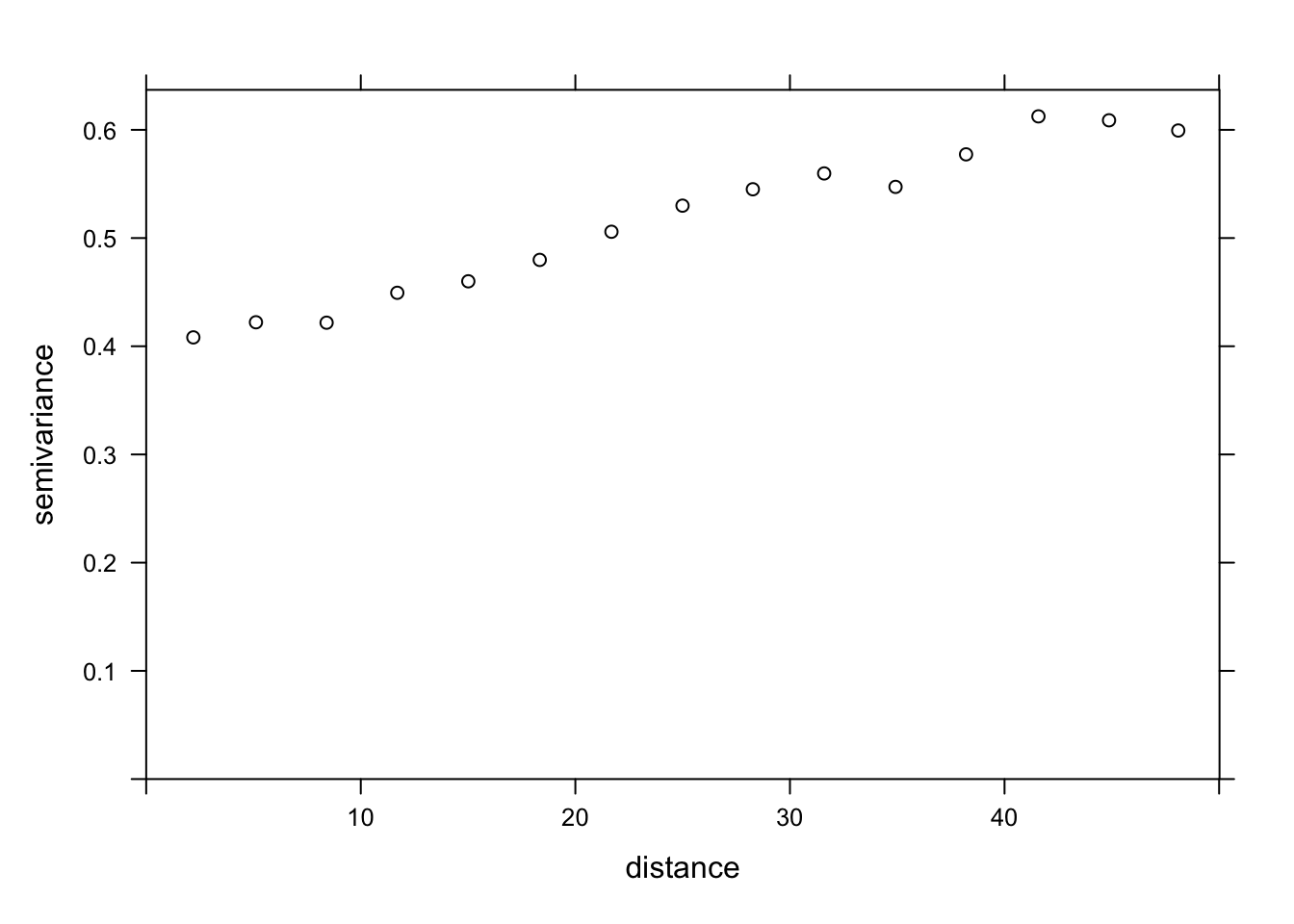

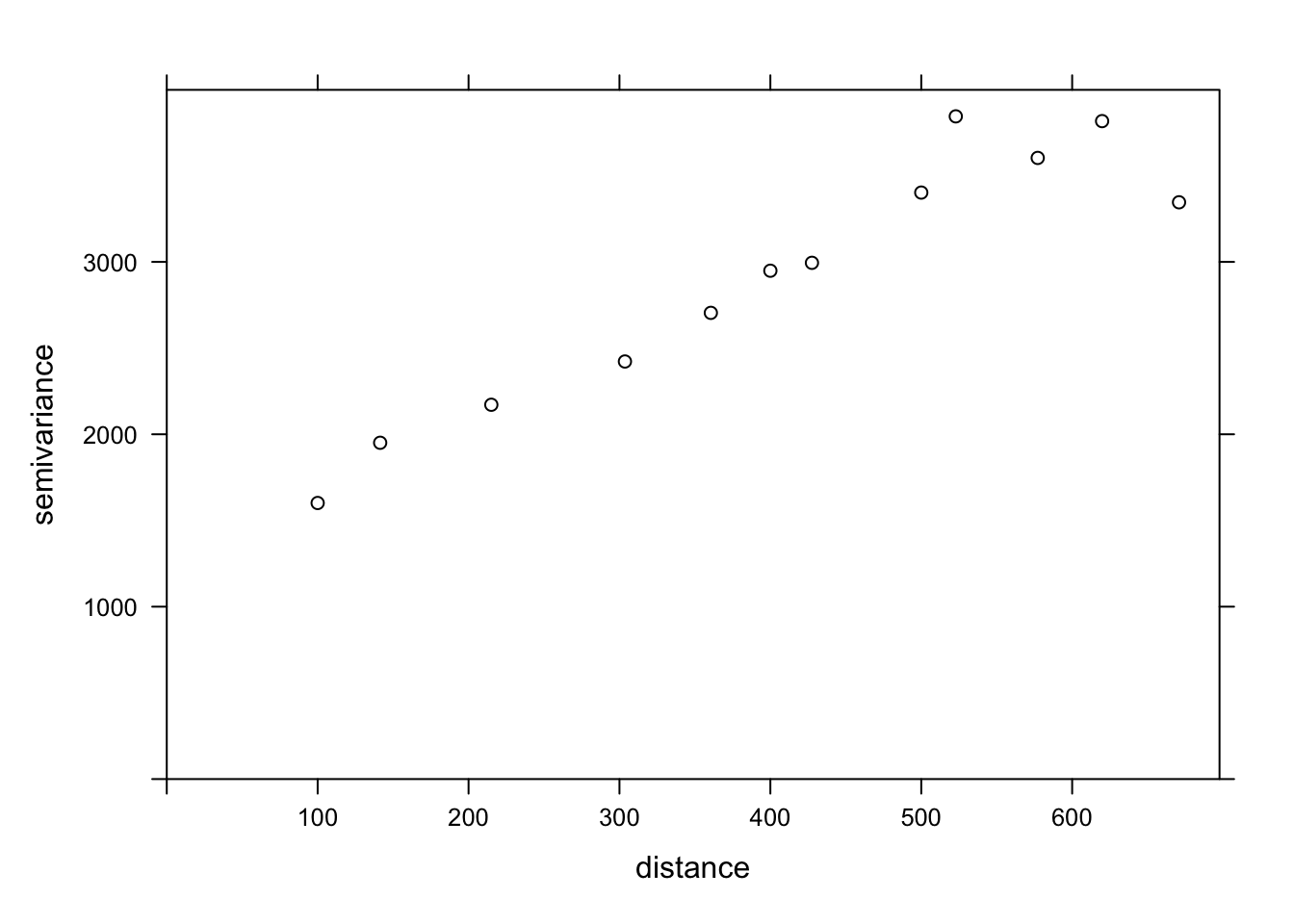

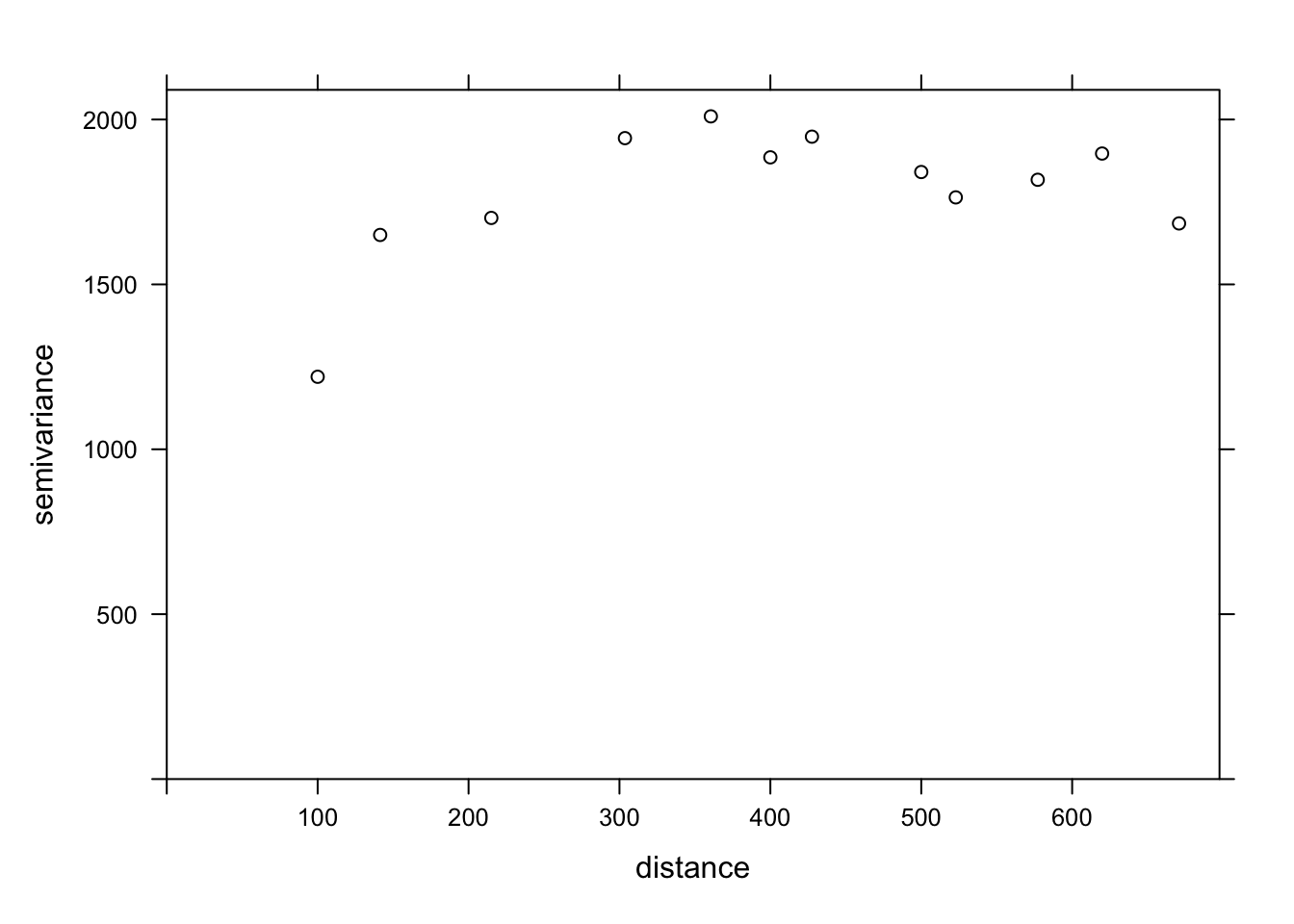

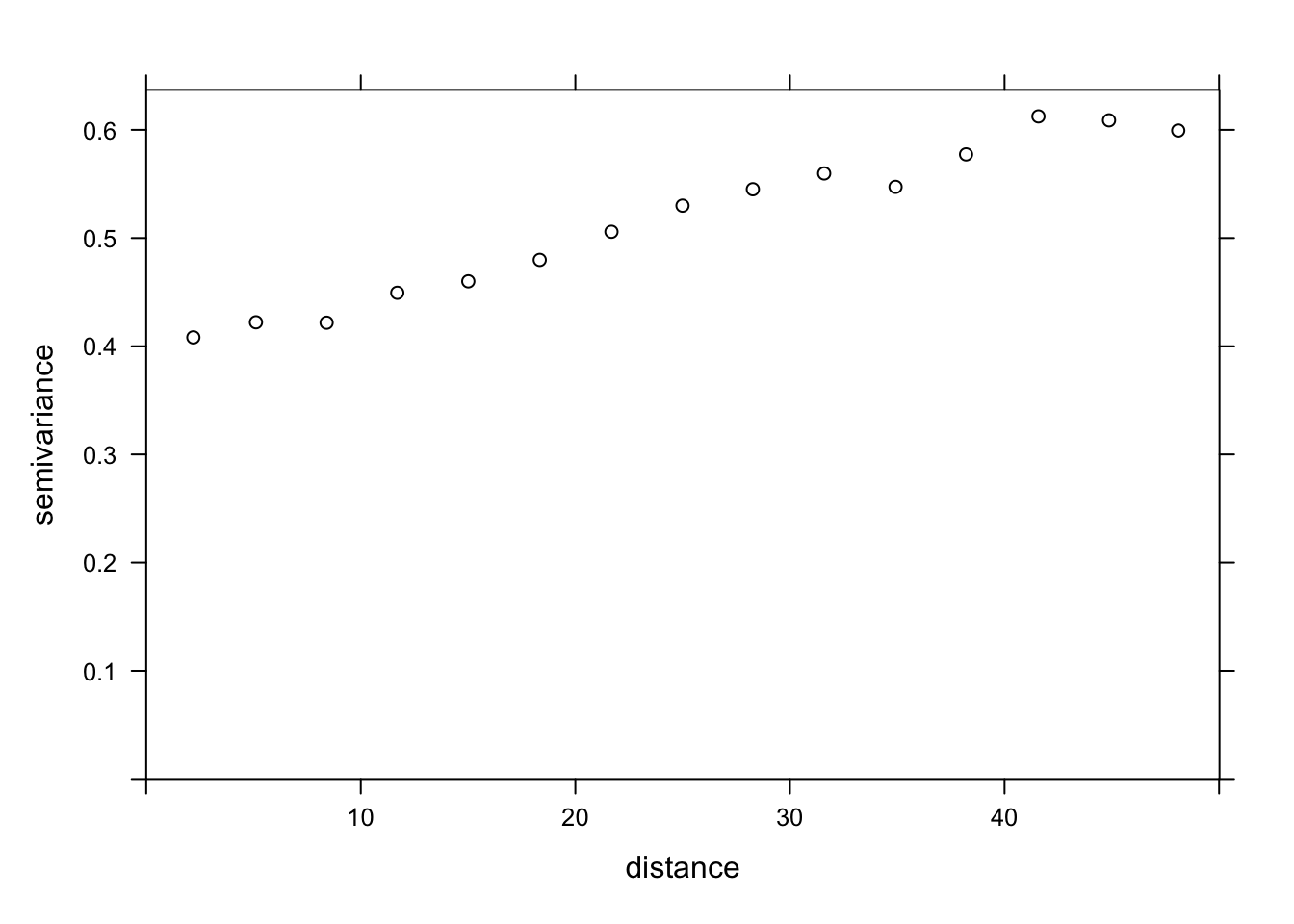

The variogram function of gstat is used to estimate a variogram from empirical data. Here is the result obtained for the variable MG1.

var_mg <- variogram(MG1 ~ 1, locations = ~ XCOORD + YCOORD, data = oxford)

var_mg np dist gamma dir.hor dir.ver id

1 225 100.0000 1601.404 0 0 var1

2 200 141.4214 1950.805 0 0 var1

3 548 215.0773 2171.231 0 0 var1

4 623 303.6283 2422.245 0 0 var1

5 258 360.5551 2704.366 0 0 var1

6 144 400.0000 2948.774 0 0 var1

7 570 427.5569 2994.621 0 0 var1

8 291 500.0000 3402.058 0 0 var1

9 366 522.8801 3844.165 0 0 var1

10 200 577.1759 3603.060 0 0 var1

11 458 619.8400 3816.595 0 0 var1

12 90 670.8204 3345.739 0 0 var1The formula MG1 ~ 1 indicates that no linear predictor is included in this model, while the argument locations indicates which variables in the data frame correspond to the spatial coordinates.

In the resulting table, gamma is the value of the variogram for the distance class centered on dist, while np is the number of pairs of points in that class. Here, since the points are located on a grid, we obtain regular distance classes (e.g.: 100 m for neighboring points on the grid, 141 m for diagonal neighbors, etc.).

Here, we limit ourselves to the estimation of isotropic variograms, i.e. the variogram depends only on the distance between the two points and not on the direction. Although we do not have time to see it today, it is possible with gstat to estimate the variogram separately in different directions.

We can illustrate the variogram with plot.

plot(var_mg, col = "black")

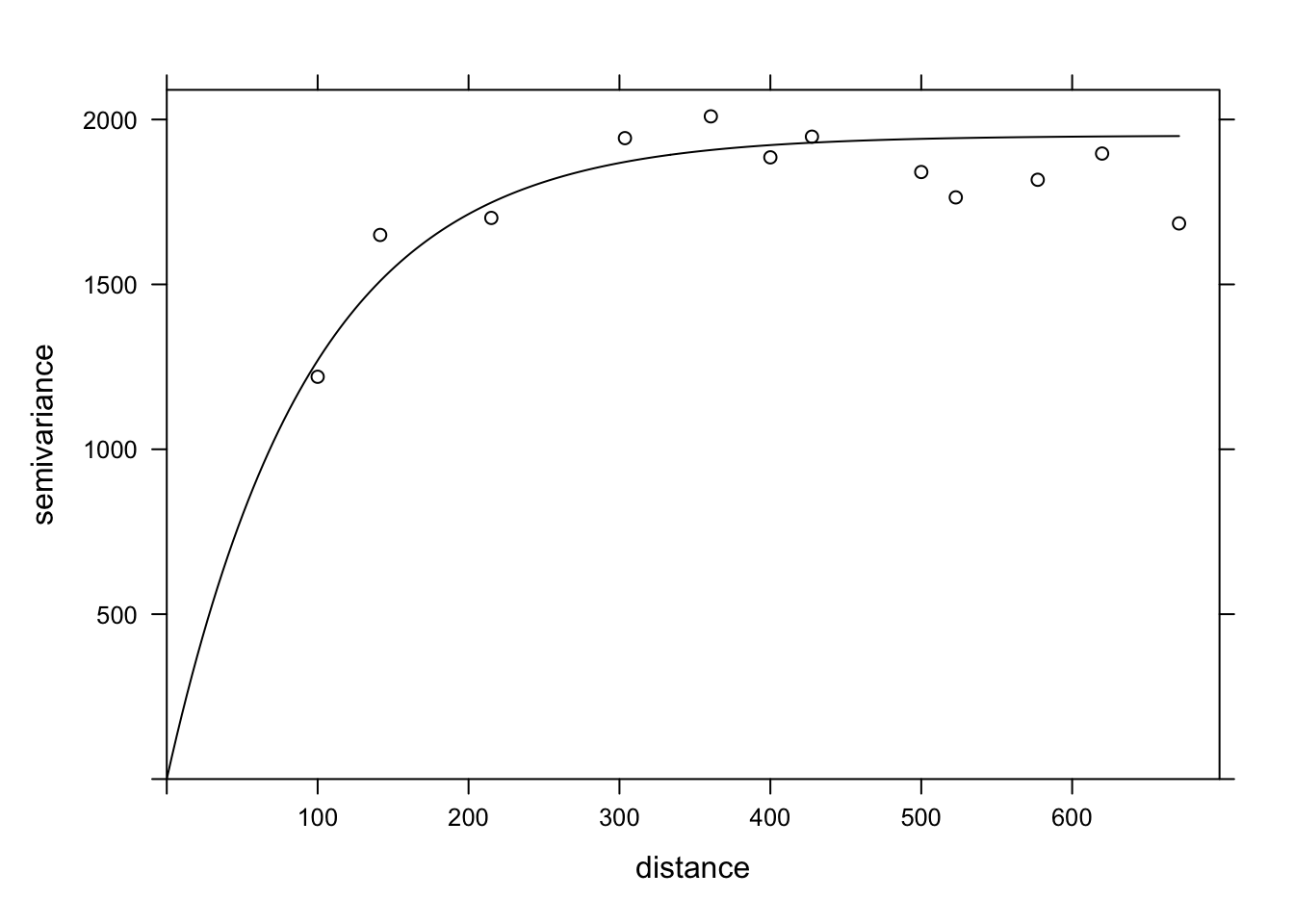

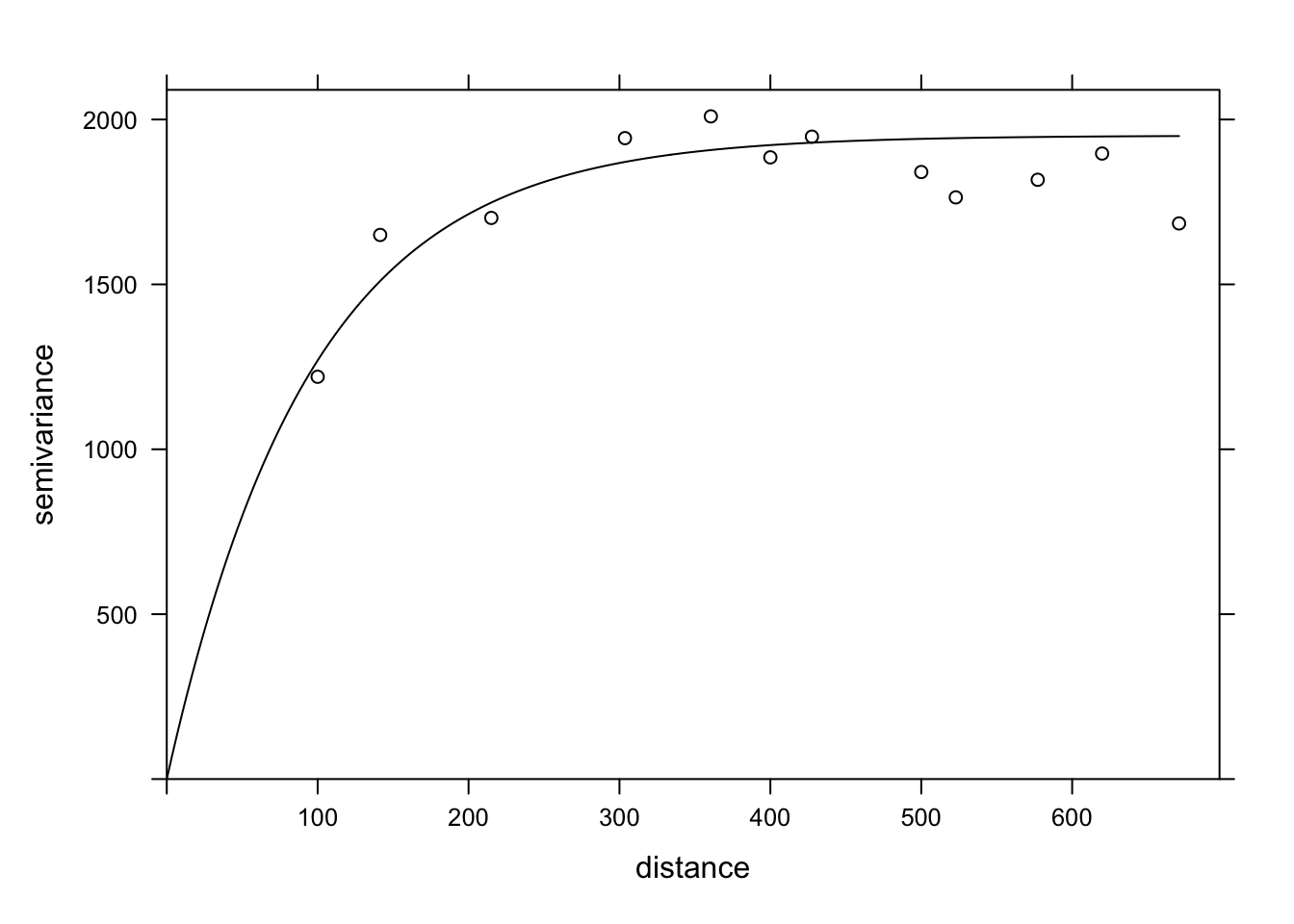

If we want to estimate the residual spatial correlation of MG1 after including the effect of PH1, we can add that predictor to the formula.

var_mg <- variogram(MG1 ~ PH1, locations = ~ XCOORD + YCOORD, data = oxford)

plot(var_mg, col = "black")

Including the effect of pH, the range of the spatial correlation seems to decrease, while the plateau is reached around 300 m. It even seems that the variogram decreases beyond 400 m. In general, we assume that the variance between two points does not decrease with distance, unless there is a periodic spatial pattern.

The function fit.variogram accepts as arguments a variogram estimated from the data, as well as a theoretical model described in a vgm function, and then estimates the parameters of that model according to the data. The fitting is done by the method of least squares.

For example, vgm("Exp") means we want to fit an exponential model.

vfit <- fit.variogram(var_mg, vgm("Exp"))

vfit model psill range

1 Nug 0.000 0.00000

2 Exp 1951.496 95.11235There is no nugget effect, because psill = 0 for the Nug (nugget) part of the model. The exponential part has a sill at 1951 and a range of 95 m.

To compare different models, a vector of model names can be given to vgm. In the following example, we include the exponential, gaussian (“Gau”) and spherical (“Sph”) models.

vfit <- fit.variogram(var_mg, vgm(c("Exp", "Gau", "Sph")))

vfit model psill range

1 Nug 0.000 0.00000

2 Exp 1951.496 95.11235The function gives us the result of the model with the best fit (lowest sum of squared deviations), which here is the same exponential model.

Finally, we can superimpose the theoretical model and the empirical variogram on the same graph.

plot(var_mg, vfit, col = "black")

Regression with spatial correlation

We have seen above that the gstat package allows us to estimate the variogram of the residuals of a linear model. In our example, the magnesium concentration was modeled as a function of pH, with spatially correlated residuals.

Another tool to fit this same type of model is the gls function of the nlme package, which is included with the installation of R.

This function applies the generalized least squares method to fit linear regression models when the residuals are not independent or when the residual variance is not the same for all observations. Since the estimates of the coefficients depend on the estimated correlations between the residuals and the residuals themselves depend on the coefficients, the model is fitted by an iterative algorithm:

A classical linear regression model (without correlation) is fitted to obtain residuals.

The spatial correlation model (variogram) is fitted with those residuals.

The regression coefficients are re-estimated, now taking into account the correlations.

Steps 2 and 3 are repeated until the estimates are stable at a desired precision.

Here is the application of this method to the same model for the magnesium concentration in the oxford dataset. In the correlation argument of gls, we specify an exponential correlation model as a function of our spatial coordinates and we include a possible nugget effect.

In addition to the exponential correlation corExp, the gls function can also estimate a Gaussian (corGaus) or spherical (corSpher) model.

library(nlme)

gls_mg <- gls(MG1 ~ PH1, oxford,

correlation = corExp(form = ~ XCOORD + YCOORD, nugget = TRUE))

summary(gls_mg)Generalized least squares fit by REML

Model: MG1 ~ PH1

Data: oxford

AIC BIC logLik

1278.65 1292.751 -634.325

Correlation Structure: Exponential spatial correlation

Formula: ~XCOORD + YCOORD

Parameter estimate(s):

range nugget

478.0322964 0.2944753

Coefficients:

Value Std.Error t-value p-value

(Intercept) 391.1387 50.42343 7.757084 0

PH1 -41.0836 6.15662 -6.673079 0

Correlation:

(Intr)

PH1 -0.891

Standardized residuals:

Min Q1 Med Q3 Max

-2.1846957 -0.6684520 -0.3687813 0.4627580 3.1918604

Residual standard error: 53.8233

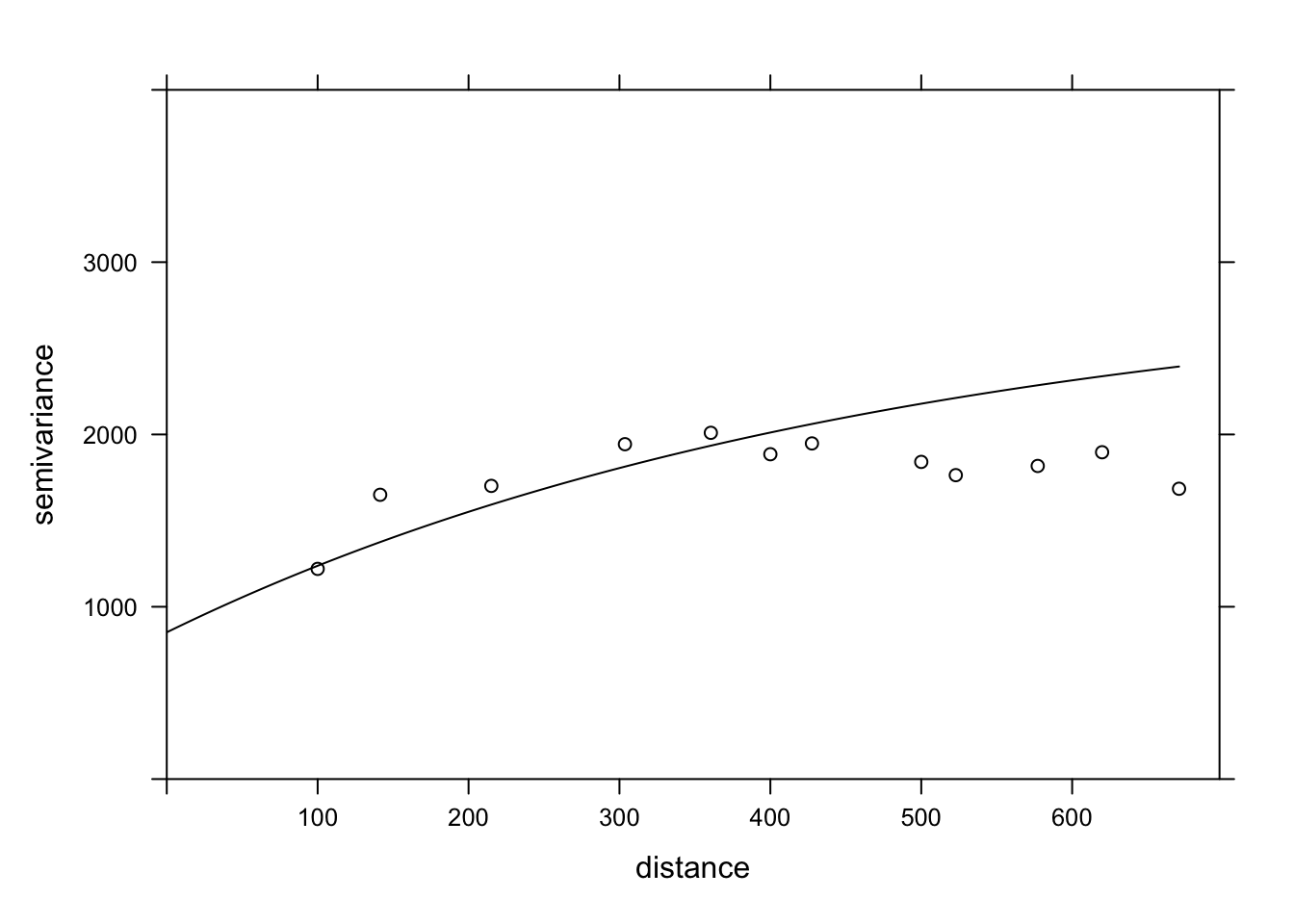

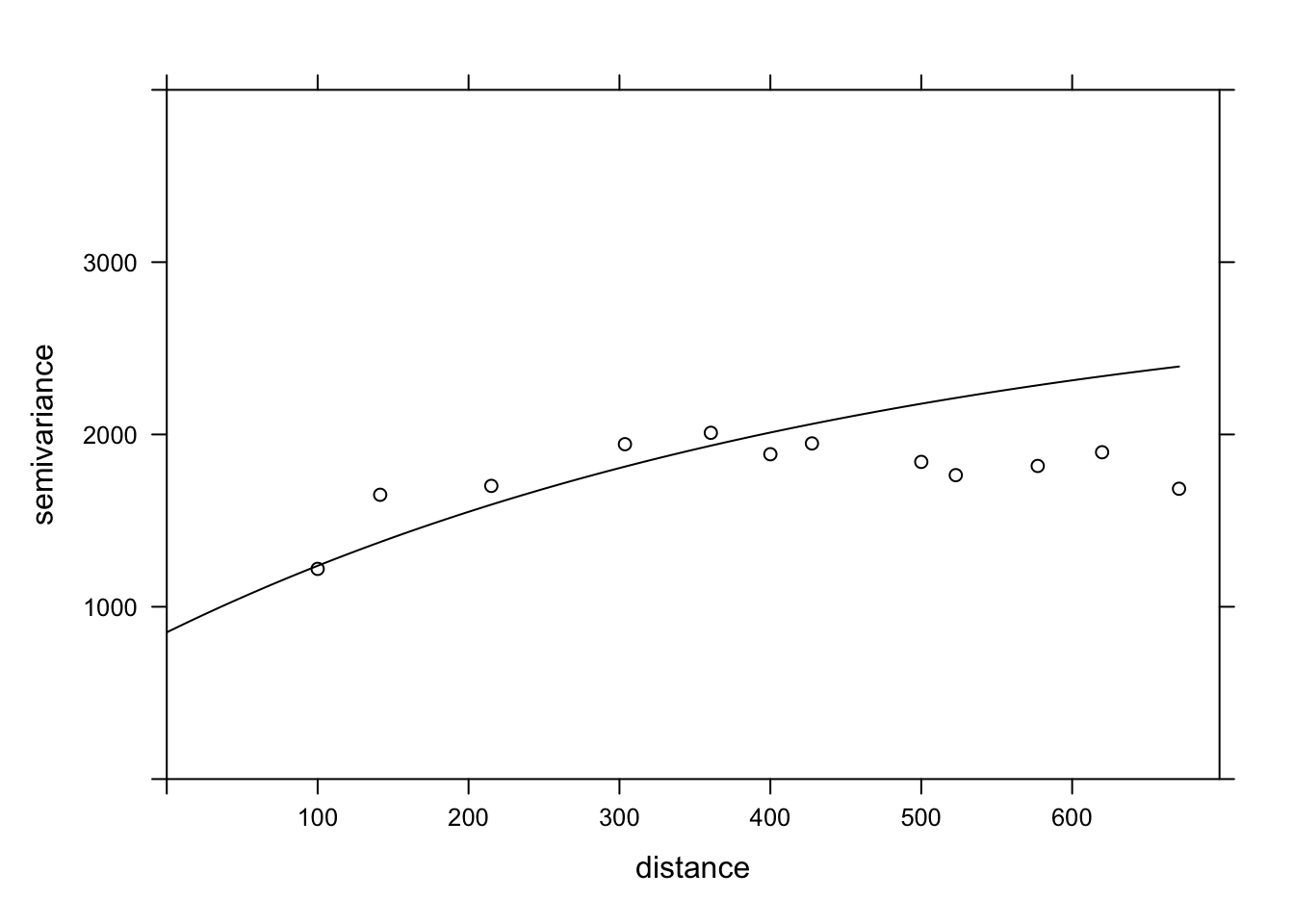

Degrees of freedom: 126 total; 124 residualTo compare this result with the adjusted variogram above, the parameters given by gls must be transformed. The range has the same meaning in both cases and corresponds to 478 m for the result of gls. The global variance of the residuals is the square of Residual standard error. The nugget effect here (0.294) is expressed as a fraction of that variance. Finally, to obtain the partial sill of the exponential part, the nugget effect must be subtracted from the total variance.

After performing these calculations, we can give these parameters to the vgm function of gstat to superimpose this variogram estimated by gls on our variogram of the residuals of the classical linear model.

gls_range <- 478

gls_var <- 53.823^2

gls_nugget <- 0.294 * gls_var

gls_psill <- gls_var - gls_nugget

gls_vgm <- vgm("Exp", psill = gls_psill, range = gls_range, nugget = gls_nugget)

plot(var_mg, gls_vgm, col = "black", ylim = c(0, 4000))

Does the model fit the data less well here? In fact, this empirical variogram represented by the points was obtained from the residuals of the linear model ignoring the spatial correlation, so it is a biased estimate of the actual spatial correlations. The method is still adequate to quickly check if spatial correlations are present. However, to simultaneously fit the regression coefficients and the spatial correlation parameters, the generalized least squares (GLS) approach is preferable and will produce more accurate estimates.

Finally, note that the result of the gls model also gives the AIC, which we can use to compare the fit of different models (with different predictors or different forms of spatial correlation).

Exercise

The bryo_belg.csv dataset is adapted from the data of this study:

Neyens, T., Diggle, P.J., Faes, C., Beenaerts, N., Artois, T. et Giorgi, E. (2019) Mapping species richness using opportunistic samples: a case study on ground-floor bryophyte species richness in the Belgian province of Limburg. Scientific Reports 9, 19122. https://doi.org/10.1038/s41598-019-55593-x

This data frame shows the specific richness of ground bryophytes (richness) for different sampling points in the Belgian province of Limburg, with their position (x, y) in km, in addition to information on the proportion of forest (forest) and wetlands (wetland) in a 1 km^2$ cell containing the sampling point.

bryo_belg <- read.csv("data/bryo_belg.csv")

head(bryo_belg) richness forest wetland x y

1 9 0.2556721 0.5036614 228.9516 220.8869

2 6 0.6449114 0.1172068 227.6714 219.8613

3 5 0.5039905 0.6327003 228.8252 220.1073

4 3 0.5987329 0.2432942 229.2775 218.9035

5 2 0.7600775 0.1163538 209.2435 215.2414

6 10 0.6865434 0.0000000 210.4142 216.5579For this exercise, we will use the square root of the specific richness as the response variable. The square root transformation often allows to homogenize the variance of the count data in order to apply a linear regression.

Fit a linear model of the transformed species richness to the proportion of forest and wetlands, without taking into account spatial correlations. What is the effect of the two predictors in this model?

Calculate the empirical variogram of the model residuals in (a). Does there appear to be a spatial correlation between the points?

Note: The cutoff argument to the variogram function specifies the maximum distance at which the variogram is calculated. You can manually adjust this value to get a good view of the sill.

Re-fit the linear model in (a) with the

glsfunction in the nlme package, trying different types of spatial correlations (exponential, Gaussian, spherical). Compare the models (including the one without spatial correlation) with the AIC.What is the effect of the proportion of forests and wetlands according to the model in (c)? Explain the differences between the conclusions of this model and the model in (a).

8 Kriging

As mentioned before, a common application of geostatistical models is to predict the value of the response variable at unsampled locations, a form of spatial interpolation called kriging (pronounced with a hard “g”).

There are three basic types of kriging based on the assumptions made about the response variable:

Ordinary kriging: Stationary variable with an unknown mean.

Simple kriging: Stationary variable with a known mean.

Universal kriging: Variable with a trend given by a linear or non-linear model.

For all kriging methods, the predictions at a new point are a weighted mean of the values at known points. These weights are chosen so that kriging provides the best linear unbiased prediction of the response variable, if the model assumptions (in particular the variogram) are correct. That is, among all possible unbiased predictions, the weights are chosen to give the minimum mean square error. Kriging also provides an estimate of the uncertainty of each prediction.

While we will not present the detailed kriging equations here, the weights depend on both the correlations (estimated by the variogram) between the sampled points and the new point, as well of the correlations between the sampled points themselves. In other words, sampled points near the new point are given more weight, but isolated sampled points are also given more weight, because sample points close to each other provide redundant information.

Kriging is an interpolation method, so the prediction at a sampled point will always be equal to the measured value (the measurement is supposed to have no error, just spatial variation). However, in the presence of a nugget effect, any small displacement from the sampled location will show variability according to the nugget.

In the example below, we generate a new dataset composed of randomly-generated (x, y) coordinates within the study area as well as randomly-generated pH values based on the oxford data. We then apply the function krige to predict the magnesium values at these new points. Note that we specify the variogram derived from the GLS results in the model argument to krige.

set.seed(14)

new_points <- data.frame(

XCOORD = runif(100, min(oxford$XCOORD), max(oxford$XCOORD)),

YCOORD = runif(100, min(oxford$YCOORD), max(oxford$YCOORD)),

PH1 = rnorm(100, mean(oxford$PH1), sd(oxford$PH1))

)

pred <- krige(MG1 ~ PH1, locations = ~ XCOORD + YCOORD, data = oxford,

newdata = new_points, model = gls_vgm)[using universal kriging]head(pred) XCOORD YCOORD var1.pred var1.var

1 227.0169 162.1185 47.13065 1269.002

2 418.9136 465.9013 79.68437 1427.269

3 578.5943 2032.7477 60.30539 1264.471

4 376.2734 1530.7193 127.22366 1412.875

5 591.5336 421.6290 105.88124 1375.485

6 355.7369 404.3378 127.73055 1250.114The result of krige includes the new point coordinates, the prediction of the variable var1.pred along with its estimated variance var1.var. In the graph below, we show the mean MG1 predictions from kriging (triangles) along with the measurements (circles).

pred$MG1 <- pred$var1.pred

ggplot(oxford, aes(x = YCOORD, y = XCOORD, color = MG1)) +

geom_point() +

geom_point(data = pred, shape = 17, size = 2) +

coord_fixed()

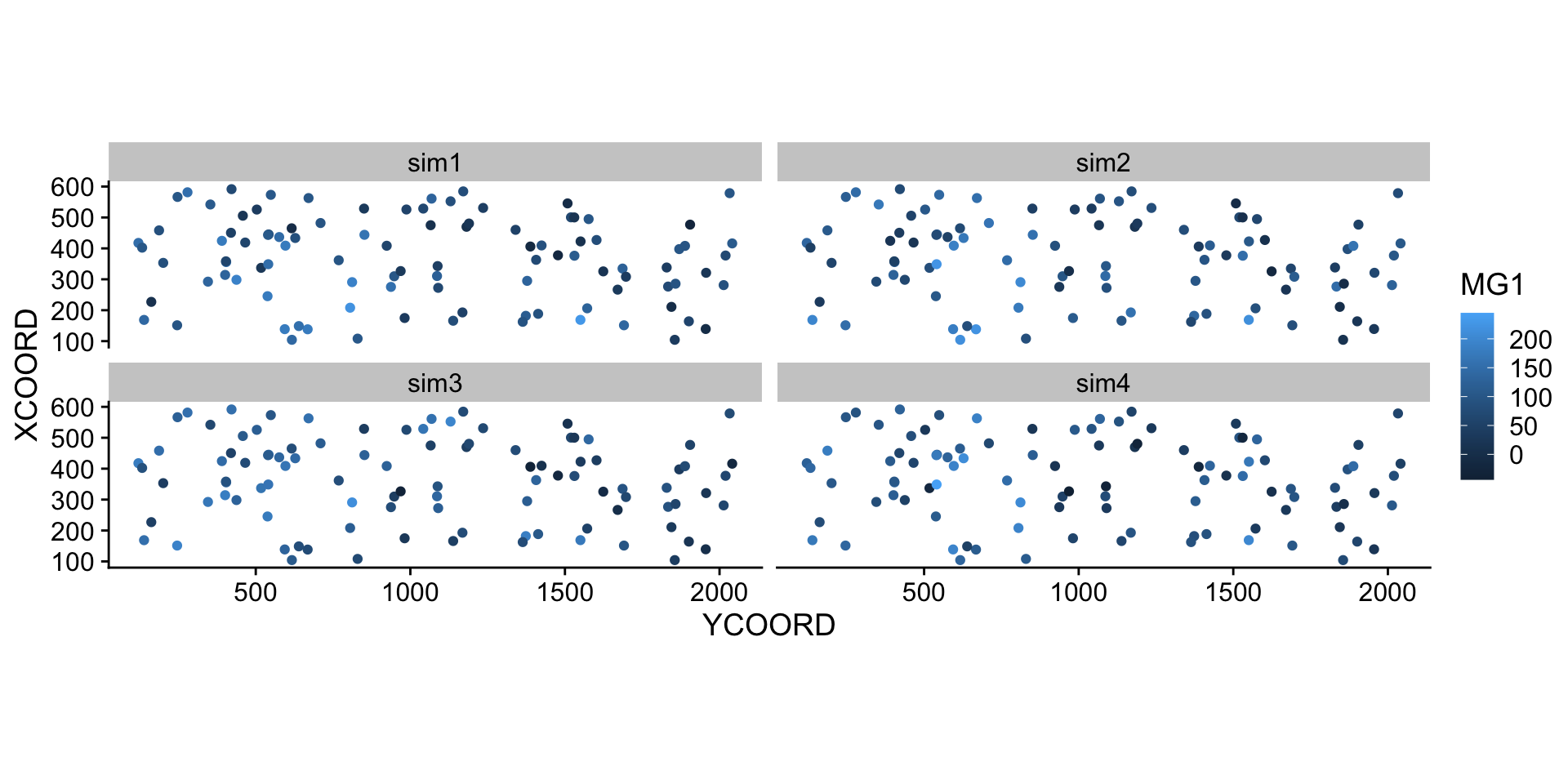

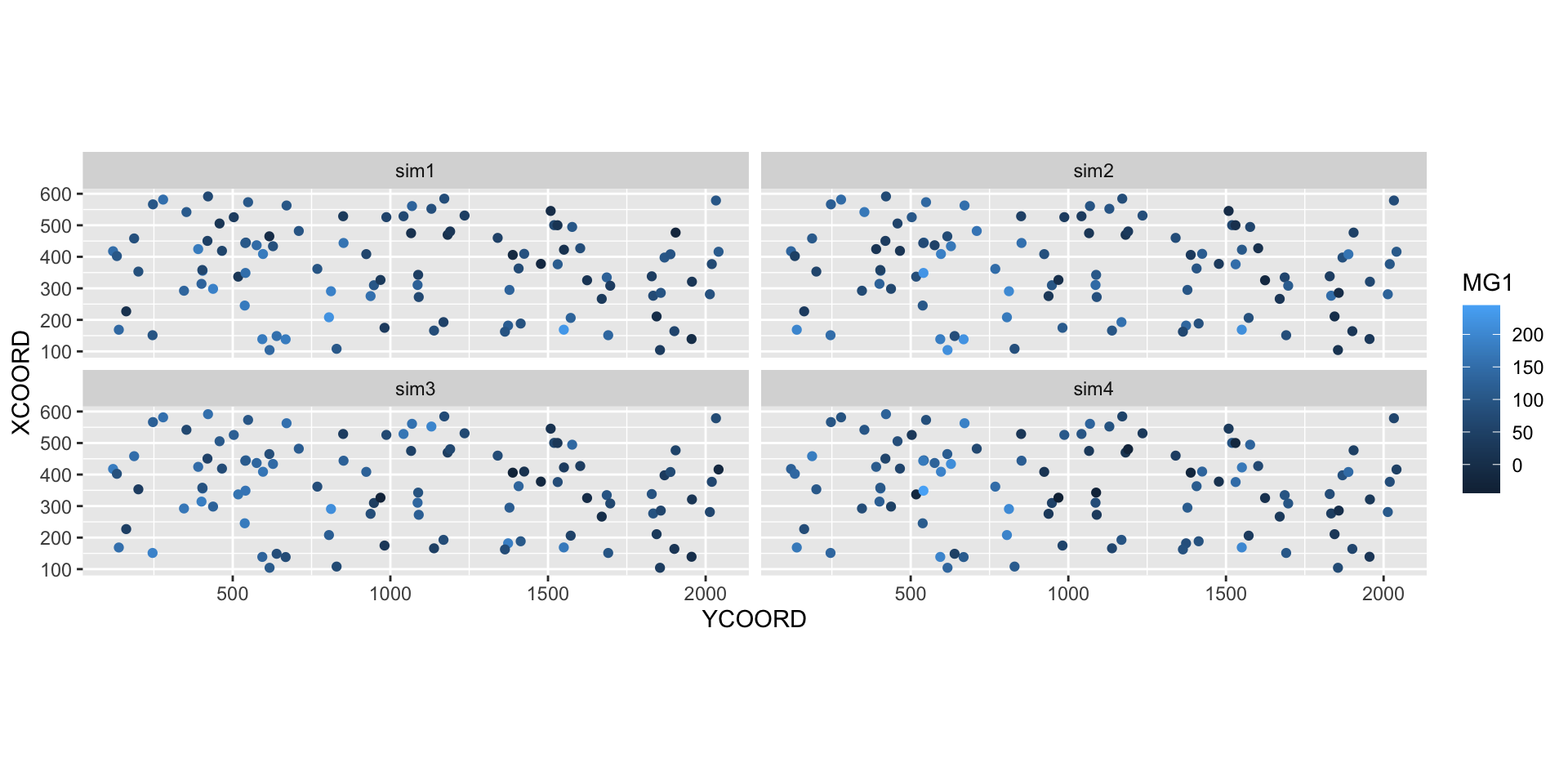

The estimated mean and variance from kriging can be used to simulate possible values of the variable at each new point, conditional on the sampled values. In the example below, we performed 4 conditional simulations by adding the argument nsim = 4 to the same krige instruction.

sim_mg <- krige(MG1 ~ PH1, locations = ~ XCOORD + YCOORD, data = oxford,

newdata = new_points, model = gls_vgm, nsim = 4)drawing 4 GLS realisations of beta...

[using conditional Gaussian simulation]head(sim_mg) XCOORD YCOORD sim1 sim2 sim3 sim4

1 227.0169 162.1185 9.638739 34.53159 46.08685 77.86376

2 418.9136 465.9013 60.029144 20.17179 76.46333 59.57924

3 578.5943 2032.7477 100.791412 77.47887 73.50058 59.40279

4 376.2734 1530.7193 112.615730 150.96664 78.76125 146.83928

5 591.5336 421.6290 70.925240 72.85522 153.90610 126.63758

6 355.7369 404.3378 161.608032 118.93640 134.45695 142.20074library(tidyr)

sim_mg <- pivot_longer(sim_mg, cols = c(sim1, sim2, sim3, sim4),

names_to = "sim", values_to = "MG1")

ggplot(sim_mg, aes(x = YCOORD, y = XCOORD, color = MG1)) +

geom_point() +

coord_fixed() +

facet_wrap(~ sim)

9 Solutions

bryo_lm <- lm(sqrt(richness) ~ forest + wetland, data = bryo_belg)

summary(bryo_lm)

Call:

lm(formula = sqrt(richness) ~ forest + wetland, data = bryo_belg)

Residuals:

Min 1Q Median 3Q Max

-1.8847 -0.4622 0.0545 0.4974 2.3116

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 2.34159 0.08369 27.981 < 2e-16 ***

forest 1.11883 0.13925 8.034 9.74e-15 ***

wetland -0.59264 0.17216 -3.442 0.000635 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

Residual standard error: 0.7095 on 417 degrees of freedom

Multiple R-squared: 0.2231, Adjusted R-squared: 0.2193

F-statistic: 59.86 on 2 and 417 DF, p-value: < 2.2e-16The proportion of forest has a significant positive effect and the proportion of wetlands has a significant negative effect on bryophyte richness.

plot(variogram(sqrt(richness) ~ forest + wetland, locations = ~ x + y,

data = bryo_belg, cutoff = 50), col = "black")

The variogram is increasing from 0 to at least 40 km, so there appears to be spatial correlations in the model residuals.

bryo_exp <- gls(sqrt(richness) ~ forest + wetland, data = bryo_belg,

correlation = corExp(form = ~ x + y, nugget = TRUE))

bryo_gaus <- gls(sqrt(richness) ~ forest + wetland, data = bryo_belg,

correlation = corGaus(form = ~ x + y, nugget = TRUE))

bryo_spher <- gls(sqrt(richness) ~ forest + wetland, data = bryo_belg,

correlation = corSpher(form = ~ x + y, nugget = TRUE))AIC(bryo_lm)[1] 908.6358AIC(bryo_exp)[1] 867.822AIC(bryo_gaus)[1] 870.9592AIC(bryo_spher)[1] 866.9117The spherical model has the smallest AIC.

summary(bryo_spher)Generalized least squares fit by REML

Model: sqrt(richness) ~ forest + wetland

Data: bryo_belg

AIC BIC logLik

866.9117 891.1102 -427.4558

Correlation Structure: Spherical spatial correlation

Formula: ~x + y

Parameter estimate(s):

range nugget

43.1727664 0.6063187

Coefficients:

Value Std.Error t-value p-value

(Intercept) 2.0368769 0.2481636 8.207800 0.000

forest 0.6989844 0.1481690 4.717481 0.000

wetland -0.2441130 0.1809118 -1.349348 0.178

Correlation:

(Intr) forest

forest -0.251

wetland -0.235 0.241

Standardized residuals:

Min Q1 Med Q3 Max

-1.75204183 -0.06568688 0.61415597 1.15240370 3.23322743

Residual standard error: 0.7998264

Degrees of freedom: 420 total; 417 residualBoth effects are less important in magnitude and the effect of wetlands is not significant anymore. As is the case for other types of non-independent residuals, the “effective sample size” here is less than the number of points, since points close to each other provide redundant information. Therefore, the relationship between predictors and response is less clear than given by the model assuming all these points were independent.

Note that the results for all three gls models are quite similar, so the choice to include spatial correlations was more important than the exact shape assumed for the variogram.

10 Areal data

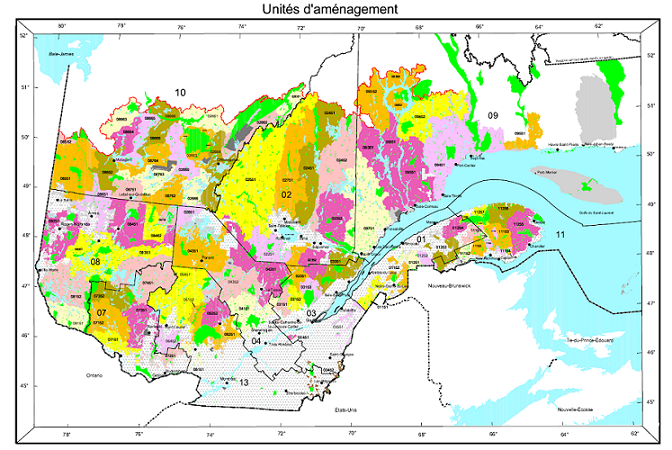

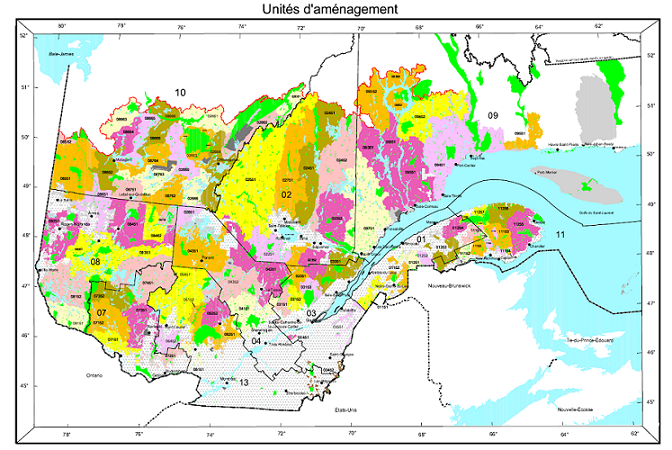

Areal data are variables measured for regions of space, defined by polygons. This type of data is more common in the social sciences, human geography and epidemiology, where data is often available at the scale of administrative divisions.

This type of data also appears frequently in natural resource management. For example, the following map shows the forest management units of the Ministère de la Forêt, de la Faune et des Parcs du Québec.

Suppose that a variable is available at the level of these management units. How can we model the spatial correlation between units that are spatially close together?

One option would be to apply the geostatistical methods seen before, for example by calculating the distance between the centers of the polygons.

Another option, which is more adapted for areal data, is to define a network where each region is connected to neighbouring regions by a link. It is then assumed that the variables are directly correlated between neighbouring regions only. (Note, however, that direct correlations between immediate neighbours also generate indirect correlations for a chain of neighbours).

In this type of model, the correlation is not necessarily the same from one link to another. In this case, each link in the network can be associated with a weight representing its importance for the spatial correlation. We represent these weights by a matrix \(W\) where \(w_{ij}\) is the weight of the link between regions \(i\) and \(j\). A region has no link with itself, so \(w_{ii} = 0\).

A simple choice for \(W\) is to assign a weight equal to 1 if the regions are neighbours, otherwise 0 (binary weight).

In addition to land divisions represented by polygons, another example of areal data consists of a grid where the variable is calculated for each cell of the grid. In this case, a cell generally has 4 or 8 neighbouring cells, depending on whether diagonals are included or not.

11 Moran’s I

Before discussing spatial autocorrelation models, we present Moran’s \(I\) statistic, which allows us to test whether a significant correlation is present between neighbouring regions.

Moran’s \(I\) is a spatial autocorrelation coefficient of \(z\), weighted by the \(w_{ij}\). It therefore takes values between -1 and 1.

\[I = \frac{N}{\sum_i \sum_j w_{ij}} \frac{\sum_i \sum_j w_{ij} (z_i - \bar{z}) (z_j - \bar{z})}{\sum_i (z_i - \bar{z})^2}\]

In this equation, we recognize the expression of a correlation, which is the product of the deviations from the mean for two variables \(z_i\) and \(z_j\), divided by the product of their standard deviations (it is the same variable here, so we get the variance). The contribution of each pair \((i, j)\) is multiplied by its weight \(w_{ij}\) and the term on the left (the number of regions \(N\) divided by the sum of the weights) ensures that the result is bounded between -1 and 1.

Since the distribution of \(I\) is known in the absence of spatial autocorrelation, this statistic serves to test the null hypothesis that there is no spatial correlation between neighbouring regions.

Although we will not see an example in this course, Moran’s \(I\) can also be applied to point data. In this case, we divide the pairs of points into distance classes and calculate \(I\) for each distance class; the weight \(w_{ij} = 1\) if the distance between \(i\) and \(j\) is in the desired distance class, otherwise 0.

12 Spatial autoregression models

Let us recall the formula for a linear regression with spatial dependence:

\[v = \beta_0 + \sum_i \beta_i u_i + z + \epsilon\]

where \(z\) is the portion of the residual variance that is spatially correlated.

There are two main types of autoregressive models to represent the spatial dependence of \(z\): conditional autoregression (CAR) and simultaneous autoregressive (SAR).

Conditional autoregressive (CAR) model

In the conditional autoregressive model, the value of \(z_i\) for the region \(i\) follows a normal distribution: its mean depends on the value \(z_j\) of neighbouring regions, multiplied by the weight \(w_{ij}\) and a correlation coefficient \(\rho\); its standard deviation \(\sigma_{z_i}\) may vary from one region to another.

\[z_i \sim \text{N}\left(\sum_j \rho w_{ij} z_j,\sigma_{z_i} \right)\]

In this model, if \(w_{ij}\) is a binary matrix (0 for non-neighbours, 1 for neighbours), then \(\rho\) is the coefficient of partial correlation between neighbouring regions. This is similar to a first-order autoregressive model in the context of time series, where the autoregression coefficient indicates the partial correlation.

Simultaneous autoregressive (SAR) model

In the simultaneous autoregressive model, the value of \(z_i\) is given directly by the sum of contributions from neighbouring values \(z_j\), multiplied by \(\rho w_{ij}\), with an independent residual \(\nu_i\) of standard deviation \(\sigma_z\).

\[z_i = \sum_j \rho w_{ij} z_j + \nu_i\]

At first glance, this looks like a temporal autoregressive model. However, there is an important conceptual difference. For temporal models, the causal influence is directed in only one direction: \(v(t-2)\) affects \(v(t-1)\) which then affects \(v(t)\). For a spatial model, each \(z_j\) that affects \(z_i\) depends in turn on \(z_i\). Thus, to determine the joint distribution of \(z\), a system of equations must be solved simultaneously (hence the name of the model).

For this reason, although this model resembles the formula of CAR model, the solutions of the two models differ and in the case of SAR, the coefficient \(\rho\) is not directly equal to the partial correlation due to each neighbouring region.

For more details on the mathematical aspects of these models, see the article by Ver Hoef et al. (2018) suggested in reference.

For the moment, we will consider SAR and CAR as two types of possible models to represent a spatial correlation on a network. We can always fit several models and compare them with the AIC to choose the best form of correlation or the best weight matrix.

The CAR and SAR models share an advantage over geostatistical models in terms of efficiency. In a geostatistical model, spatial correlations are defined between each pair of points, although they become negligible as distance increases. For a CAR or SAR model, only neighbouring regions contribute and most weights are equal to 0, making these models faster to fit than a geostatistical model when the data are massive.

13 Analysis of areal data in R

To illustrate the analysis of areal data in R, we load the packages sf (to read geospatial data), spdep (to define spatial networks and calculate Moran’s \(I\)) and spatialreg (for SAR and CAR models).

library(sf)

library(spdep)

library(spatialreg)As an example, we will use a dataset that presents some of the results of the 2018 provincial election in Quebec, with population characteristics of each riding. This data is included in a shapefile (.shp) file type, which we can read with the read_sf function of the sf package.

elect2018 <- read_sf("data/elect2018.shp")

head(elect2018)Simple feature collection with 6 features and 9 fields

Geometry type: MULTIPOLYGON

Dimension: XY

Bounding box: xmin: 97879.03 ymin: 174515.3 xmax: 694261.1 ymax: 599757.1

Projected CRS: LambertAQ

# A tibble: 6 × 10

circ age_moy pct_frn pct_prp rev_med propCAQ propPQ propPLQ propQS

<chr> <dbl> <dbl> <dbl> <int> <dbl> <dbl> <dbl> <dbl>

1 Abitibi-Est 40.8 0.963 0.644 34518 42.7 19.5 18.8 15.7

2 Abitibi-Ouest 42.2 0.987 0.735 33234 34.1 33.3 11.3 16.6

3 Acadie 40.3 0.573 0.403 25391 16.5 9 53.8 13.8

4 Anjou-Louis-Riel 43.5 0.821 0.416 31275 28.9 14.7 39.1 14.5

5 Argenteuil 43.3 0.858 0.766 31097 38.9 21.1 17.4 12.2

6 Arthabaska 43.4 0.989 0.679 30082 61.8 9.4 11.4 12.6

# … with 1 more variable: geometry <MULTIPOLYGON [m]>Note: The dataset is actually composed of 4 files with the extensions .dbf, .prj, .shp and .shx, but it is sufficient to write the name of the .shp file in read_sf.

The columns of the dataset are, in order:

- the name of the electoral riding (

circ); - four characteristics of the population (

age_moy= mean age,pct_frn= fraction of the population that speaks mainly French at home,pct_prp= fraction of households that own their home,rev_med= median income); - four columns showing the fraction of votes obtained by the main parties (CAQ, PQ, PLQ, QS);

- a

geometrycolumn that contains the geometric object (multipolygon) corresponding to the riding.

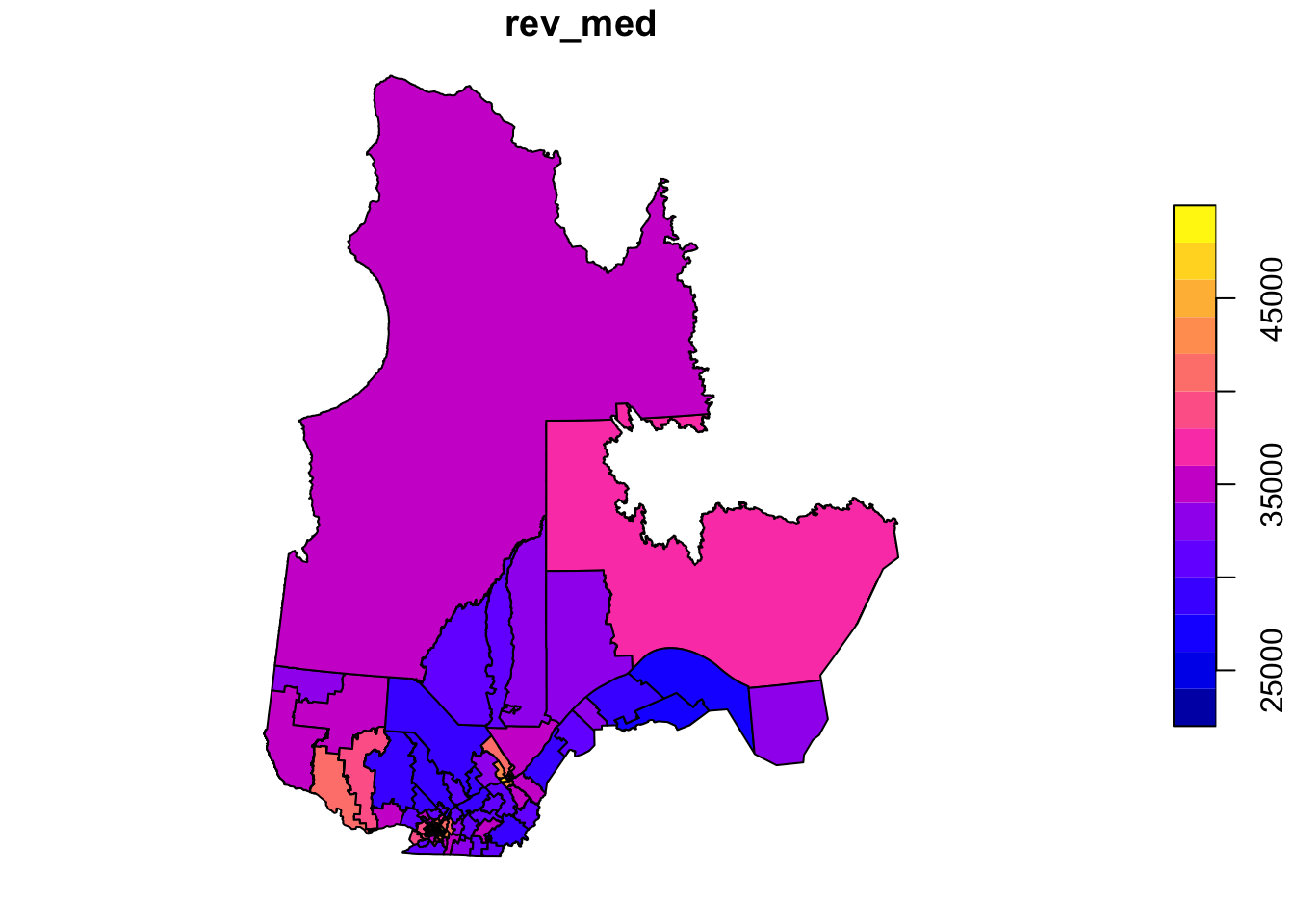

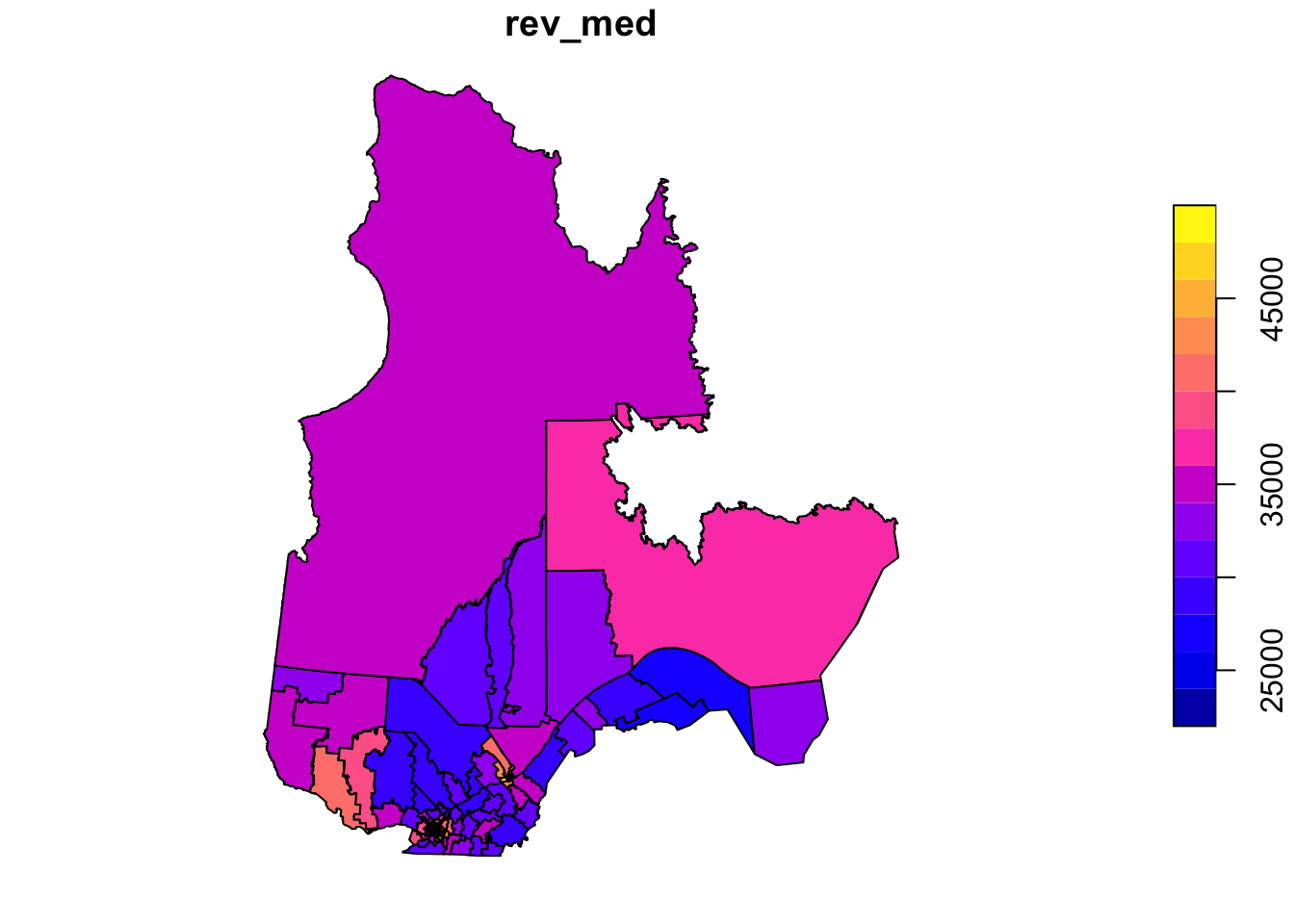

To illustrate one of the variables on a map, we call the plot function with the name of the column in square brackets and quotation marks.

plot(elect2018["rev_med"])

In this example, we want to model the fraction of votes obtained by the CAQ based on the characteristics of the population in each riding and taking into account the spatial correlations between neighbouring ridings.

Definition of the neighbourhood network

The poly2nb function of the spdep package defines a neighbourhood network from polygons. The result vois is a list of 125 elements where each element contains the indices of the neighbouring (bordering) polygons of a given polygon.

vois <- poly2nb(elect2018)

vois[[1]][1] 2 37 63 88 101 117Thus, the first riding (Abitibi-Est) has 6 neighbouring ridings, for which the names can be found as follows:

elect2018$circ[vois[[1]]][1] "Abitibi-Ouest" "Gatineau"

[3] "Laviolette-Saint-Maurice" "Pontiac"

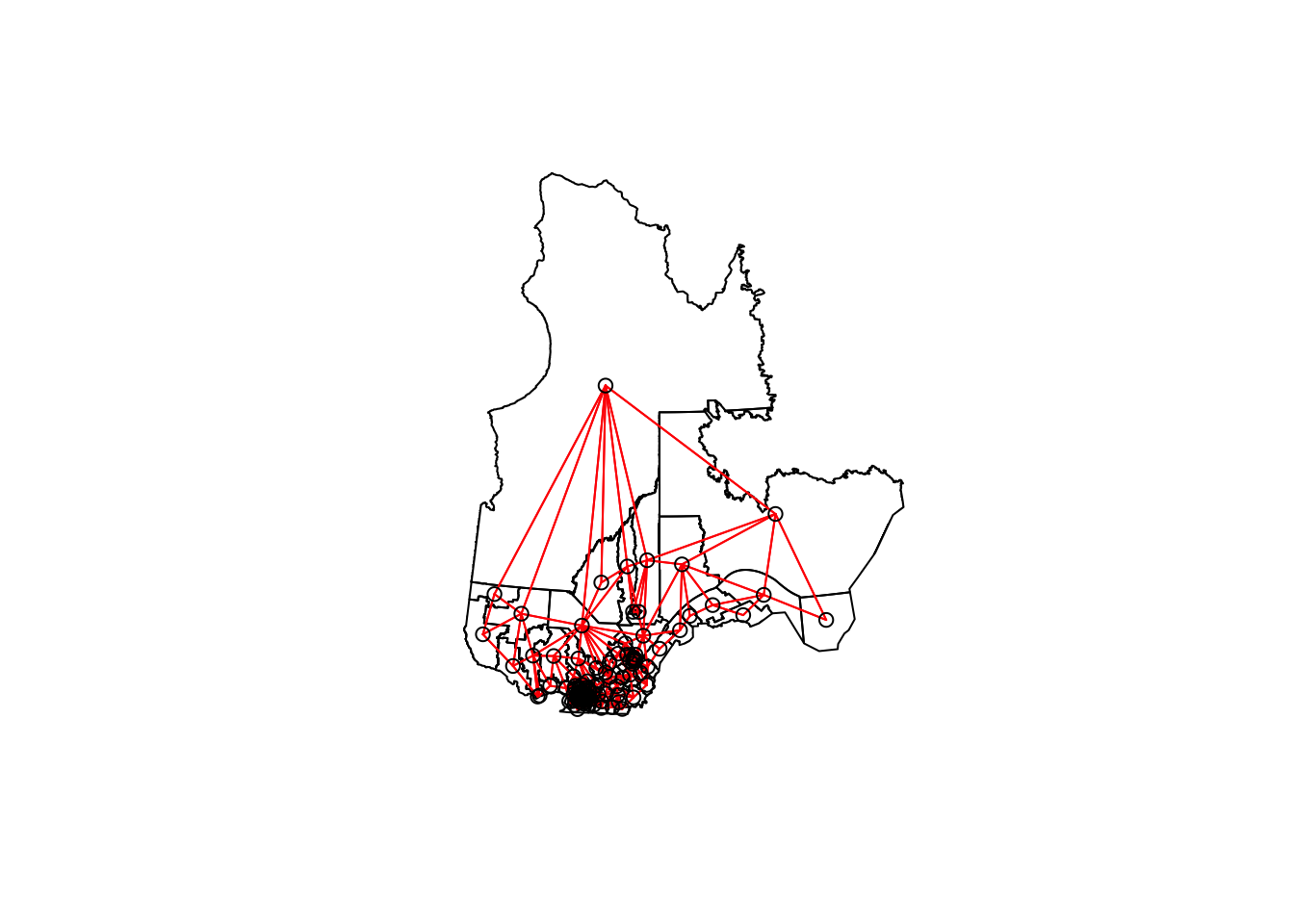

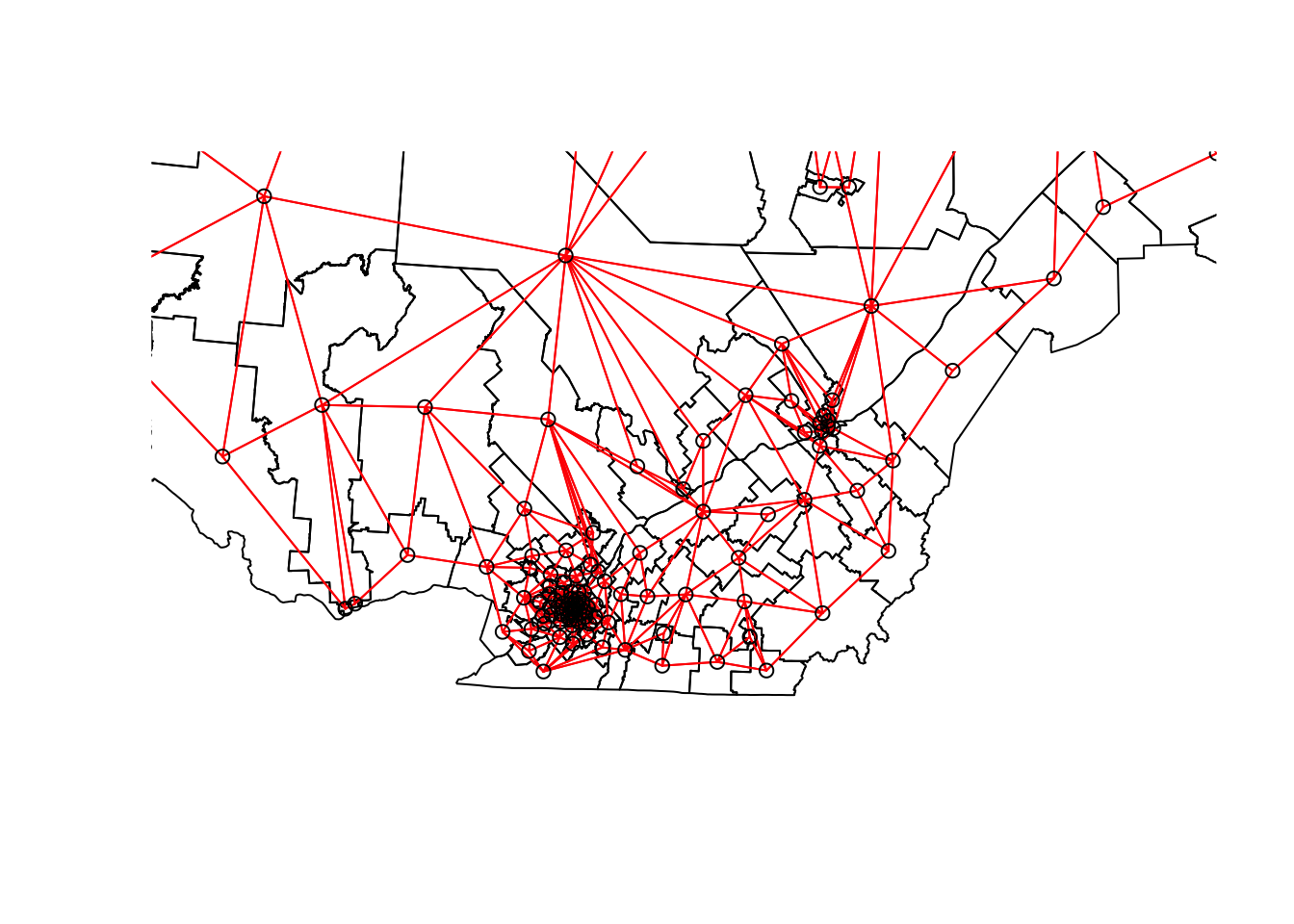

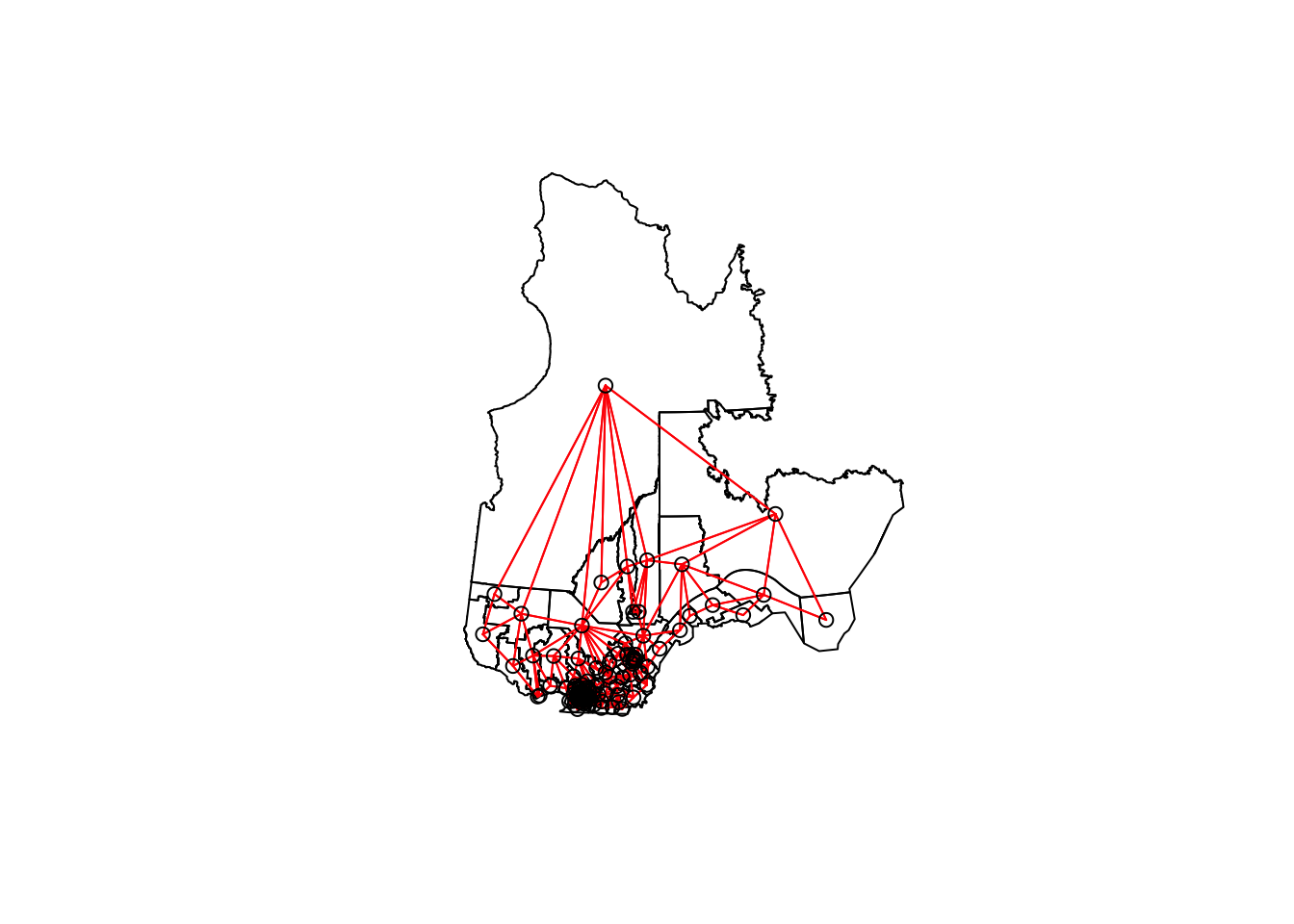

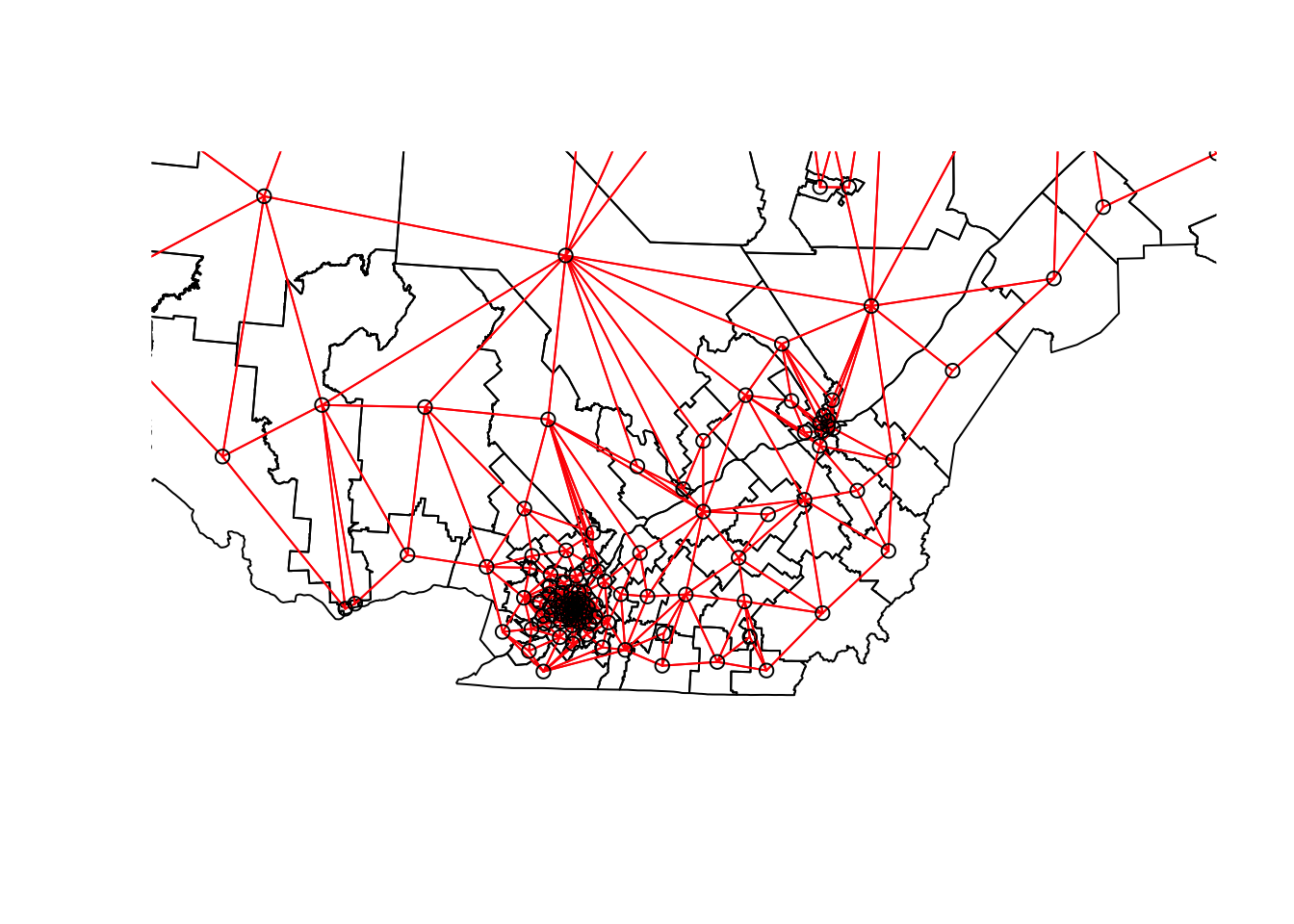

[5] "Rouyn-Noranda-Témiscamingue" "Ungava" We can illustrate this network by extracting the coordinates of the center of each district, creating a blank map with plot(elect2018["geometry"]), then adding the network as an additional layer with plot(vois, add = TRUE, coords = coords).

coords <- st_centroid(elect2018) %>%

st_coordinates()

plot(elect2018["geometry"])

plot(vois, add = TRUE, col = "red", coords = coords)

We can “zoom” on southern Québec by choosing the limits xlim and ylim.

plot(elect2018["geometry"],

xlim = c(400000, 800000), ylim = c(100000, 500000))

plot(vois, add = TRUE, col = "red", coords = coords)

We still have to add weights to each network link with the nb2listw function. The style of weights “B” corresponds to binary weights, i.e. 1 for the presence of link and 0 for the absence of link between two ridings.

Once these weights are defined, we can verify with Moran’s test whether there is a significant autocorrelation of votes obtained by the CAQ between neighbouring ridings.

poids <- nb2listw(vois, style = "B")

moran.test(elect2018$propCAQ, poids)

Moran I test under randomisation

data: elect2018$propCAQ

weights: poids

Moran I statistic standard deviate = 13.148, p-value < 2.2e-16

alternative hypothesis: greater

sample estimates:

Moran I statistic Expectation Variance

0.680607768 -0.008064516 0.002743472 The value \(I = 0.68\) is very significant judging by the \(p\)-value of the test.

Let’s verify if the spatial correlation persists after taking into account the four characteristics of the population, therefore by inspecting the residuals of a linear model including these four predictors.

elect_lm <- lm(propCAQ ~ age_moy + pct_frn + pct_prp + rev_med, data = elect2018)

summary(elect_lm)

Call:

lm(formula = propCAQ ~ age_moy + pct_frn + pct_prp + rev_med,

data = elect2018)

Residuals:

Min 1Q Median 3Q Max

-30.9890 -4.4878 0.0562 6.2653 25.8146

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 1.354e+01 1.836e+01 0.737 0.463

age_moy -9.170e-01 3.855e-01 -2.378 0.019 *

pct_frn 4.588e+01 5.202e+00 8.820 1.09e-14 ***

pct_prp 3.582e+01 6.527e+00 5.488 2.31e-07 ***

rev_med -2.624e-05 2.465e-04 -0.106 0.915

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

Residual standard error: 9.409 on 120 degrees of freedom

Multiple R-squared: 0.6096, Adjusted R-squared: 0.5965

F-statistic: 46.84 on 4 and 120 DF, p-value: < 2.2e-16moran.test(residuals(elect_lm), poids)

Moran I test under randomisation

data: residuals(elect_lm)

weights: poids

Moran I statistic standard deviate = 6.7047, p-value = 1.009e-11

alternative hypothesis: greater

sample estimates:

Moran I statistic Expectation Variance

0.340083290 -0.008064516 0.002696300 Moran’s \(I\) has decreased but remains significant, so some of the previous correlation was induced by these predictors, but there remains a spatial correlation due to other factors.

Spatial autoregression models

Finally, we fit SAR and CAR models to these data with the spautolm (spatial autoregressive linear model) function of spatialreg. Here is the code for a SAR model including the effect of the same four predictors.

elect_sar <- spautolm(propCAQ ~ age_moy + pct_frn + pct_prp + rev_med,

data = elect2018, listw = poids)

summary(elect_sar)

Call: spautolm(formula = propCAQ ~ age_moy + pct_frn + pct_prp + rev_med,

data = elect2018, listw = poids)

Residuals:

Min 1Q Median 3Q Max

-23.08342 -4.10573 0.24274 4.29941 23.08245

Coefficients:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 15.09421119 16.52357745 0.9135 0.36098

age_moy -0.70481703 0.32204139 -2.1886 0.02863

pct_frn 39.09375061 5.43653962 7.1909 6.435e-13

pct_prp 14.32329345 6.96492611 2.0565 0.03974

rev_med 0.00016730 0.00023209 0.7208 0.47101

Lambda: 0.12887 LR test value: 42.274 p-value: 7.9339e-11

Numerical Hessian standard error of lambda: 0.012069

Log likelihood: -433.8862

ML residual variance (sigma squared): 53.028, (sigma: 7.282)

Number of observations: 125

Number of parameters estimated: 7

AIC: 881.77The value given by Lambda in the summary corresponds to the coefficient \(\rho\) in our description of the model. The likelihood-ratio test (LR test) confirms that this residual spatial correlation (after controlling for the effect of predictors) is significant.

The estimated effects for the predictors are similar to those of the linear model without spatial correlation. The effects of mean age, fraction of francophones and fraction of homeowners remain significant, although their magnitude has decreased somewhat.

To fit a CAR rather than SAR model, we must specify family = "CAR".

elect_car <- spautolm(propCAQ ~ age_moy + pct_frn + pct_prp + rev_med,

data = elect2018, listw = poids, family = "CAR")

summary(elect_car)

Call: spautolm(formula = propCAQ ~ age_moy + pct_frn + pct_prp + rev_med,

data = elect2018, listw = poids, family = "CAR")

Residuals:

Min 1Q Median 3Q Max

-21.73315 -4.24623 -0.24369 3.44228 23.43749

Coefficients:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 16.57164696 16.84155327 0.9840 0.325128

age_moy -0.79072151 0.32972225 -2.3981 0.016478

pct_frn 38.99116707 5.43667482 7.1719 7.399e-13

pct_prp 17.98557474 6.80333470 2.6436 0.008202

rev_med 0.00012639 0.00023106 0.5470 0.584364

Lambda: 0.15517 LR test value: 40.532 p-value: 1.9344e-10

Numerical Hessian standard error of lambda: 0.0026868

Log likelihood: -434.7573

ML residual variance (sigma squared): 53.9, (sigma: 7.3416)

Number of observations: 125

Number of parameters estimated: 7

AIC: 883.51For a CAR model with binary weights, the value of Lambda (which we called \(\rho\)) directly gives the partial correlation coefficient between neighbouring districts. Note that the AIC here is slightly higher than the SAR model, so the latter gave a better fit.

Exercise

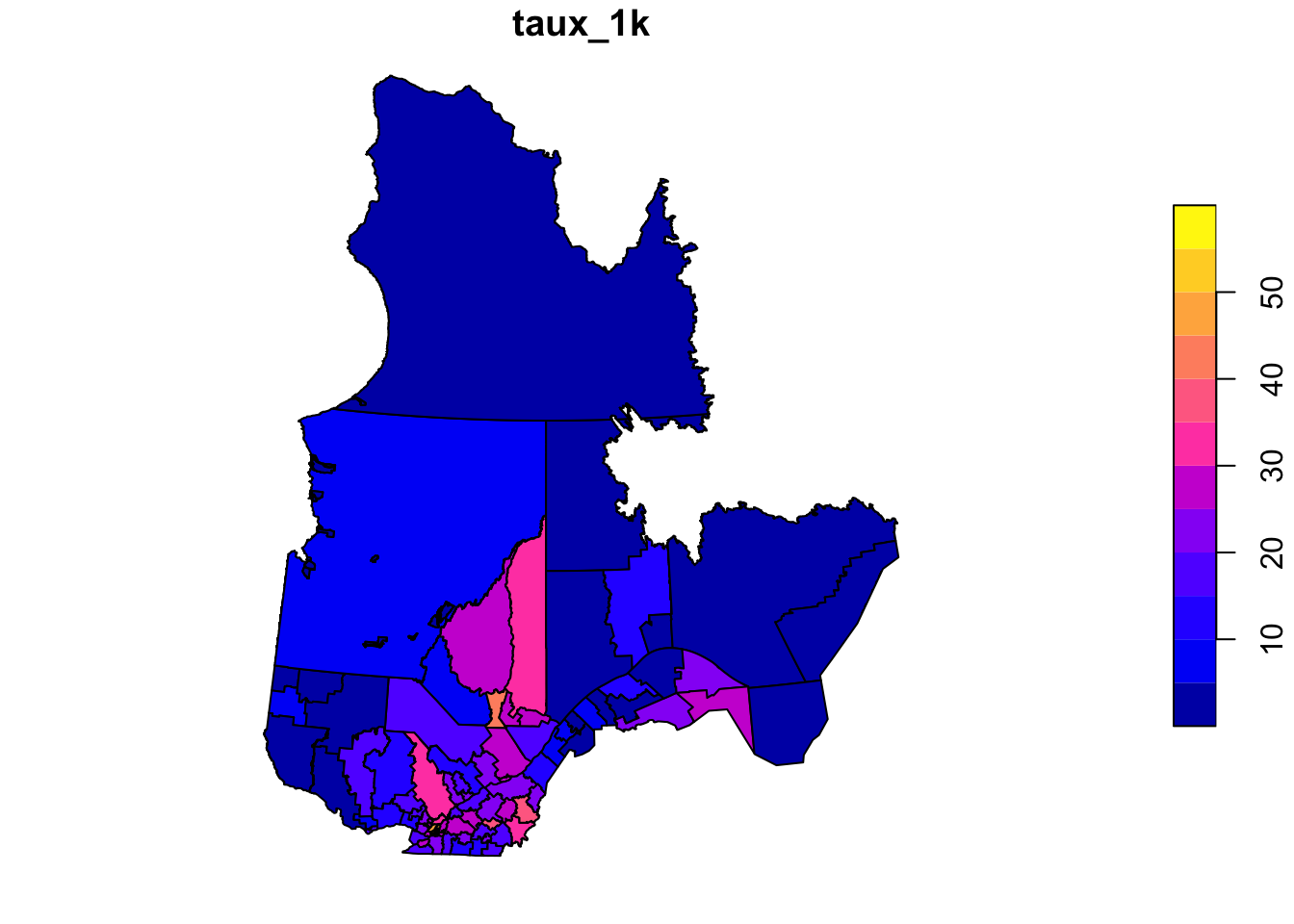

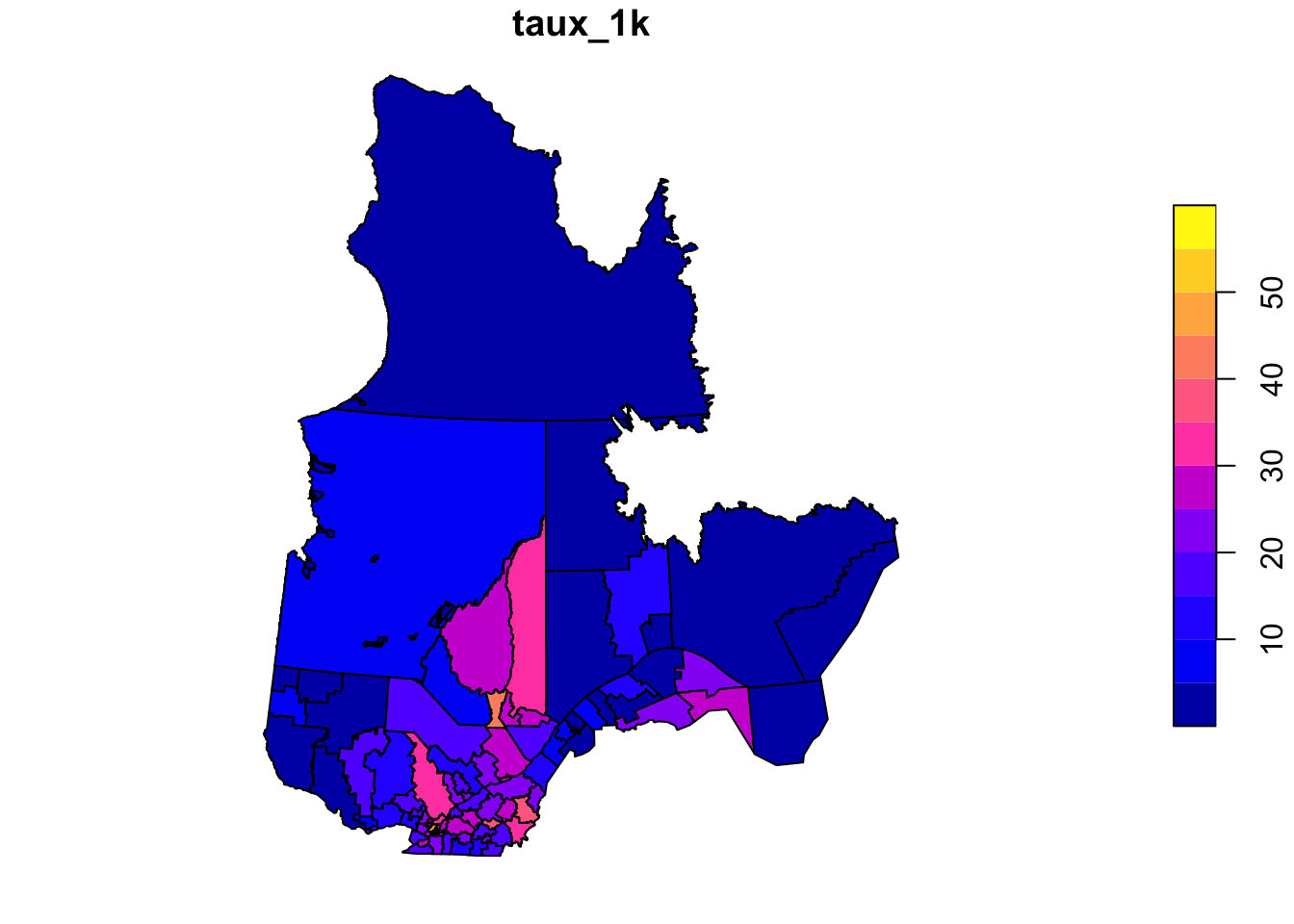

The rls_covid dataset, in shapefile format, contains data on detected COVID-19 cases (cas), number of cases per 1000 people (taux_1k) and the population density (dens_pop) in each of Quebec’s local health service networks (RLS) (Source: Data downloaded from the Institut national de santé publique du Québec as of January 17, 2021).

rls_covid <- read_sf("data/rls_covid.shp")

head(rls_covid)Simple feature collection with 6 features and 5 fields

Geometry type: MULTIPOLYGON

Dimension: XY

Bounding box: xmin: 785111.2 ymin: 341057.8 xmax: 979941.5 ymax: 541112.7

Projected CRS: Conique_conforme_de_Lambert_du_MTQ_utilis_e_pour_Adresse_Qu_be

# A tibble: 6 × 6

RLS_code RLS_nom cas taux_1k dens_…¹ geometry

<chr> <chr> <dbl> <dbl> <dbl> <MULTIPOLYGON [m]>

1 0111 RLS de Kamouraska 152 7.34 6.76 (((827028.3 412772.4, 82…

2 0112 RLS de Rivière-du-Lo… 256 7.34 19.6 (((855905 452116.9, 8557…

3 0113 RLS de Témiscouata 81 4.26 4.69 (((911829.4 441311.2, 91…

4 0114 RLS des Basques 28 3.3 5.35 (((879249.6 471975.6, 87…

5 0115 RLS de Rimouski 576 9.96 15.5 (((917748.1 503148.7, 91…

6 0116 RLS de La Mitis 76 4.24 5.53 (((951316 523499.3, 9525…

# … with abbreviated variable name ¹dens_popFit a linear model of the number of cases per 1000 as a function of population density (it is suggested to apply a logarithmic transform to the latter). Check whether the model residuals are correlated between bordering RLS with a Moran’s test and then model the same data with a conditional autoregressive model.

Reference

Ver Hoef, J.M., Peterson, E.E., Hooten, M.B., Hanks, E.M. and Fortin, M.-J. (2018) Spatial autoregressive models for statistical inference from ecological data. Ecological Monographs 88: 36-59.

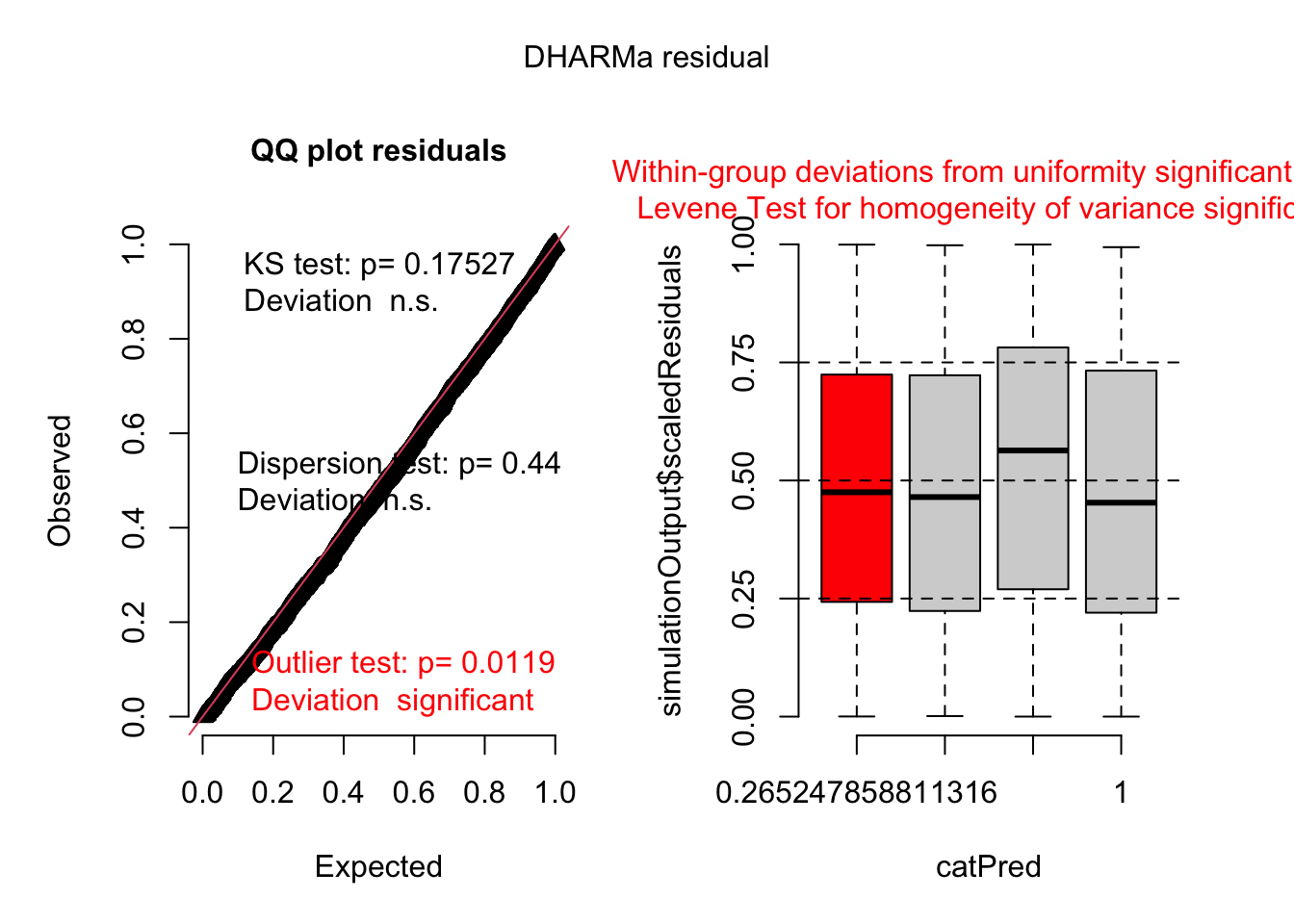

14 GLMM with spatial Gaussian process

Data

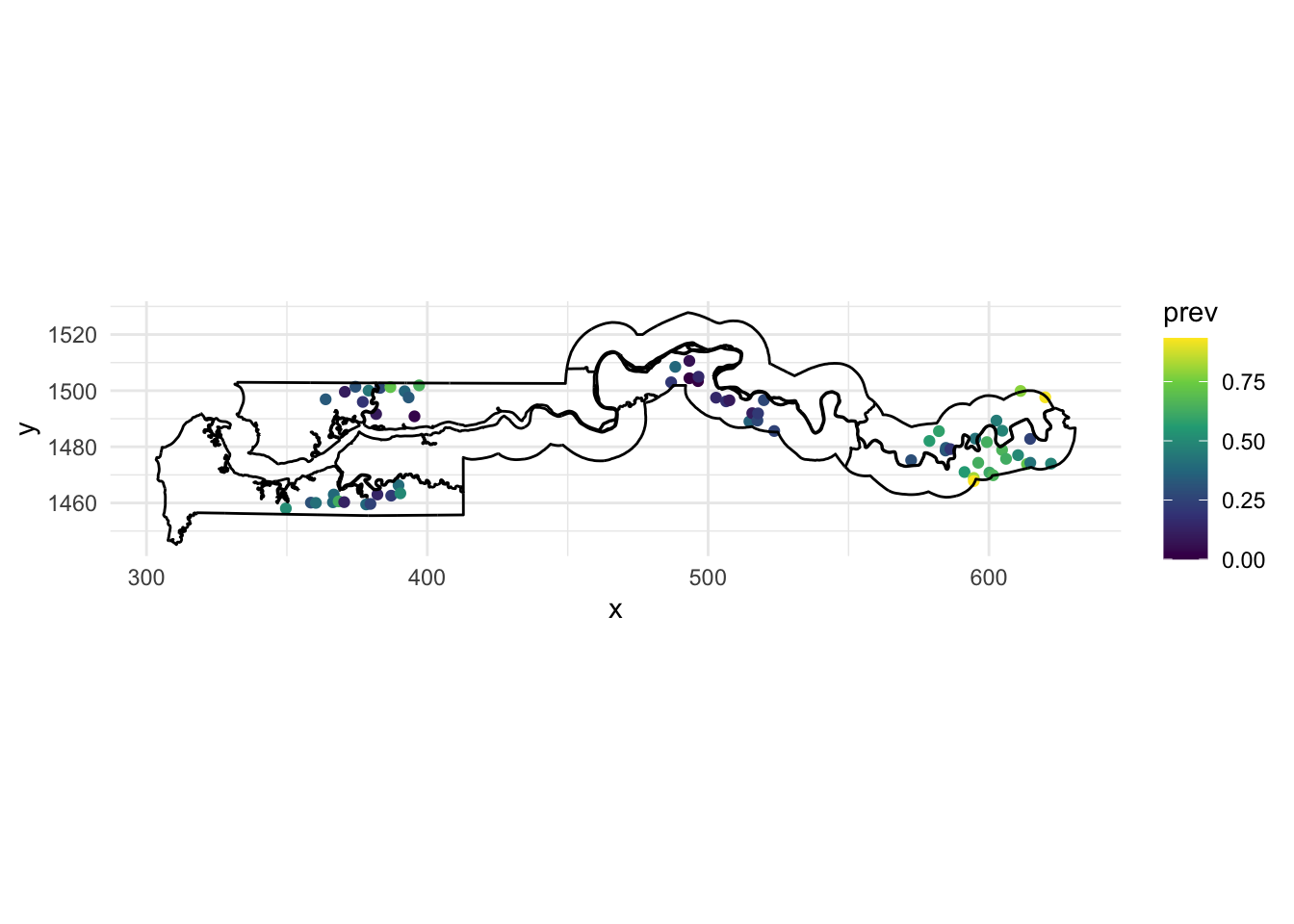

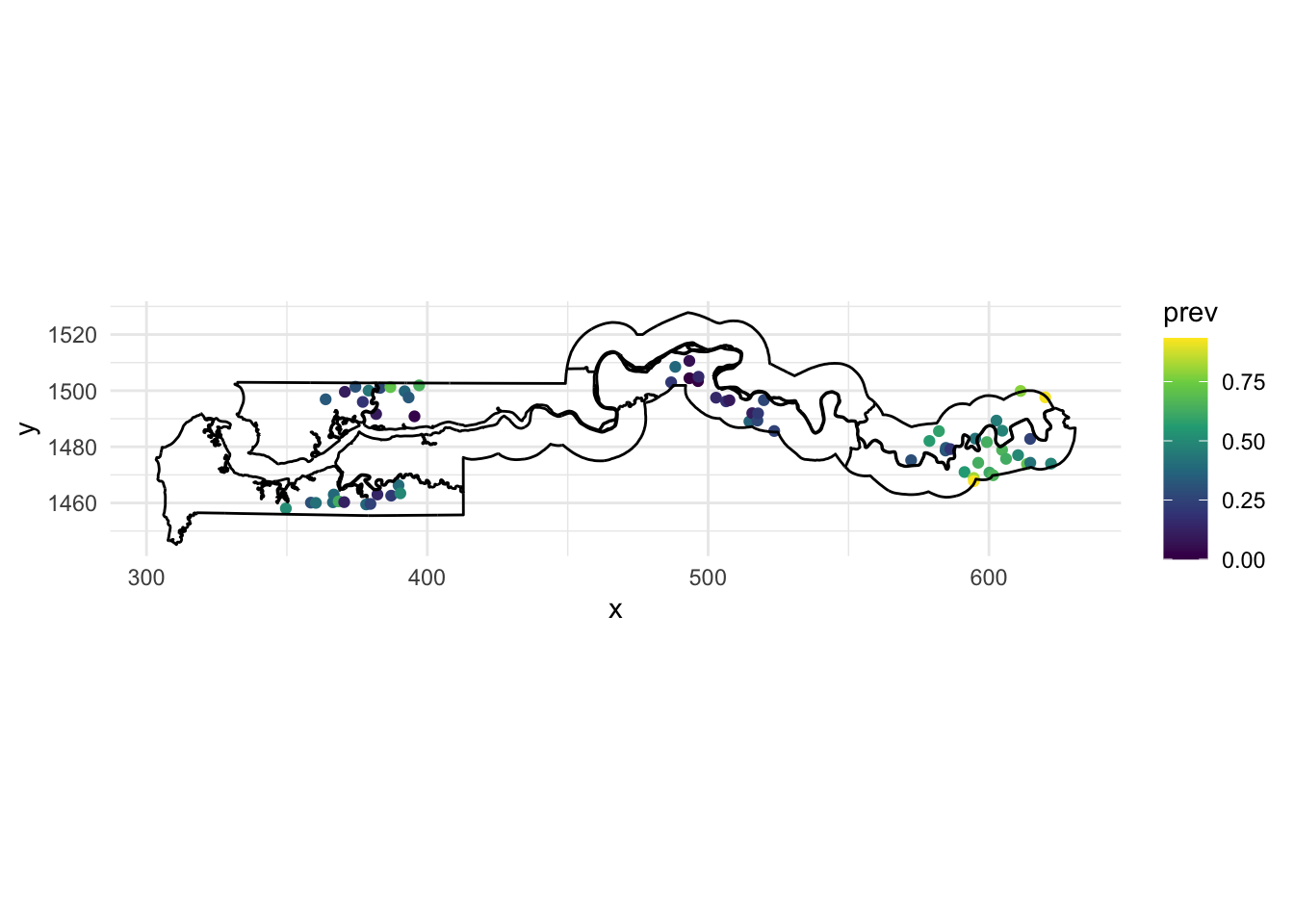

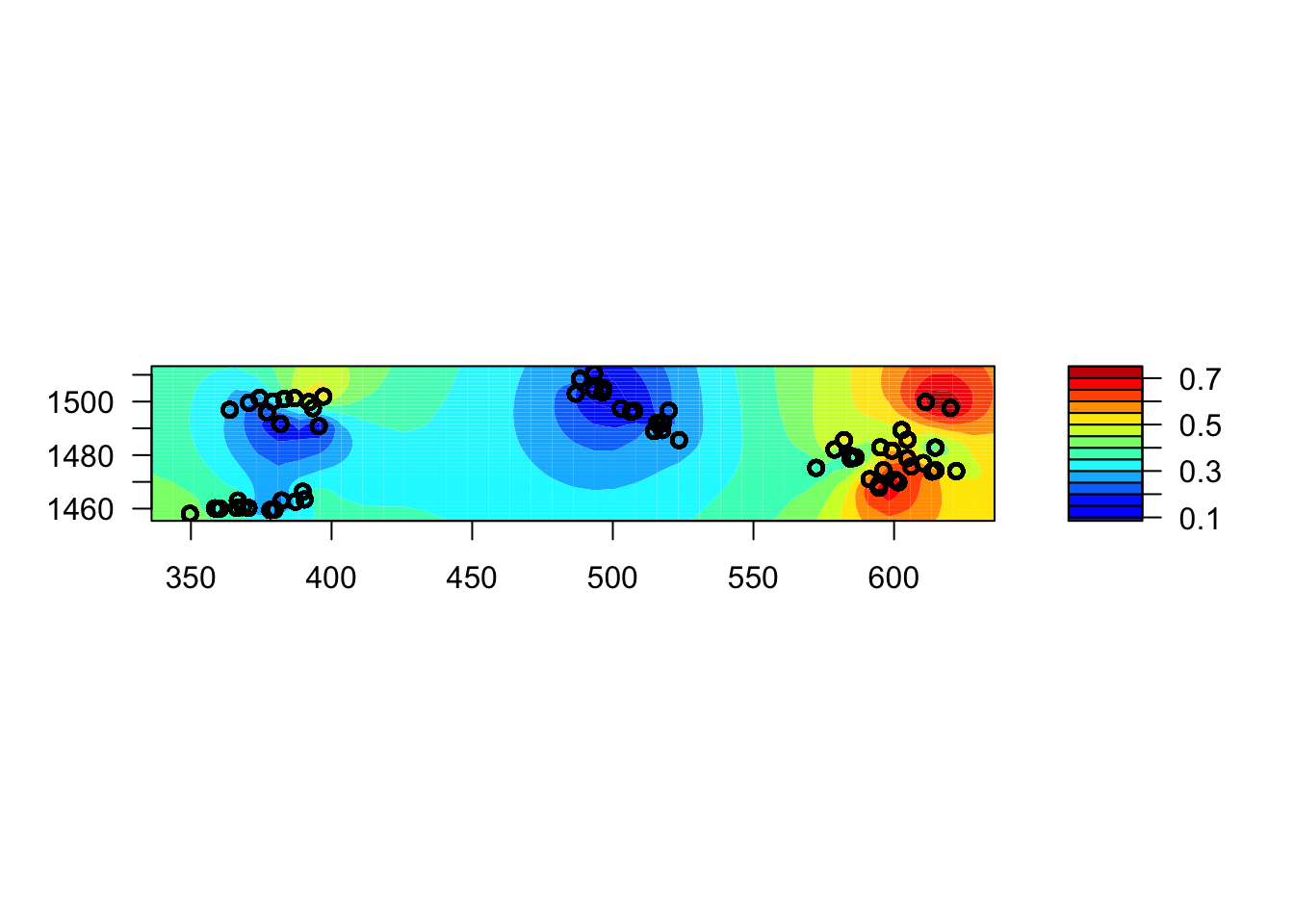

The gambia dataset found in the geoR package presents the results of a study of malaria prevalence among children of 65 villages in The Gambia. We will use a slightly transformed version of the data found in the file gambia.csv.

library(geoR)

gambia <- read.csv("data/gambia.csv")

head(gambia) id_village x y pos age netuse treated green phc

1 1 349.6313 1458.055 1 1783 0 0 40.85 1

2 1 349.6313 1458.055 0 404 1 0 40.85 1

3 1 349.6313 1458.055 0 452 1 0 40.85 1

4 1 349.6313 1458.055 1 566 1 0 40.85 1

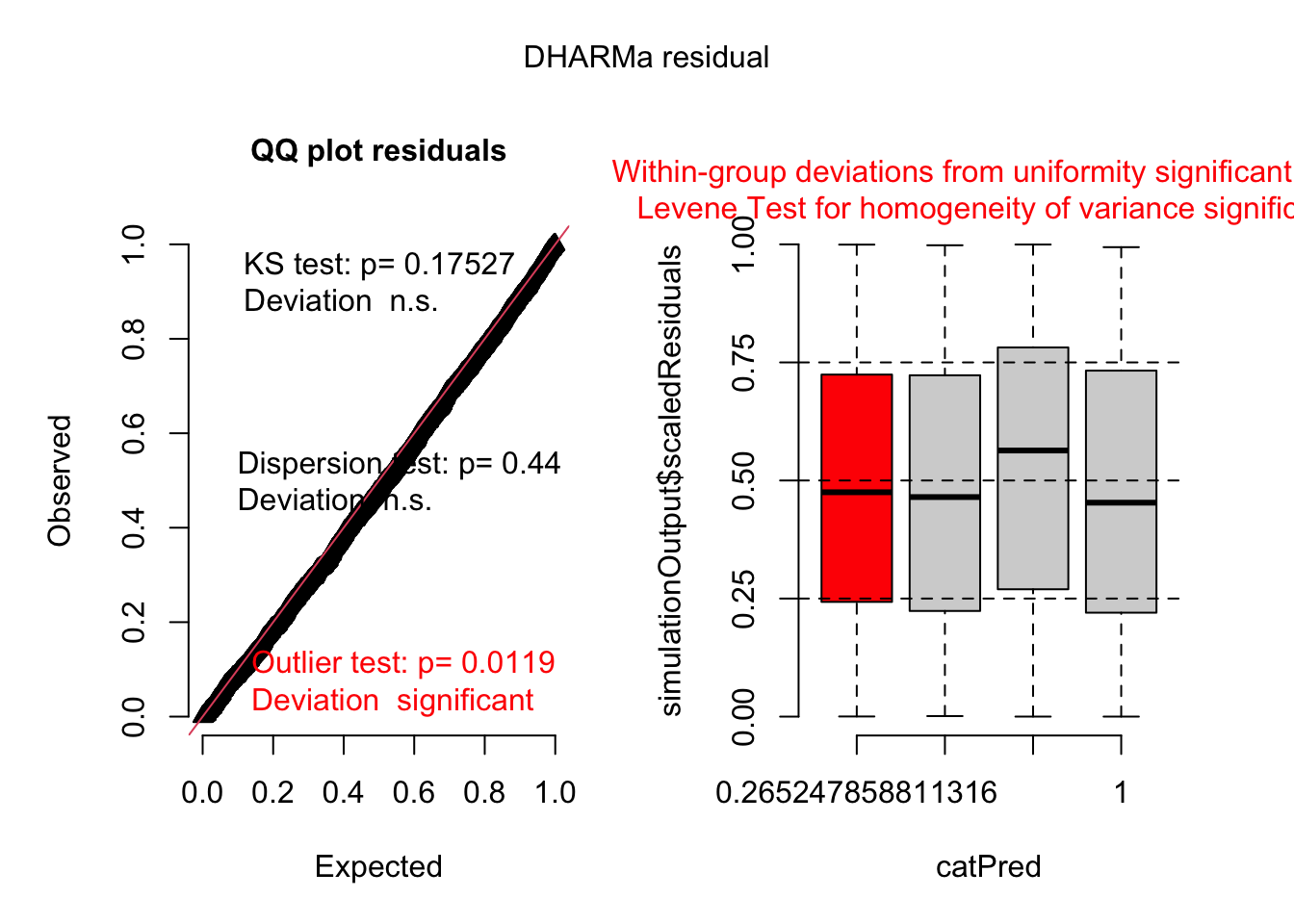

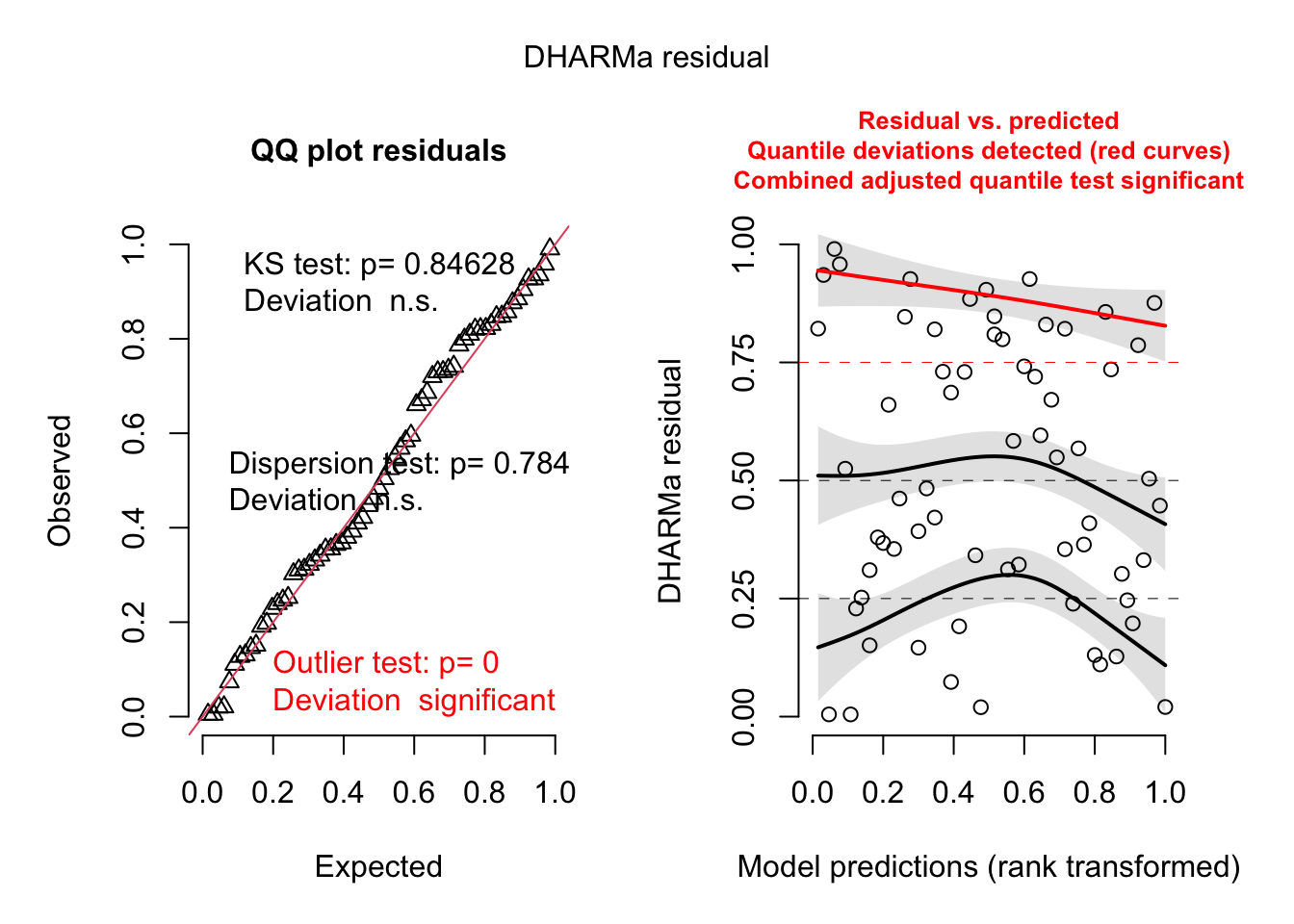

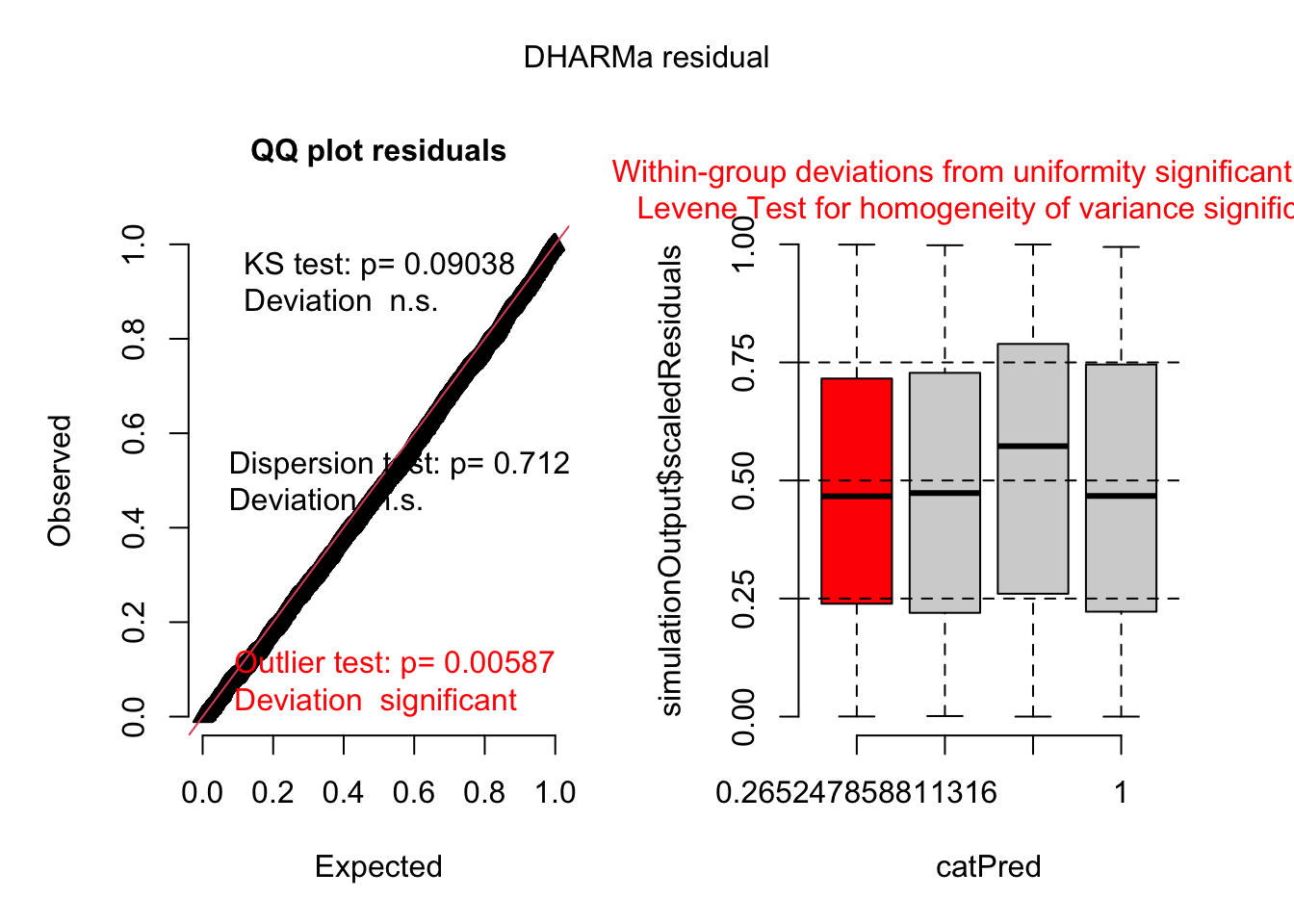

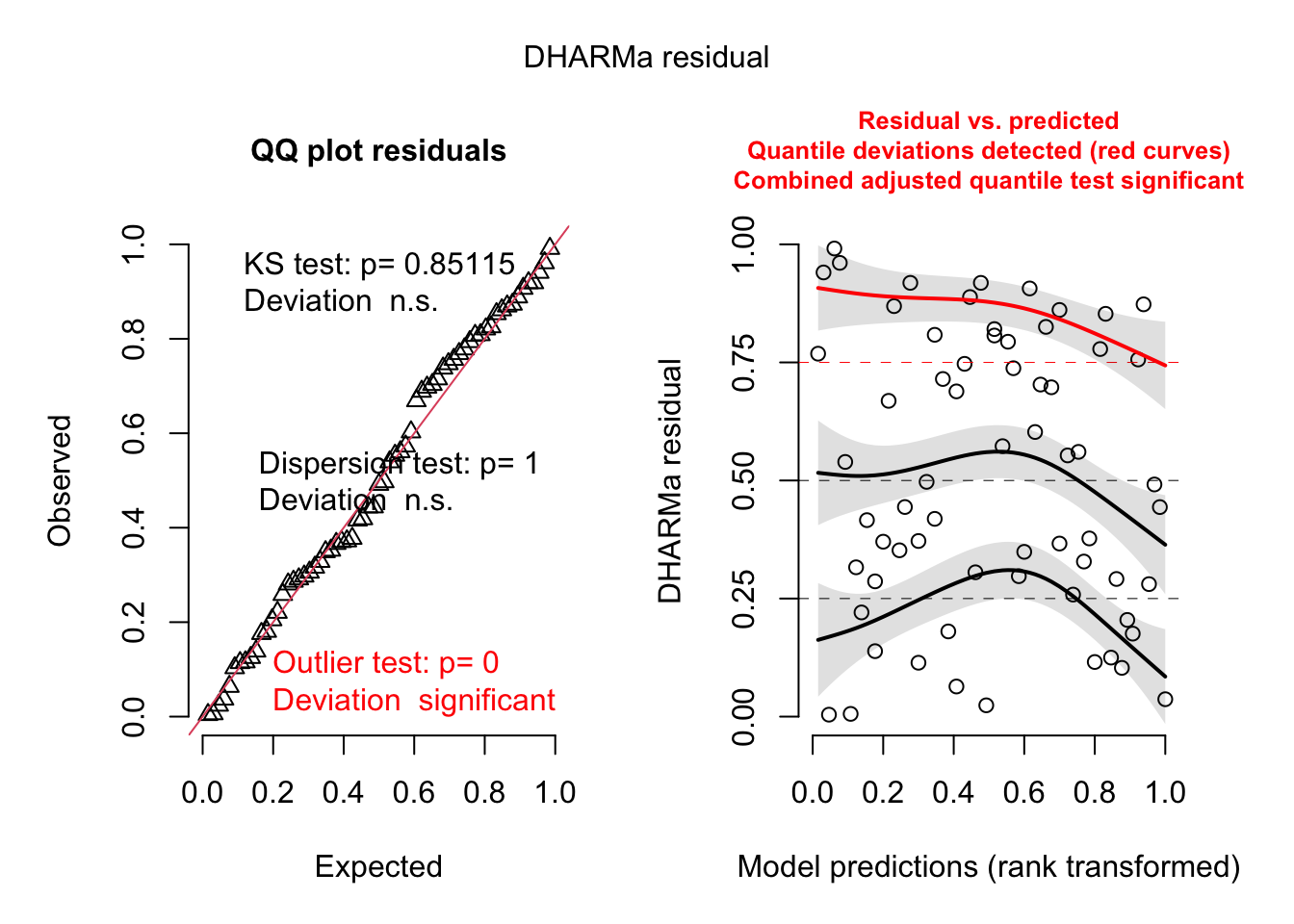

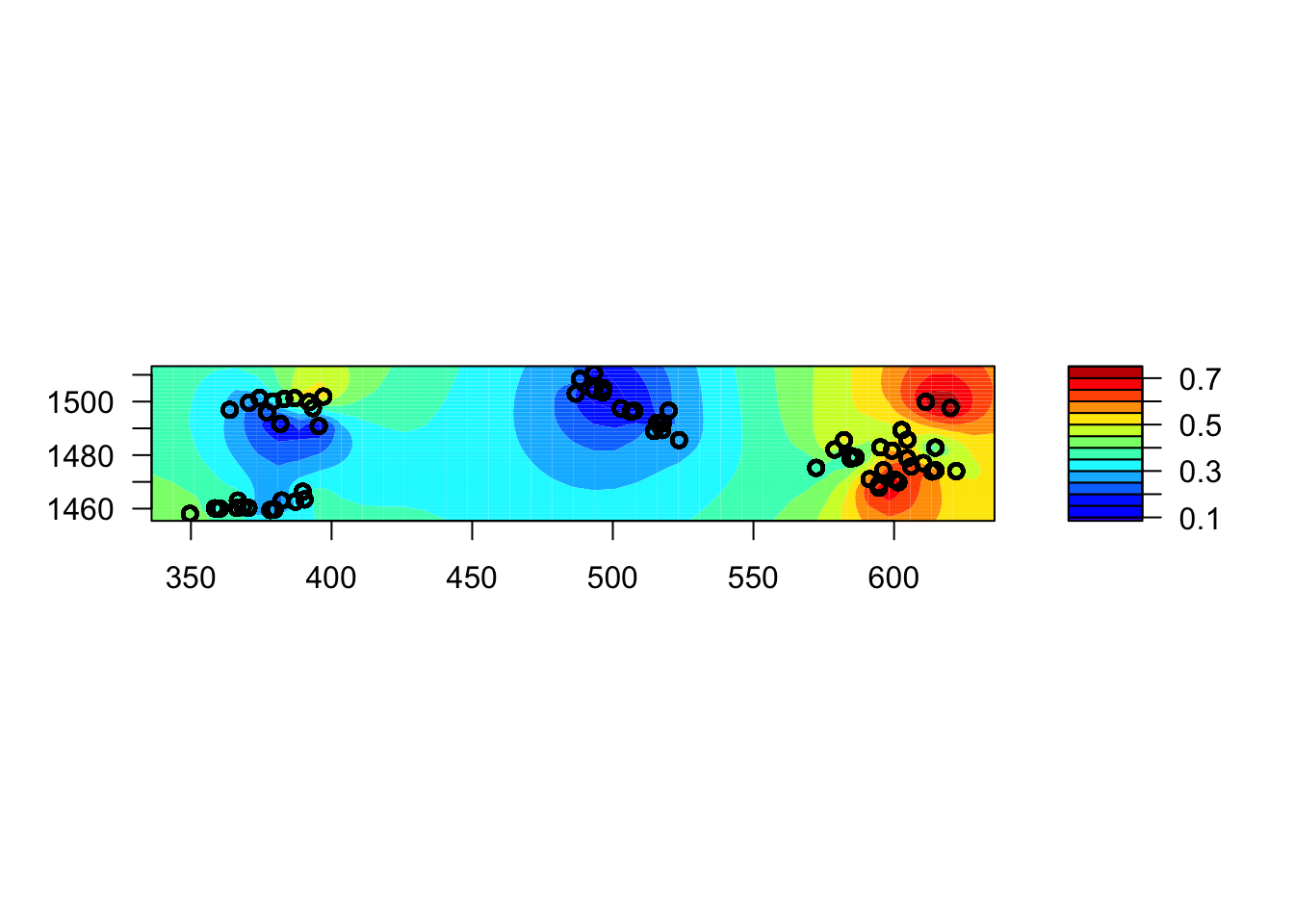

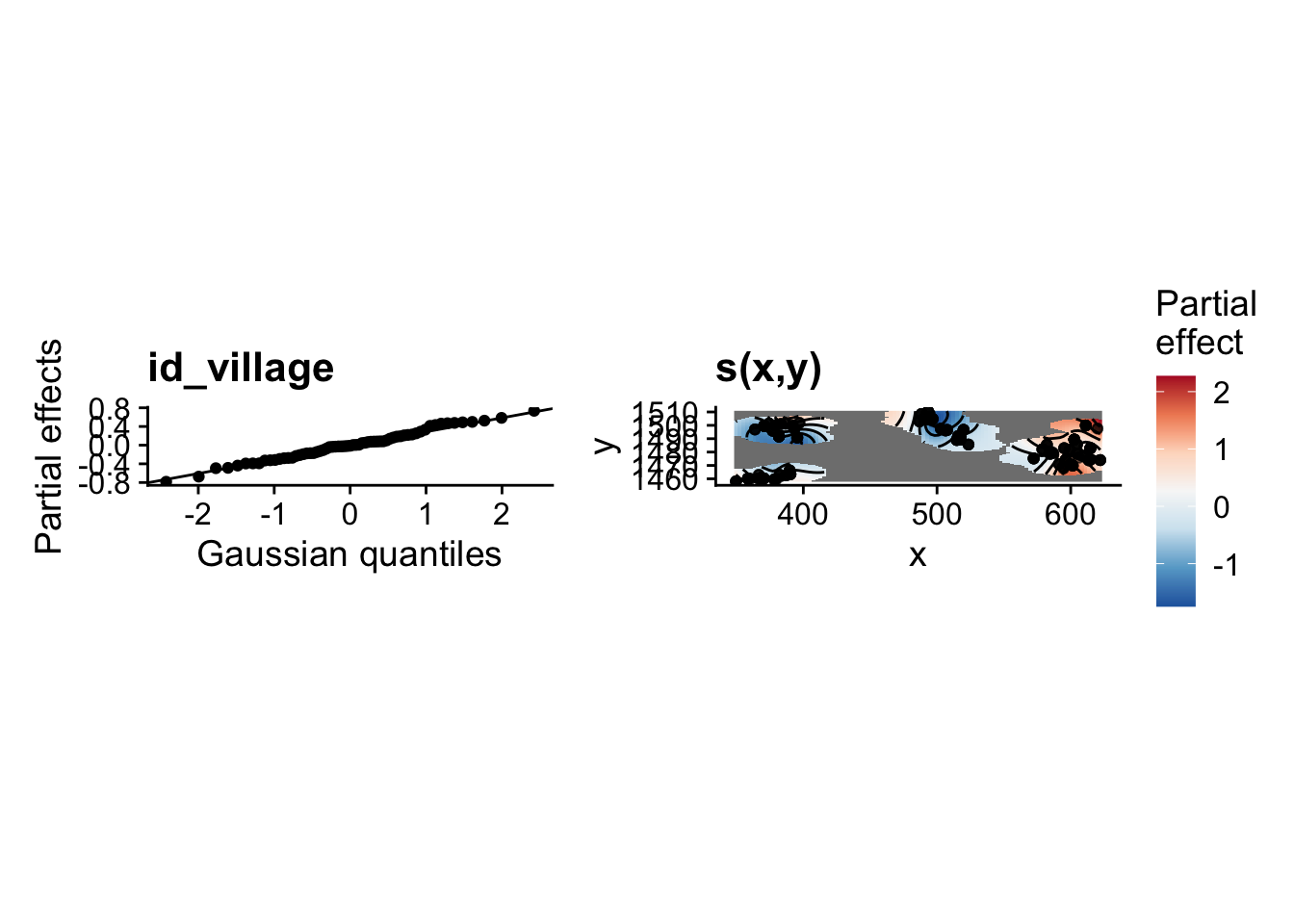

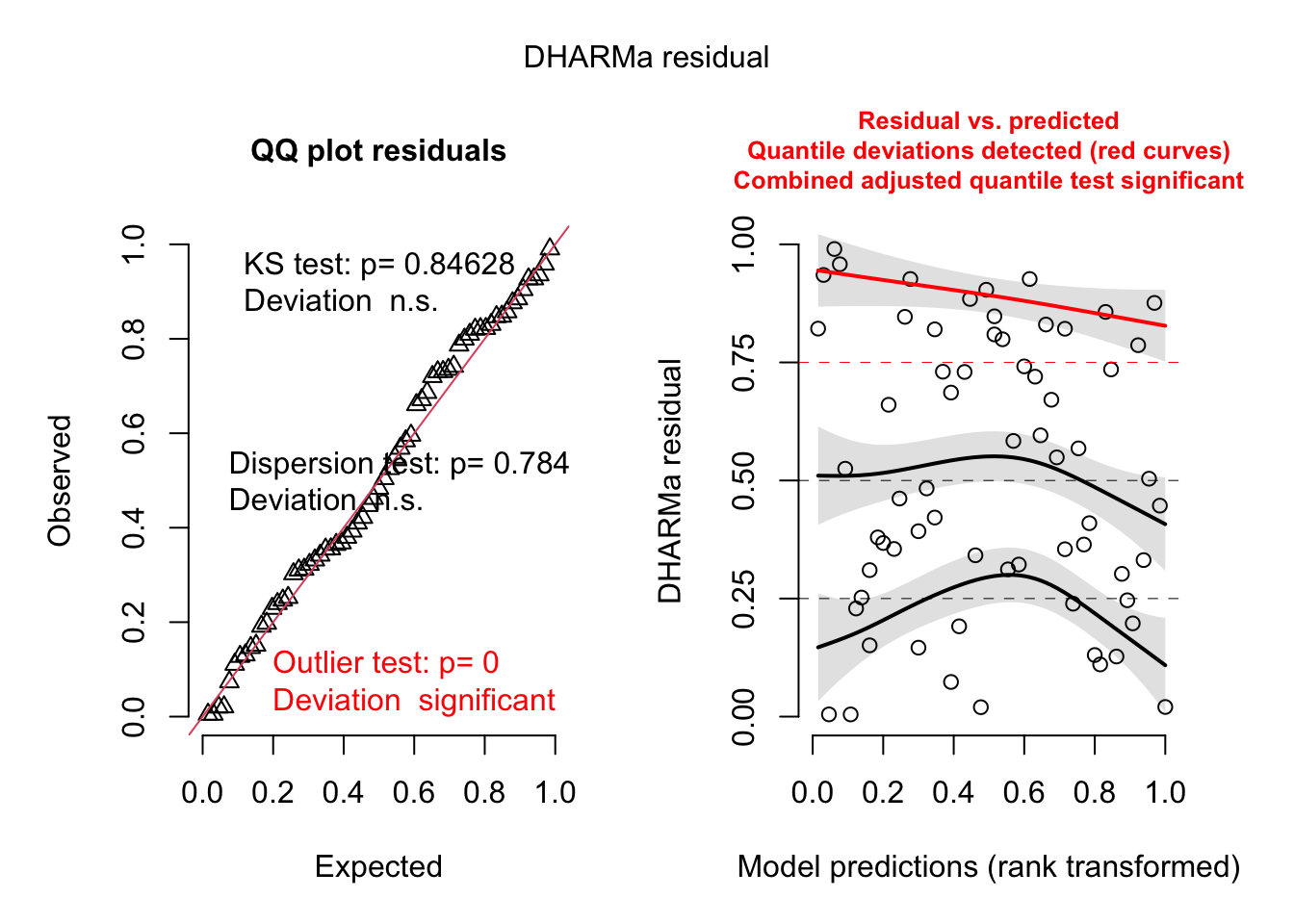

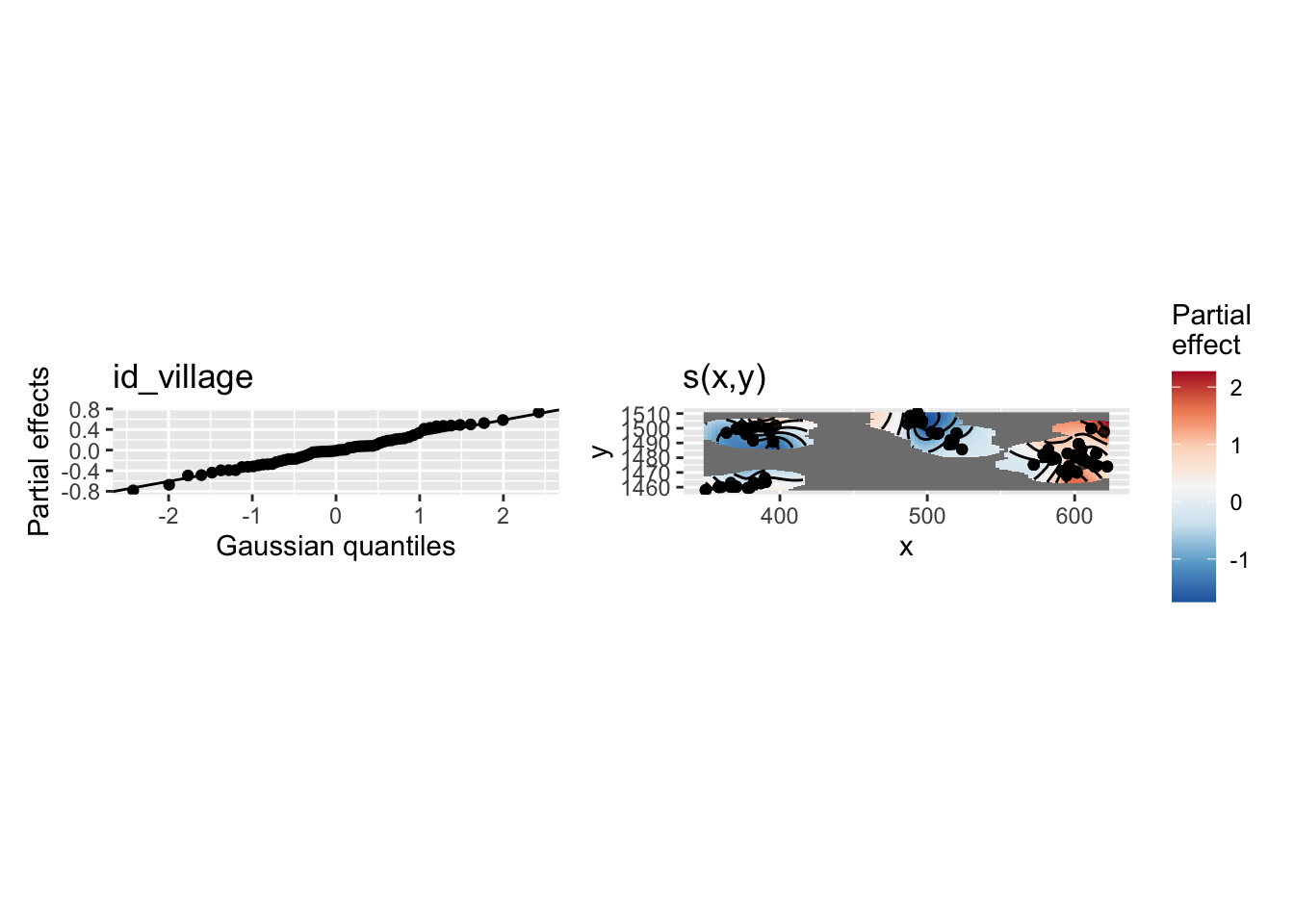

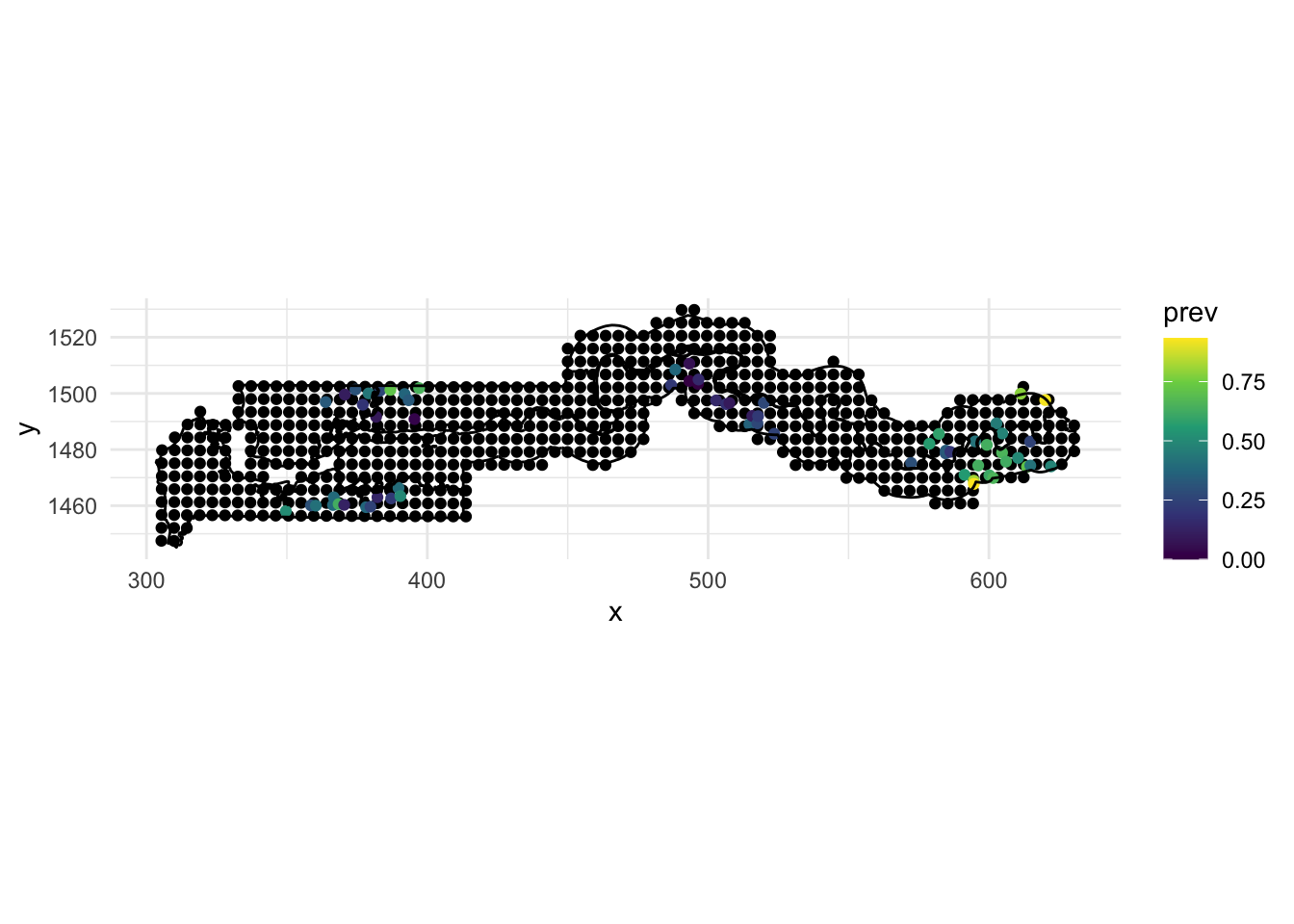

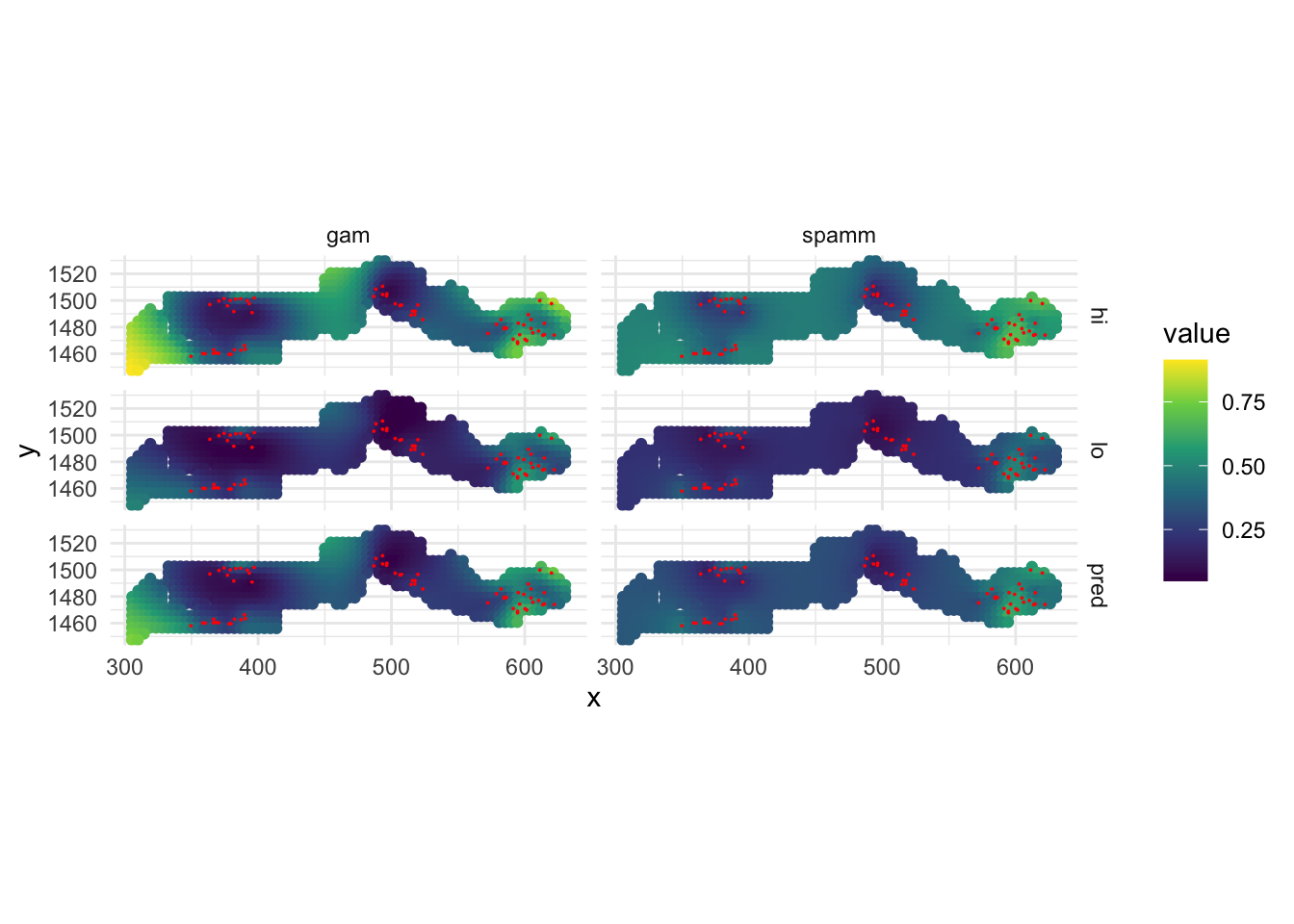

5 1 349.6313 1458.055 0 598 1 0 40.85 1